13 meilleurs outils ETL

À l’ère du Big Data, les entreprises sont inondées d’informations provenant d’une multitude de sources. Ces données, si elles sont correctement exploitées, peuvent fournir des informations inestimables qui orientent la prise de décision stratégique. Cependant, le défi réside dans l'extraction, la transformation et le chargement (ETL) efficaces de ces données dans un format prêt à être analysé. Les outils ETL sont la réponse à ce défi. Il s'agit de logiciels spécialement conçus pour prendre en charge les processus ETL, tels que l'extraction de données provenant de sources disparates, le nettoyage et le nettoyage des données pour obtenir une qualité supérieure et la consolidation du tout dans des entrepôts de données. Les outils ETL simplifient les stratégies de gestion des données et améliorent la qualité des données grâce à une approche standardisée, ce qui en fait un composant essentiel de toute organisation axée sur les données.

Qu'est-ce qu'un outil ETL ?

ETL, qui signifie Extract, Transform and Load, est un processus d'intégration de données qui combine des données provenant de plusieurs sources dans un magasin de données unique et cohérent qui est chargé dans un entrepôt de données ou un autre système cible. Le processus commence par l'extraction de données provenant de diverses sources, qui peuvent inclure des bases de données, des applications ou des fichiers. Ces données brutes sont ensuite temporairement stockées dans une zone de transit.

Dans la phase de transformation, les données brutes sont traitées et préparées pour leur utilisation prévue. Cela peut impliquer de nettoyer les données, de supprimer les doublons et de les convertir dans un format compatible avec le système cible. Les données transformées sont ensuite chargées dans le système cible, tel qu'un entrepôt de données. Ce processus est généralement automatisé et bien défini, permettant une intégration de données efficace et précise.

ETL est un composant crucial de l'entreposage de données et de la business intelligence, permettant aux organisations de consolider leurs données en un seul endroit à des fins d'analyse et de reporting. Il fournit un moyen systématique et précis d'analyser les données, garantissant que toutes les données de l'entreprise sont cohérentes et à jour. Le processus ETL a évolué au fil du temps, avec des outils ETL modernes offrant des fonctionnalités et des capacités plus avancées, telles que l'intégration de données en temps réel et le traitement des données dans le cloud.

Le besoin d’outils ETL

Dans le monde actuel axé sur les données, le besoin d’outils ETL est plus pressant que jamais. Les entreprises génèrent quotidiennement de grandes quantités de données et les processus ETL manuels ne sont plus réalisables. Les outils ETL automatisent les processus d'extraction, de transformation et de chargement, garantissant ainsi que les données sont exactes et prêtes à être analysées. Ils brisent les silos de données, permettant aux data scientists d'accéder et d'analyser facilement les données, les transformant ainsi en une business intelligence exploitable. Les outils ETL améliorent également la qualité des données en supprimant les incohérences et les anomalies, et simplifient le processus d'intégration des données, combinant de manière transparente les données provenant de diverses sources. Cela permet de gagner du temps, car le besoin d'interroger plusieurs sources de données est éliminé, ce qui accélère les processus de prise de décision.

Comment fonctionnent les outils ETL ?

Les outils ETL fonctionnent en trois étapes principales : extraction, transformation et chargement. Lors de la phase d'extraction, les données sont extraites de diverses sources, qui peuvent aller des bases de données et applications aux feuilles de calcul et au stockage dans le cloud. Ces données sont ensuite transformées, ce qui implique de les nettoyer, de les valider et de les reformater pour garantir qu'elles répondent aux normes de qualité nécessaires. La dernière étape est le chargement, où les données transformées sont chargées dans un entrepôt de données ou un autre système cible pour le stockage et l'analyse. Les outils ETL automatisent l'ensemble de ce processus, réduisant ainsi les erreurs et accélérant l'intégration des données. Ils fournissent également des interfaces graphiques pour des résultats plus rapides et plus simples que les méthodes traditionnelles de déplacement de données via des pipelines de données codés manuellement.

13 meilleurs outils ETL

- Intégrer.io

- Talend

- IBM Data Stage

- Intégrateur de données Oracle

- Fivétran

- Coupleur.io

- Colle AWS

- point

- skyvia

- Usine de données Azure

- Gestion des données SAS

- Flux de données Google Cloud

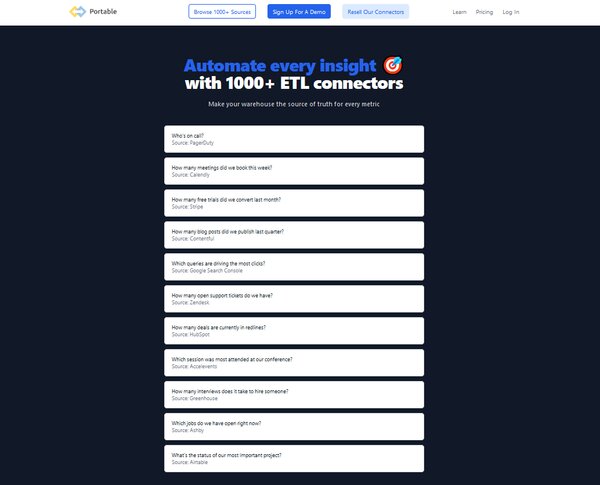

- Transférable

Comment choisir les meilleurs outils ETL ?

Le choix des bons outils ETL dépend de plusieurs facteurs. Tout d’abord, considérez la complexité de vos besoins en matière de données. Un excellent outil ETL doit être capable de déplacer et de transformer de grandes quantités de données rapidement et efficacement, avec un minimum d'effort. Il doit également prendre en charge plusieurs sources de données afin que vous puissiez facilement combiner des ensembles de données provenant de sources disparates. Une interface utilisateur intuitive est essentielle pour manipuler rapidement les données, configurer les paramètres et planifier des tâches. Tenez également compte de l’évolutivité de l’outil, de la complexité de vos exigences d’intégration de données et de votre budget. Différentes organisations peuvent avoir des besoins différents, c'est pourquoi le meilleur outil ETL peut varier en fonction de votre situation spécifique et de vos cas d'utilisation.

Outils ETL (gratuits et payants)

1. Intégrer.io

Integrate.io est une solution d'intégration de données leader qui fournit une plate-forme d'intégration d'entrepôt de données unifiée et low-code. Il offre une suite complète d'outils et de connecteurs pour prendre en charge l'ensemble de votre parcours de données. Avec son interface conviviale et ses fonctionnalités robustes, Integrate.io permet aux entreprises de consolider, traiter et préparer les données pour l'analyse, permettant ainsi une prise de décision éclairée.

Que fait Integrate.io ?

Integrate.io sert d'outil ETL basé sur le cloud qui permet la création de pipelines de données visualisés pour des flux de données automatisés sur un large éventail de sources et de destinations. Il fournit un environnement sans codage ni jargon, le rendant accessible aux utilisateurs techniques et non techniques. Integrate.io facilite la mise en œuvre d'une architecture basée sur les événements, le streaming de données en temps réel et la création d'API avec un minimum de codage, répondant ainsi à des défis tels que les pipelines de traitement de données rigides et les limitations d'évolutivité.

Fonctionnalités clés d’Integrate.io

Transformations de données faciles: Integrate.io simplifie vos processus ETL et ELT en offrant une interface utilisateur simple par glisser-déposer et plus d'une douzaine de transformations - comme trier, joindre, filtrer, sélectionner, limiter, cloner, etc.

Création simple d'un workflow pour définir les dépendances entre les tâches: Cette fonctionnalité permet aux utilisateurs de définir facilement la séquence et les dépendances des tâches de traitement de données, garantissant un flux de données efficace et sans erreur.

API REST: Integrate.io fournit une solution API REST complète, permettant aux utilisateurs de créer des API avec un minimum de codage et un déploiement flexible.

Intégrations Salesforce à Salesforce: Cette fonctionnalité permet aux utilisateurs d'extraire des données Salesforce, de les transformer et de les réinjecter dans Salesforce, offrant un avantage unique aux entreprises qui s'appuient fortement sur les données Salesforce pour le CRM et d'autres opérations commerciales.

Sécurité et conformité des données: Integrate.io assure la sécurité de vos données avec des fonctionnalités de chiffrement natives et le respect des réglementations en matière de protection des données.

Diverses options de source de données et de destination: Integrate.io prend en charge un large éventail de sources et de destinations de données, offrant flexibilité et polyvalence dans l'intégration des données.

Plans tarifaires Integrate.io

Integrate.io propose trois plans tarifaires principaux : le plan Entreprise, le plan Professionnel et le plan Starter.

Plan d'entreprise: Ce plan est conçu pour les grandes entreprises ayant des besoins étendus en matière d'intégration de données. Il offre des fonctionnalités avancées et un support premium. Le prix de ce plan est personnalisé et peut être obtenu en contactant directement Integrate.io.

Plan professionnel: Ce plan, au prix de 25,000 XNUMX $ par an, convient aux entreprises de taille moyenne. Il offre un équilibre entre fonctionnalités avancées et prix abordable.

Testeur: Ce plan, au prix de 15,000 XNUMX $ par an, est idéal pour les petites entreprises ou les startups ayant des besoins de base en intégration de données. Il offre des fonctionnalités essentielles à un prix abordable.

Integrate.io accepte les cartes de débit et de crédit, ainsi que les virements bancaires pour les paiements.

2. Talend

Talend est une solution complète de gestion de données sur laquelle des milliers d'organisations s'appuient pour transformer leurs données en informations commerciales exploitables. Il s'agit d'une plateforme flexible et fiable qui prend en charge les besoins de gestion de données de bout en bout dans l'ensemble d'une organisation, de l'intégration à la livraison. Talend peut être déployé sur site, dans le cloud ou dans un environnement hybride, ce qui en fait un outil polyvalent pour toute architecture de données. Il est conçu pour offrir une valeur claire et prévisible tout en répondant aux besoins de sécurité et de conformité.

Que fait Talend ?

Talend fournit des outils de développement et de gestion unifiés pour intégrer et traiter toutes vos données. Il s'agit d'une plate-forme d'intégration logicielle qui propose des solutions pour l'intégration des données, la qualité des données, la gestion des données, la préparation des données et le big data. Talend aide les organisations à prendre des décisions en temps réel et à s'orienter davantage vers les données en rendant les données plus accessibles, en améliorant leur qualité et en les déplaçant rapidement vers les systèmes cibles. C'est le seul outil ETL doté de tous les plugins pour s'intégrer facilement à l'écosystème Big Data.

Principales fonctionnalités de Talend

Intégration Des Données: Talend offre de solides capacités d'intégration de données. Il fournit une gamme de modèles SQL pour simplifier les tâches les plus courantes de requête et de mise à jour de données, de création et de modification de schémas et de gestion de données.

Qualité des données: Talend garantit la qualité des données en fournissant des fonctionnalités de profilage, de nettoyage et de surveillance des données. Il aide les entreprises à améliorer la qualité de leurs données, en les rendant plus accessibles et rapidement transférées vers les systèmes cibles.

Gouvernance des données: Talend prend en charge la gouvernance des données en fournissant des fonctionnalités pour le catalogage des données, le traçage des données et la confidentialité des données. Il aide les organisations à maintenir la conformité aux réglementations en matière de données et à assurer la sécurité de leurs données.

Plateforme Low-Code: Talend est une plateforme low-code qui simplifie le processus de développement de workflows d'intégration de données. Il fournit un concepteur visuel qui facilite la création et la gestion de pipelines de données.

Évolutivité: Talend est conçu pour évoluer de manière transparente à mesure que les besoins en données augmentent. Il peut gérer de gros volumes de données et des tâches de traitement de données complexes, ce qui en fait un investissement pérenne pour les entreprises.

Intégration Cloud et Big Data: Talend prend en charge l'intégration avec diverses plateformes cloud et technologies Big Data. Il fournit des connecteurs vers des applications packagées, des bases de données, des mainframes, des fichiers, des services Web, etc.

Plans tarifaires Talend

Talend propose plusieurs plans tarifaires pour répondre aux différents besoins de l'entreprise. Les forfaits disponibles comprennent :

Plateforme de gestion des données: Ce plan offre des fonctionnalités complètes d’intégration et de gestion des données. Il est conçu pour les entreprises qui ont besoin d'intégrer, de nettoyer et de gérer des données provenant de diverses sources.

Plateforme Big Data: Ce plan est conçu pour les entreprises qui doivent gérer de gros volumes de données. Il offre des fonctionnalités pour l'intégration du Big Data, la qualité des données et la gouvernance des données.

Structure de données: Il s'agit du plan le plus complet de Talend. Il combine les fonctionnalités de la plateforme de gestion de données et de la plateforme Big Data et ajoute des fonctionnalités supplémentaires pour l'intégration d'applications et d'API.

Pour obtenir des informations sur les prix, les utilisateurs doivent contacter l’équipe commerciale.

3. IBM Data Stage

IBM DataStage se présente comme un outil ETL robuste et polyvalent, conçu pour faciliter et rationaliser le processus d'intégration des données sur divers systèmes. Ses capacités sont ancrées dans une puissante architecture de traitement parallèle, qui garantit évolutivité et hautes performances pour les opérations gourmandes en données. Dans le cadre d'IBM Cloud Pak for Data as a Service, DataStage propose une solution complète qui prend en charge un large éventail de tâches d'intégration de données, des plus simples aux plus complexes. Il est conçu pour fonctionner de manière transparente sur site ou dans le cloud, offrant ainsi aux entreprises une flexibilité dans la gestion de leurs flux de données. La connectivité d'entreprise et l'extensibilité de la plateforme en font un choix approprié pour les organisations qui cherchent à exploiter leurs données pour des analyses approfondies et des applications d'IA, garantissant ainsi qu'elles peuvent fournir des données de qualité de manière fiable aux parties prenantes.

Que fait IBM DataStage ?

IBM DataStage excelle dans l'extraction de données à partir de plusieurs sources, leur transformation pour répondre aux exigences de l'entreprise et leur chargement dans des systèmes cibles, qu'il s'agisse de bases de données sur site, de référentiels cloud ou d'entrepôts de données. Il est conçu pour gérer une vaste gamme de formats et de structures de données, permettant aux entreprises d'intégrer facilement des sources de données disparates. Les puissantes capacités de transformation de l'outil permettent un traitement de données complexe, y compris le nettoyage et la surveillance des données, afin de garantir que les données fournies sont de la plus haute qualité. Grâce à son moteur de traitement parallèle, DataStage peut traiter efficacement de gros volumes de données, ce qui en fait une solution idéale pour les entreprises confrontées aux défis du Big Data. De plus, sa nature ouverte et extensible permet la personnalisation et l'intégration avec d'autres plateformes d'IA et d'analyse, offrant ainsi une expérience d'intégration de données transparente qui prend en charge un large éventail d'initiatives basées sur les données.

Principales fonctionnalités d'IBM DataStage

Traitement parallèle: IBM DataStage exploite un moteur de traitement parallèle hautes performances qui permet une gestion efficace de gros volumes de données, réduisant considérablement le temps requis pour les tâches d'intégration de données.

Connectivité d'entreprise: L'outil offre des options de connectivité étendues, permettant une intégration transparente avec une multitude de systèmes, de bases de données et d'applications d'entreprise, facilitant ainsi un écosystème de données unifié.

Compatibilité Cloud: DataStage est conçu pour fonctionner sur n'importe quel environnement cloud, offrant flexibilité et évolutivité aux entreprises cherchant à exploiter les ressources cloud pour leurs besoins d'intégration de données.

Nettoyage et surveillance des données: Il comprend des fonctionnalités permettant de nettoyer et de surveiller les données, garantissant que les informations traitées et fournies sont exactes, cohérentes et de haute qualité.

Extensibilité: La plateforme est ouverte et extensible, permettant la personnalisation et l'intégration avec d'autres outils de données et d'IA, ce qui améliore ses capacités pour répondre aux exigences commerciales spécifiques.

Intégration des données de bout en bout: DataStage fournit une solution complète pour l'ensemble du cycle de vie de l'intégration des données, de l'extraction et de la transformation au chargement, ce qui en fait un guichet unique pour toutes les activités d'intégration de données.

Plans tarifaires IBM DataStage

IBM DataStage propose une variété de plans tarifaires adaptés pour répondre aux besoins de différentes organisations, des petites entreprises aux grandes entreprises. Chaque plan est conçu pour fournir des fonctionnalités et des capacités spécifiques, garantissant que les entreprises peuvent sélectionner l'option qui correspond le mieux à leurs exigences et à leur budget en matière d'intégration de données. Les utilisateurs doivent contacter l'équipe commerciale pour une réunion d'information sur les prix.

IBM DataStage accepte les cartes de débit et de crédit pour les paiements.

4. Intégrateur de données Oracle

Oracle Data Integrator (ODI) est un outil ETL et une plateforme complète d'intégration de données qui répond à un large éventail de besoins d'intégration de données. Il est conçu pour gérer des charges par lots élevées et à hautes performances, des processus d'intégration déclenchés par des événements et à flux continu, ainsi que des services de données compatibles SOA. La dernière version, ODI 12c, offre une productivité supérieure aux développeurs et une expérience utilisateur améliorée avec une interface utilisateur déclarative repensée basée sur les flux. Il offre également une intégration plus approfondie avec Oracle GoldenGate, offrant une prise en charge complète du Big Data et un parallélisme supplémentaire lors de l'exécution des processus d'intégration de données.

Que fait Oracle Data Integrator ?

Oracle Data Integrator est une offre d'intégration de données stratégique d'Oracle qui fournit une architecture flexible et hautes performances pour l'exécution des processus d'intégration de données. Il est conçu pour gérer des charges par lots élevées et à hautes performances, des processus d'intégration déclenchés par des événements et à flux continu, ainsi que des services de données compatibles SOA. ODI 12c, la dernière version, offre une productivité supérieure aux développeurs et une expérience utilisateur améliorée avec une interface utilisateur déclarative repensée basée sur les flux. Il offre également une intégration plus approfondie avec Oracle GoldenGate, offrant une prise en charge complète du Big Data et un parallélisme supplémentaire lors de l'exécution des processus d'intégration de données.

Principales fonctionnalités d'Oracle Data Integrator

Architecture haute performance: Oracle Data Integrator propose une architecture flexible et performante qui permet des processus d'intégration de données efficaces. Il prend en charge les chargements par lots de gros volumes et hautes performances, les processus d'intégration déclenchés par des événements et à flux continu, ainsi que les services de données compatibles SOA.

Amélioration de l'expérience de l'utilisateur: La dernière version, ODI 12c, offre une expérience utilisateur améliorée avec une interface utilisateur déclarative repensée basée sur les flux. Cette interface améliore la productivité des développeurs et facilite la gestion et l'exécution des processus d'intégration de données.

Intégration approfondie avec Oracle GoldenGate: Oracle Data Integrator offre une intégration plus approfondie avec Oracle GoldenGate. Cette intégration permet une prise en charge complète du Big Data et un parallélisme supplémentaire lors de l'exécution des processus d'intégration de données.

Prise en charge du Big Data: Oracle Data Integrator offre une prise en charge complète du Big Data. Il s'intègre parfaitement aux plates-formes Big Data telles que Hadoop et Spark, permettant un traitement et une analyse efficaces de grands ensembles de données.

Développement collaboratif et contrôle de version: Oracle Data Integrator offre des fonctionnalités de développement collaboratif et de contrôle de version. Ces fonctionnalités facilitent les projets ETL en équipe et garantissent que toutes les modifications sont suivies et gérées efficacement.

Fonctionnalités de sécurité robustes: Oracle Data Integrator offre des fonctionnalités de sécurité robustes et s'intègre aux cadres de sécurité existants. Cela garantit la confidentialité des données et le respect des diverses réglementations en matière de protection des données.

Plans tarifaires d'Oracle Data Integrator

Oracle Data Integrator propose une variété de plans tarifaires pour répondre aux différents besoins des utilisateurs. La tarification est basée sur un modèle de licence par cœur, avec des abonnements annuels allant de plusieurs milliers à plusieurs dizaines de milliers de dollars par an. Le coût exact dépend du nombre de cœurs requis, des options de déploiement (cloud ou sur site) et des fonctionnalités supplémentaires nécessaires. Par exemple, un déploiement cloud de base avec 2 cœurs pourrait coûter environ 5,000 16 $ par an, tandis qu'un déploiement sur site plus important avec 50,000 cœurs et des fonctionnalités avancées pourrait coûter plus de XNUMX XNUMX $ par an.

Oracle Data Integrator accepte les cartes de débit et de crédit, PayPal et les virements bancaires pour les paiements.

5. Fivétran

Fivetran est une plateforme de transfert de données automatisée de premier plan conçue pour rationaliser le processus d'intégration et de centralisation des données. Il s'agit d'un outil ETL robuste qui permet aux entreprises de réaliser des analyses en libre-service, de créer des solutions de données personnalisées et de passer moins de temps à intégrer des systèmes. Fivetran est une plateforme parfaite pour les ingénieurs, les analystes et les développeurs qui cherchent à centraliser les données pour les rapports, les analyses et la construction avec des données.

Que fait Fivetran ?

Fivetran est un pipeline de données basé sur le cloud qui automatise le processus d'extraction de données à partir de diverses sources, leur transformation dans un format utilisable et leur chargement dans un entrepôt de données pour analyse. Il supprime les goulots d'étranglement dans les processus de données sans compromettre la conformité, ce qui en fait une solution idéale pour les entreprises qui ont besoin d'étendre leur plateforme de données pour prendre en charge des besoins personnalisés. Que vous soyez un ingénieur cherchant à passer moins de temps à intégrer des systèmes, un analyste travaillant avec des outils SQL ou BI, ou un développeur construisant avec des données, l'API et les webhooks de Fivetran en font un outil polyvalent pour tous vos besoins en données.

Caractéristiques clés de Fivetran

Intégration automatisée des données: Fivetran simplifie le processus d'intégration des données en automatisant l'extraction, la transformation et le chargement des données provenant de diverses sources dans un entrepôt de données.

Analyse en libre-service: Fivetran permet aux entreprises de réaliser des analyses en libre-service en supprimant les goulots d'étranglement dans les processus de données, permettant ainsi une analyse des données et une prise de décision plus efficaces.

Solutions de données personnalisées: Avec Fivetran, les entreprises peuvent étendre leur plateforme de données pour prendre en charge des besoins personnalisés, offrant flexibilité et adaptabilité dans la gestion des données.

API et Webhooks: Fivetran propose des API et des webhooks, ce qui en fait une plate-forme parfaite pour les développeurs qui construisent avec des données.

Une conformité sans compromis: Fivetran garantit la conformité des données sans compromettre l'efficacité des processus de données, offrant ainsi aux entreprises une tranquillité d'esprit.

Prise en charge de différents types d'utilisateurs: Que vous soyez ingénieur, analyste ou développeur, Fivetran répond à vos besoins en données, ce qui en fait un outil polyvalent pour différents types d'utilisateurs.

Plans tarifaires Fivetran

Fivetran propose quatre plans tarifaires différents : plan gratuit, plan de démarrage, plan standard et plan d'entreprise. Pour connaître le prix de chaque plan, les utilisateurs doivent contacter l'équipe commerciale.

Plan gratuit: Le plan gratuit est une offre de base qui permet aux utilisateurs de découvrir les fonctionnalités de base de Fivetran.

Testeur: Le plan Starter comprend tout le plan gratuit, avec des fonctionnalités et des capacités supplémentaires pour des besoins d'intégration de données plus complets.

standard plan: Le forfait Standard comprend tout le forfait Starter, plus un nombre illimité d'utilisateurs, des synchronisations de 15 minutes, des connecteurs de base de données et un accès à l'API REST de Fivetran.

Plan d'entreprise: Le plan Entreprise comprend tout le plan Standard, plus des connecteurs de base de données d'entreprise, des synchronisations en 1 minute, des rôles et un support granulaires pour les équipes, une gouvernance avancée des données, des options avancées de sécurité et de résidence des données, ainsi qu'un support prioritaire.

Fivetran accepte les cartes de débit et de crédit pour les paiements.

6. Coupleur.io

Coupler.io est une plateforme tout-en-un d'analyse et d'automatisation de données conçue pour rationaliser le processus de collecte, de transformation et d'automatisation des données. Il permet aux entreprises de prendre des décisions basées sur les données en fournissant un point de vérité unique entre diverses sources de données. Avec son interface conviviale et ses fonctionnalités robustes, Coupler.io simplifie la tâche complexe d'analyse des données, permettant aux entreprises de se concentrer sur l'obtention d'informations précieuses à partir de leurs données.

Que fait Coupler.io ?

Coupler.io sert d'outil d'intégration qui synchronise les données entre différents services selon un calendrier. Il permet aux entreprises d'exporter et de combiner facilement les données des applications qu'elles utilisent, en connectant leurs applications métier à des feuilles de calcul, des feuilles de calcul, des bases de données ou des outils de visualisation de données en quelques minutes. Coupler.io propose plus de 200 intégrations, permettant aux entreprises de collecter et d'analyser des données en un seul endroit. Il fournit également un module de transformation qui permet aux utilisateurs de prévisualiser, transformer et structurer leurs données avant de les déplacer vers la destination. Coupler.io automatise également la gestion des données avec des webhooks, en intégrant les importateurs dans les flux de travail internes pour informer les systèmes de l'actualisation des données d'exécution dans les applications ou en lançant automatiquement les importations de données.

Caractéristiques principales de Coupler.io

Intégration Des Données: Coupler.io fournit une fonctionnalité d'intégration de données robuste qui permet aux entreprises de connecter leurs applications à diverses sources de données, leur permettant ainsi de collecter et d'analyser des données en un seul endroit.

Transformation des données: Avec le module Transformer, les utilisateurs peuvent prévisualiser, transformer et structurer leurs données directement dans Coupler.io avant de les déplacer vers la destination. Cette fonctionnalité permet aux entreprises de se concentrer sur les données qui comptent le plus pour elles.

Automation: Coupler.io automatise la gestion des données avec des webhooks, en intégrant les importateurs dans les flux de travail internes pour informer les systèmes de l'exécution, actualiser les données dans les applications ou lancer automatiquement les importations de données.

Planification: Coupler.io fournit des options de planification pour automatiser le processus d'actualisation des données. Les utilisateurs peuvent définir des intervalles spécifiques pour que l'outil mette automatiquement à jour les données importées, garantissant ainsi que les rapports ou les analyses sont toujours à jour.

Prise en charge de divers types de données: Coupler.io prend en charge différents types de données, notamment des nombres, des dates, des textes et même des images, offrant une flexibilité dans la gestion des données.

Services de conseil en analyse de données: En plus de l'outil d'intégration de données, Coupler.io propose des services de conseil en analyse de données, fournissant aux entreprises des conseils d'experts sur la meilleure façon d'utiliser leurs données.

Plans tarifaires Coupler.io

Coupler.io propose quatre plans tarifaires pour répondre aux différents besoins des entreprises.

Testeur: Au prix de 64 $ par mois, ce forfait est conçu pour 2 utilisateurs. Il inclut toutes les sources, 500 exécutions par mois et 10,000 XNUMX lignes par exécution. Les données sont automatiquement actualisées quotidiennement.

Plan d'équipe: Ce forfait coûte 132 $ par mois et convient à 5 utilisateurs. Il inclut toutes les sources, 4,000 50,000 exécutions par mois et 30 XNUMX lignes par exécution. Les données sont automatiquement actualisées toutes les XNUMX minutes.

Plan Business: À 332 $ par mois, ce forfait est conçu pour un nombre illimité d'utilisateurs. Il inclut toutes les sources, plus de 10,000 100,000 exécutions par mois et plus de 15 XNUMX lignes par exécution. Les données sont automatiquement actualisées toutes les XNUMX minutes.

Plan d'entreprise: Pour connaître les tarifs et les fonctionnalités du forfait Entreprise, il est conseillé aux entreprises de contacter directement Coupler.io.

Coupler.io accepte les cartes de débit et de crédit pour les paiements.

7. Colle AWS

AWS Glue est un service d'intégration de données sans serveur qui simplifie le processus de découverte, de préparation et d'intégration de données provenant de plusieurs sources pour l'analyse, l'apprentissage automatique et le développement d'applications. Il prend en charge un large éventail de charges de travail et est conçu pour évoluer à la demande, fournissant des outils sur mesure pour divers besoins d'intégration de données. AWS Glue fait partie de la suite Amazon Web Services (AWS), offrant une solution complète pour gérer et transformer les données à toute échelle.

Que fait AWS Glue ?

AWS Glue est conçu pour rationaliser le processus d'intégration des données. Il découvre, prépare, déplace et intègre des données provenant de diverses sources, les rendant ainsi prêtes pour l'analyse, l'apprentissage automatique et le développement d'applications. AWS Glue peut lancer des tâches ETL à mesure que de nouvelles données arrivent. Par exemple, il peut être configuré pour exécuter des tâches ETL dès que de nouvelles données sont disponibles dans Amazon Simple Storage Service (S3). Il fournit également un catalogue de données pour découvrir et rechercher rapidement plusieurs sources de données AWS.

Fonctionnalités clés d'AWS Glue

Options du moteur d'intégration de données: AWS Glue propose différents moteurs d'intégration de données pour prendre en charge divers besoins et charges de travail des utilisateurs. Il peut exécuter des tâches ETL basées sur les événements, ce qui signifie qu'il peut lancer ces tâches dès que de nouvelles données arrivent.

Catalogue de données AWS Glue: Cette fonctionnalité permet aux utilisateurs de découvrir et de rechercher rapidement plusieurs sources de données AWS. Le catalogue de données est un magasin de métadonnées persistantes pour toutes vos ressources de données, quel que soit leur emplacement.

Tâches ETL sans code: AWS Glue offre la possibilité de gérer et de surveiller la qualité des données, ainsi que de créer des tâches ETL sans avoir besoin de codage. Cela simplifie le processus d’intégration et de transformation des données.

Évoluer à la demande: AWS Glue est conçu pour évoluer à la demande, lui permettant de prendre en charge toutes les charges de travail et de s'adapter aux besoins de l'utilisateur.

Prise en charge de Git: AWS Glue s'intègre à Git, un système de contrôle de version open source largement utilisé. Cela permet aux utilisateurs de conserver un historique des modifications apportées à leurs tâches AWS Glue.

AWS Colle Flex: Il s'agit d'une classe de travaux d'exécution flexible qui permet aux utilisateurs de réduire le coût des charges de travail non urgentes.

Plans tarifaires AWS Glue

AWS Glue propose une variété de plans tarifaires basés sur les besoins spécifiques de l'utilisateur. La tarification est principalement basée sur les ressources consommées pendant l'exécution des tâches. Les utilisateurs doivent contacter l'équipe commerciale pour obtenir un devis.

AWS Glue accepte les cartes de débit et de crédit, PayPal et les virements bancaires pour les paiements.

8. point

Stitch est une plate-forme open source axée sur le cloud, conçue pour déplacer rapidement des données de diverses sources vers la destination de votre choix. En tant que puissant outil ETL, Stitch se connecte à un large éventail de sources de données, des bases de données comme MySQL et MongoDB aux applications SaaS comme Salesforce et Zendesk. Il est conçu pour contourner la charge de travail de développement, permettant aux équipes de se concentrer sur la création de leur produit principal et sur sa commercialisation plus rapide. Stitch n'est pas un outil d'analyse ou de visualisation de données, mais il joue un rôle crucial dans le mouvement des données, ouvrant la voie à une analyse ultérieure à l'aide d'autres outils.

Que fait Stitch ?

Stitch est un service ETL flexible, simple et puissant qui se connecte à toutes vos sources de données et réplique ces données vers la destination de votre choix. Il est conçu pour répliquer les données de manière sécurisée et fiable sur n'importe quel volume, vous permettant ainsi de vous développer sans vous soucier d'une panne ETL. L'infrastructure de Stitch est idéale pour gérer efficacement les charges de travail critiques et, grâce à de multiples protections redondantes, protège contre la perte de données en cas de panne. Il s'agit d'une solution ETL SaaS de classe mondiale qui transmet de manière transparente les données de plusieurs sources vers une destination, offrant ainsi une expérience d'intégration de données rapide, rentable et sans tracas.

Caractéristiques clés du point

Pipelines de données cloud automatisés: Stitch propose des pipelines de données cloud entièrement automatisés, permettant aux équipes d'obtenir des informations plus rapidement et de se concentrer sur la création de leur produit principal.

Mouvement de données sécurisé: Stitch fournit des options sécurisées pour les connexions à toutes les sources et destinations de données, notamment SSL/TLS, le tunneling SSH et la liste blanche IP, garantissant la sécurité de vos données pendant le transit.

Configuration de réplication flexible: Avec Stitch, vous pouvez configurer votre processus de réplication de données en fonction de vos besoins, offrant flexibilité et contrôle sur le mouvement de vos données.

ETL évolutif et fiable: Stitch est conçu pour répliquer les données de manière sécurisée et fiable sur n'importe quel volume, vous permettant ainsi de vous développer sans vous soucier d'une panne ETL.

Plate-forme open source: Stitch est une plateforme open source, permettant aux développeurs de créer et de collaborer sur des intégrations en utilisant une approche communautaire.

Prise en charge de plusieurs sources de données: Stitch prend en charge un large éventail de sources de données, des bases de données comme MySQL et MongoDB aux applications SaaS comme Salesforce et Zendesk, garantissant une intégration complète des données.

Plans tarifaires de points

Stitch propose trois plans tarifaires : Standard, Advanced et Premium. Chaque forfait est conçu pour répondre à différents besoins en matière de données et est doté de son propre ensemble de fonctionnalités.

standard plan: Le forfait Standard est un forfait flexible (à partir de 1100 100 $ par mois) qui évolue avec vos besoins. Il offre un accès complet à plus de 5 sources de données et son tarif est basé sur un volume de données supérieur à XNUMX millions de lignes par mois.

Plan avancé: Le plan Advanced, au prix de 1,250 XNUMX $ par mois, est conçu pour les clients plus exigeants à l'échelle de l'entreprise. Il comprend des fonctionnalités et des services supplémentaires non disponibles dans le plan standard.

Plan Premium: Le forfait Premium, au prix de 2,500 XNUMX $ par mois, est l'offre la plus complète de Stitch. Il comprend toutes les fonctionnalités du plan avancé, ainsi que des fonctionnalités premium supplémentaires.

Stitch accepte les cartes de débit et de crédit, PayPal et les virements bancaires pour les paiements.

9. skyvia

Skyvia se présente comme une plateforme cloud polyvalente conçue pour répondre à une variété de besoins de gestion de données. Il offre une suite complète d'outils pour l'intégration, la sauvegarde et l'accès aux données sur différentes sources de données cloud et sur site. En mettant l'accent sur la simplicité et la facilité d'utilisation, Skyvia vise à rationaliser les processus de données complexes, en les rendant accessibles aux utilisateurs techniques et non techniques. Son approche sans code permet une configuration et une exécution rapides des tâches de données, tout en offrant des fonctionnalités robustes à ceux qui ont besoin de fonctionnalités plus avancées.

Que fait Skyvia ?

Skyvia est un outil aux multiples facettes qui simplifie le processus d'intégration, de sauvegarde et de gestion des données dans divers environnements. Il permet aux utilisateurs de connecter un large éventail d'applications cloud, de bases de données et de fichiers plats sans avoir besoin de connaissances approfondies en codage. Qu'il s'agisse de migrer des données entre systèmes, de synchroniser des enregistrements entre plates-formes ou de mettre en place des flux de travail automatisés, Skyvia fournit une interface conviviale pour accomplir ces tâches efficacement. De plus, il offre des fonctionnalités de sauvegarde et de restauration sécurisées des données, garantissant que les données critiques de l'entreprise sont protégées et facilement récupérables.

Principales caractéristiques de Skyvia

Intégration de données dans le cloud: Le service d'intégration de données de Skyvia permet aux utilisateurs de connecter diverses sources de données, telles que des applications SaaS, des bases de données et des fichiers CSV, et de déplacer des données entre elles de manière transparente. Cela inclut la prise en charge de toutes les opérations DML, telles que la création, la mise à jour, la suppression et l'insertion d'enregistrements, garantissant ainsi que les données restent cohérentes et à jour sur les différents systèmes.

Sauvegarde et récupération: La plateforme fournit des solutions de sauvegarde robustes pour les données cloud, garantissant que les utilisateurs peuvent protéger leurs informations contre la suppression accidentelle ou la corruption. Les processus de récupération sont simples, permettant une restauration rapide des données en cas de besoin.

Gestion des données: Avec Skyvia, les utilisateurs peuvent accéder et gérer leurs données via une interface centralisée. Cela inclut l'interrogation, la modification et la visualisation de données provenant de différentes sources sans avoir besoin d'une interaction directe avec les bases de données ou les applications sous-jacentes.

Interface sans code: L'interface sans code de la plateforme permet aux utilisateurs d'effectuer des tâches de données complexes sans écrire une seule ligne de code. Cela démocratise la gestion des données, la rendant accessible à un plus large éventail d’utilisateurs au sein d’une organisation.

Planification flexible: Skyvia propose des options de planification flexibles pour les tâches d'intégration de données, permettant aux utilisateurs d'automatiser les processus en fonction de leurs besoins spécifiques. Cela peut aller de l'exécution de tâches une fois par jour à une synchronisation presque en temps réel, selon le plan choisi.

Cartographie et transformation avancées: Les utilisateurs peuvent profiter de puissantes fonctionnalités de cartographie pour transformer les données lors de leur déplacement entre les sources. Cela inclut le fractionnement des données, l'utilisation d'expressions et de formules, ainsi que la configuration de recherches, essentielles pour garantir que les données correspondent au schéma cible.

Plans tarifaires Skyvia

Skyvia propose une gamme de plans tarifaires pour répondre aux différents besoins et budgets des utilisateurs.

Plan gratuit: Ce plan est conçu pour les utilisateurs qui ont besoin de capacités d'intégration de base, offrant 10,000 XNUMX enregistrements par mois avec une planification quotidienne et deux intégrations planifiées.

Plan de base: Destiné aux petites entreprises ou aux utilisateurs individuels, le forfait de base, au prix de 19 $ par mois (15 $ par mois lorsqu'il est facturé annuellement), augmente le nombre d'enregistrements et les options de planification, offrant plus de flexibilité pour les tâches de données régulières.

standard plan: Pour les organisations ayant des besoins d'intégration plus exigeants, le plan Standard, au prix de 99 $ par mois (79 $ par mois lorsqu'il est facturé annuellement), offre un nombre plus élevé d'enregistrements, une planification plus fréquente et des fonctionnalités supplémentaires telles que des outils avancés de cartographie et de transformation.

Plan professionnel: Le plan professionnel est conçu pour les grandes entreprises qui ont besoin de capacités étendues d'intégration de données, notamment des intégrations planifiées illimitées et la fréquence d'exécution la plus courte.

Skyvia accepte diverses méthodes de paiement, notamment les cartes de débit et de crédit, ainsi que les virements bancaires, pour répondre aux préférences des utilisateurs.

10. Usine de données Azure

Azure Data Factory est un service d'intégration de données basé sur le cloud qui permet aux utilisateurs de créer, planifier et orchestrer des flux de travail de données. Il est conçu pour faciliter le déplacement et la transformation des données entre divers magasins de données, à la fois sur site et dans le cloud. En mettant l'accent sur la facilité d'utilisation, il fournit une interface visuelle pour créer des processus ETL complexes qui peuvent évoluer pour répondre aux exigences des charges de travail Big Data.

Que fait Azure Data Factory ?

Azure Data Factory permet aux entreprises d'intégrer des sources de données disparates, qu'elles résident dans divers services cloud ou dans une infrastructure sur site. Il agit comme le ciment qui rassemble les données provenant de plusieurs sources, permettant la transformation et l'analyse des données de manière centralisée et gérée. Ce service prend en charge une variété de scénarios ETL et d'intégration de données, du simple mouvement de données aux pipelines de traitement de données complexes, et il est capable de gérer efficacement de gros volumes de données.

Fonctionnalités clés d'Azure Data Factory

Capacités d'intégration de données: Azure Data Factory offre de solides capacités d'intégration de données, permettant aux utilisateurs de se connecter de manière transparente à un large éventail de sources de données, notamment des bases de données, des systèmes de fichiers et des services cloud.

Flux de données visuels: L'outil fournit une interface visuelle pour concevoir des flux de travail basés sur les données, permettant aux utilisateurs de configurer et de gérer plus facilement leurs pipelines de données sans avoir besoin d'un codage approfondi.

Services ETL gérés: Il fournit un service ETL entièrement géré, ce qui signifie que les utilisateurs n'ont pas à se soucier de la gestion de l'infrastructure et peuvent se concentrer sur la conception de leur logique de transformation des données.

Prise en charge de divers services informatiques: Azure Data Factory s'intègre à divers services de calcul Azure, tels qu'Azure HDInsight et Azure Databricks, permettant un traitement et des analyses de données puissants.

Planification et déclencheurs événementiels: Les utilisateurs peuvent planifier des pipelines de données ou les configurer pour qu'ils s'exécutent en réponse à certains événements, ce qui offre de la flexibilité et garantit que les données sont traitées en temps opportun.

Outils de suivi et de gestion: Le service comprend des outils de surveillance et de gestion des pipelines de données, offrant aux utilisateurs une visibilité sur leurs flux de données et la possibilité de résoudre les problèmes dès qu'ils surviennent.

Plans tarifaires Azure Data Factory

Azure Data Factory propose plusieurs plans tarifaires pour répondre aux différents besoins des utilisateurs et contraintes budgétaires. Les utilisateurs peuvent calculer leur plan personnalisé à l'aide du Calculateur de prix Azure Data Factory.

Les paiements pour Azure Data Factory peuvent être effectués par carte de débit et de crédit, PayPal et virement bancaire.

11. Gestion des données SAS

SAS Data Management se présente comme une solution complète conçue pour permettre aux organisations de gérer et d'optimiser efficacement leurs pipelines de données. Il s'agit d'une plateforme qui s'adresse à plus de 80,000 XNUMX organisations, facilitant une connectivité transparente des données, des transformations améliorées et une gouvernance robuste. L'outil est conçu pour fournir une vue unifiée des données sur divers systèmes de stockage, notamment des bases de données, des entrepôts de données et des lacs de données. Il prend en charge les connexions avec les principales plates-formes cloud, les systèmes sur site et les sources de données multicloud, rationalisant ainsi les flux de données et exécutant facilement l'ELT. SAS Data Management est reconnu pour sa capacité à garantir la conformité réglementaire, à renforcer la confiance dans les données et à offrir de la transparence, se positionnant ainsi comme leader des solutions de qualité des données.

Que fait SAS Data Management ?

SAS Data Management est un outil polyvalent qui permet aux entreprises de gérer de manière globale le cycle de vie de leurs données. Il fournit une interface utilisateur graphique intuitive par pointer-cliquer qui simplifie les tâches complexes de gestion de données. Les utilisateurs peuvent interroger et utiliser des données sur plusieurs systèmes sans avoir besoin de rapprochement physique ou de déplacement de données, offrant ainsi une solution rentable pour les utilisateurs professionnels. L'outil prend en charge la gestion des données de référence avec des fonctionnalités telles que des descriptions de données sémantiques et une correspondance floue sophistiquée pour garantir l'intégrité des données. De plus, SAS Data Management offre un équilibrage de charge compatible avec la grille et un traitement parallèle multithread pour une transformation et un déplacement rapides des données, éliminant ainsi le besoin d'outils redondants et qui se chevauchent et garantissant une approche unifiée de gestion des données.

Fonctionnalités clés de la gestion des données SAS

Connectivité des données transparente: SAS Data Management excelle dans la connexion de sources de données disparates, offrant aux utilisateurs la possibilité d'accéder et d'intégrer des données sur diverses plates-formes sans les tracas d'une intervention manuelle.

Transformations améliorées: L'outil offre des capacités avancées de transformation des données, permettant aux utilisateurs de manipuler et d'affiner efficacement leurs données, garantissant qu'elles sont prêtes pour l'analyse et le reporting.

Une gouvernance robuste: Avec SAS Data Management, les organisations peuvent appliquer des politiques de gouvernance des données, garantissant ainsi la qualité des données et la conformité aux normes réglementaires.

Vue des données unifiée: Il fournit une vue complète du paysage des données d'une organisation, facilitant ainsi la gestion et l'analyse des données à partir d'un point central.

Concepteur visuel Low-Code: La plateforme comprend un concepteur visuel low-code en libre-service qui simplifie la création et la gestion de pipelines de données, le rendant accessible aux utilisateurs ayant des expertises techniques variées.

Conformité réglementaire: SAS Data Management garantit que les processus de traitement des données respectent les réglementations du secteur, aidant ainsi les organisations à maintenir la confiance et la transparence dans leurs pratiques de gestion des données.

Plans tarifaires SAS pour la gestion des données

SAS Data Management propose des plans tarifaires personnalisés adaptés aux besoins spécifiques des organisations. Pour comprendre la gamme complète des options tarifaires et les fonctionnalités incluses dans chaque plan, les parties intéressées sont encouragées à demander une démo.

12. Flux de données Google Cloud

Google Cloud Dataflow est un service entièrement géré qui simplifie les complexités du traitement de données à grande échelle. Il offre un modèle de programmation unifié pour le traitement par lots et par flux, ce qui signifie qu'il peut gérer à la fois le traitement des données historiques stockées ainsi que les données en temps réel au fur et à mesure de leur génération. En tant que membre de l'écosystème Google Cloud, Dataflow s'intègre parfaitement à d'autres services tels que BigQuery, Pub/Sub et Cloud Storage, offrant une solution complète pour les tâches ETL, l'analyse en temps réel et les défis informatiques. Son approche sans serveur signifie que les utilisateurs n'ont pas à gérer l'infrastructure sous-jacente, ce qui leur permet de se concentrer sur l'analyse et les informations plutôt que sur les aspects opérationnels de leurs pipelines de données.

À quoi sert Google Cloud Dataflow ?

Google Cloud Dataflow est conçu pour fournir un environnement évolutif et sans serveur pour les tâches de traitement des données. Il permet aux utilisateurs de créer des pipelines de traitement ETL, par lots et par flux complexes qui peuvent ingérer des données provenant de diverses sources, les transformer selon une logique métier, puis les charger dans des moteurs d'analyse ou des bases de données pour une analyse plus approfondie. La capacité de Dataflow à gérer à la fois des données par lots et en temps réel le rend polyvalent pour un large éventail de cas d'utilisation, de la détection de fraude en temps réel à l'analyse quotidienne des journaux. Le service supprime l'approvisionnement des ressources, s'adapte automatiquement pour répondre aux exigences du travail, et fournit une suite d'outils pour surveiller et optimiser les pipelines, garantissant que les données sont traitées de manière efficace et fiable.

Principales fonctionnalités de Google Cloud Dataflow

Traitement unifié des flux et des lots: Dataflow propose un modèle unique pour traiter à la fois les données en streaming et par lots, ce qui simplifie le développement de pipelines et permet un code cohérent et plus gérable.

Fonctionnement sans serveur: les utilisateurs peuvent se concentrer sur le codage plutôt que sur l'infrastructure, car Dataflow provisionne et gère automatiquement les ressources nécessaires.

Mise à l'échelle automatique: Le service augmente ou diminue les ressources en fonction de la charge de travail, garantissant un traitement efficace sans surprovisionnement.

Intégration avec Google Cloud Services: Dataflow s'intègre à BigQuery, Pub/Sub et à d'autres services Google Cloud, permettant ainsi des solutions d'analyse de données transparentes.

Tolérance aux pannes intégrée: Dataflow garantit des résultats cohérents et corrects, quelle que soit la taille des données ou la complexité du calcul, en offrant une tolérance aux pannes intégrée.

Outils de développement: Il propose des outils pour créer, déboguer et surveiller des pipelines de données, ce qui contribue à maintenir des performances et une fiabilité élevées.

Plans tarifaires Google Cloud Dataflow

Google Cloud Dataflow propose une variété de plans tarifaires adaptés à différents modèles d'utilisation et budgets. La tarification est basée sur les ressources consommées par les tâches, telles que le processeur, la mémoire et le stockage, et est facturée à la seconde, offrant un contrôle granulaire des coûts. Les utilisateurs doivent contacter l'équipe commerciale pour obtenir des informations sur les plans tarifaires :

Mélange de flux de données: Le prix de cette fonctionnalité est basé sur le volume de données traitées lors des opérations de lecture et d'écriture, ce qui est essentiel pour les opérations impliquant le brassage de grands ensembles de données.

Tarifs confidentiels des VM: Dataflow propose des VM confidentielles à un prix global, garantissant que les coûts sont prévisibles et ne varient pas selon les régions.

Ressources complémentaires : même si les tâches Dataflow peuvent consommer des ressources telles que Cloud Storage, Pub/Sub et BigQuery, celles-ci sont facturées séparément en fonction de leur tarification spécifique.

Flux de données principal: Pour les utilisateurs nécessitant des fonctionnalités et des optimisations avancées, Dataflow Prime est disponible, qui inclut des tarifs supplémentaires pour des fonctionnalités telles que le disque persistant, les GPU et les instantanés.

Le paiement des services Google Cloud Dataflow peut être effectué par carte de débit et de crédit, PayPal et virement bancaire, offrant ainsi une flexibilité dans les méthodes de paiement.

13. Transférable

Portable est un outil ETL basé sur le cloud conçu pour rationaliser le processus d'intégration des données pour les entreprises. Il simplifie les aspects complexes et souvent techniques des pipelines de données, les rendant accessibles aux utilisateurs sans connaissances approfondies en codage. La plate-forme de Portable est conçue pour gérer l'ensemble du processus ETL, qui comprend l'extraction de données à partir de diverses sources, leur transformation pour répondre aux besoins opérationnels et leur chargement dans un système de destination à des fins d'analyse et de business intelligence. Cet outil est particulièrement avantageux pour les organisations qui cherchent à automatiser leurs flux de travail de données et à tirer parti de l'infrastructure cloud pour gérer l'extraction de données, la transformation des données en vol et le chargement des données sans avoir besoin de maintenir leur propre infrastructure.

À quoi sert Portable ?

Portable fournit une solution sans code pour créer des pipelines de données, permettant aux utilisateurs de se connecter à plus de 500 sources de données. Il est conçu pour gérer les subtilités de la logique de transfert de données, telles que les appels API, le traitement des réponses, la gestion des erreurs et les limites de débit. Portable s'occupe également de la transformation des données en cours en définissant les types de données, en créant des schémas et en garantissant l'existence des clés de jointure, ainsi qu'en organisant les données non structurées pour les besoins en aval. La plateforme convient aux entreprises de toutes tailles qui ont besoin d'une solution fiable et évolutive pour intégrer leurs données sur divers systèmes et plateformes, que ce soit à des fins d'analyse, de reporting ou opérationnelles.

Principales fonctionnalités portables

Plus de 500 connecteurs de données: Portable propose une large gamme de connecteurs ETL, permettant aux entreprises d'intégrer de manière transparente des données provenant d'une grande variété de sources.

Solution basée sur le cloud: En tant qu'outil ETL basé sur le cloud, Portable est hébergé sur les serveurs du fournisseur, ce qui signifie que les utilisateurs peuvent accéder au service de n'importe où et n'ont pas à se soucier de la maintenance de l'infrastructure.

Interface sans code: La plateforme fournit une interface conviviale et sans code qui permet aux utilisateurs non techniques de configurer et de gérer facilement les pipelines de données.

Développement de connecteurs personnalisés: Pour les sources de données uniques, Portable permet le développement de connecteurs personnalisés, offrant flexibilité et contrôle sur l'intégration des données.

Modèle de tarification forfaitaire: Portable adopte un modèle de tarification forfaitaire attrayant, permettant aux entreprises de prévoir plus facilement leurs dépenses sans se soucier des plafonds de volume de données.

Transformation des données en temps réel: La capacité d'effectuer une transformation des données en temps réel est une autre caractéristique clé, garantissant que les données sont toujours à jour et précises pour les processus de prise de décision.

Plans tarifaires portables

Portable propose trois plans tarifaires principaux pour répondre aux différents besoins de l'entreprise :

Testeur: Ce forfait, au prix de 200 $ par mois, est conçu pour ceux qui débutent dans l'intégration de données, offrant 1 flux de données planifié et des fonctionnalités telles que des volumes de données illimités, des champs de fraîcheur et une planification de flux toutes les 24 heures.

Plan à l'échelle: Destiné aux entreprises en croissance, le plan Scale, au prix de 1,000 10 $ par mois, comprend jusqu'à 15 flux de données planifiés, une planification de flux plus fréquente toutes les XNUMX minutes et des fonctionnalités à venir telles que des comptes multi-utilisateurs et des notifications de webhook.

Plan de croissance: Pour les entreprises ayant des besoins étendus en matière d'intégration de données, le plan de croissance fournit plus de 10 flux de données planifiés, une planification des flux en temps quasi réel et des fonctionnalités supplémentaires à venir telles que l'accès à l'API d'administration.

Portable accepte diverses méthodes de paiement, notamment les cartes de débit et de crédit, PayPal et les virements bancaires, offrant ainsi aux utilisateurs une flexibilité dans la gestion de leurs abonnements.

FAQ sur les outils ETL

Qu'est-ce qu'un outil ETL ?

Un outil ETL est une application logicielle utilisée pour extraire, transformer et charger des données provenant de diverses sources dans un entrepôt de données ou un autre système cible. Ces outils automatisent le processus d'intégration des données, garantissant la qualité et la cohérence des données et réduisant le temps et les efforts nécessaires à la préparation des données pour l'analyse.

Pourquoi les outils ETL sont-ils importants ?

Les outils ETL sont cruciaux dans le monde actuel axé sur les données, car ils automatisent le processus d'extraction de données à partir de diverses sources, leur transformation dans un format standardisé et leur chargement dans un entrepôt de données. Cette automatisation permet non seulement d'économiser du temps et des ressources, mais améliore également la qualité et la cohérence des données, permettant aux entreprises de prendre plus efficacement des décisions basées sur les données.

Comment fonctionnent les outils ETL ?

Les outils ETL fonctionnent en extrayant des données de diverses sources, en les transformant pour répondre aux normes de qualité nécessaires, puis en les chargeant dans un entrepôt de données ou un autre système cible. Ils automatisent l'ensemble de ce processus, réduisant ainsi les erreurs et accélérant l'intégration des données.

Quelles sont les principales fonctionnalités des outils ETL ?

Les principales fonctionnalités des outils ETL incluent la prise en charge de plusieurs sources de données, une interface utilisateur intuitive pour une manipulation facile des données et une évolutivité permettant de gérer de gros volumes de données. Ils doivent également fournir des capacités de qualité et de profilage des données, prendre en charge les données cloud et sur site, et être rentables.

Quels sont les défis liés à l’utilisation des outils ETL ?

Si les outils ETL offrent de nombreux avantages, ils présentent également certains défis. Ceux-ci incluent le besoin d'une expertise technique pour configurer et gérer les outils, gérer diverses sources de données et assurer la sécurité des données pendant le processus ETL.

Quels types d’outils ETL sont disponibles ?

Il existe plusieurs types d'outils ETL disponibles, notamment des outils open source, des services basés sur le cloud et des logiciels d'entreprise. Le choix de l'outil dépend des besoins spécifiques et des ressources de l'organisation.

Comment choisir le bon outil ETL ?

Le choix du bon outil ETL dépend de plusieurs facteurs, notamment de la complexité de vos besoins en données, du volume de données que vous devez traiter, des types de sources de données avec lesquelles vous travaillez et de votre budget. Il est également important de prendre en compte l'interface utilisateur, l'évolutivité et les services d'assistance de l'outil.

Les utilisateurs non techniques peuvent-ils utiliser les outils ETL ?

Oui, de nombreux outils ETL sont dotés d'interfaces utilisateur graphiques qui les rendent accessibles aux utilisateurs non techniques. Cependant, une compréhension de base des processus ETL et des principes de gestion des données est bénéfique.

Quel est l’avenir des outils ETL ?

L’avenir des outils ETL réside dans leur capacité à gérer des paysages de données de plus en plus complexes, notamment des flux de données en temps réel et diverses sources de données. Les progrès de l’IA et de l’apprentissage automatique devraient également améliorer les capacités des outils ETL, les rendant encore plus efficients et efficaces.

Les outils ETL sont-ils uniquement utilisés pour l’entreposage de données ?

Bien que les outils ETL soient couramment utilisés dans l'entreposage de données, ils ne se limitent pas à cette application. Ils peuvent également être utilisés pour des tâches de migration de données, d’intégration de données et de transformation de données dans divers autres contextes.

Conclusion

Les outils ETL jouent un rôle central dans l’environnement commercial actuel axé sur les données. Ils rationalisent le processus d'extraction, de transformation et de chargement des données, les rendant ainsi prêtes à l'analyse et à la prise de décision. Grâce à leur capacité à gérer diverses sources de données et de grands volumes de données, les outils ETL sont indispensables à toute organisation souhaitant exploiter efficacement ses données. À mesure que la technologie continue d’évoluer, nous pouvons nous attendre à ce que les outils ETL deviennent encore plus puissants et polyvalents, augmentant ainsi leur valeur pour les entreprises.

Dans le monde du Big Data, les outils ETL sont les héros méconnus. Ils travaillent en coulisses et veillent à ce que les données soient propres, cohérentes et prêtes à être analysées. En automatisant les tâches complexes de gestion des données, ils libèrent du temps et des ressources, permettant aux entreprises de se concentrer sur ce qui compte vraiment : utiliser leurs données pour prendre des décisions stratégiques. À mesure que nous avançons, l’importance des outils ETL ne fera qu’augmenter, ce qui en fera un élément clé de toute stratégie de données réussie.