13 bästa ETL-verktyg

I big datas tidevarv översvämmas företag med information från en mängd olika källor. Dessa data, om de utnyttjas på rätt sätt, kan ge ovärderliga insikter som driver strategiskt beslutsfattande. Men utmaningen ligger i att effektivt extrahera, transformera och ladda (ETL) denna data till ett format som är redo för analys. ETL-verktyg är svaret på denna utmaning. De är programvara som är speciellt utformad för att stödja ETL-processer, som att extrahera data från olika källor, skrubba och rengöra data för att uppnå högre kvalitet och konsolidera allt i datalager. ETL-verktyg förenklar datahanteringsstrategier och förbättrar datakvaliteten genom ett standardiserat tillvägagångssätt, vilket gör dem till en viktig komponent i alla datadrivna organisationer.

Vad är ett ETL-verktyg?

ETL, som står för Extract, Transform och Load, är en dataintegrationsprocess som kombinerar data från flera källor till ett enda, konsekvent datalager som laddas in i ett datalager eller annat målsystem. Processen börjar med att extrahera data från olika källor, som kan inkludera databaser, applikationer eller filer. Dessa rådata lagras sedan tillfälligt i ett mellanrum.

I transformationsfasen bearbetas rådata och förbereds för avsedd användning. Detta kan handla om att rensa data, ta bort dubbletter och konvertera dem till ett format som är kompatibelt med målsystemet. Den transformerade datan laddas sedan in i målsystemet, såsom ett datalager. Denna process är vanligtvis automatiserad och väldefinierad, vilket möjliggör effektiv och korrekt dataintegration.

ETL är en avgörande komponent i datalagring och affärsinformation, vilket gör det möjligt för organisationer att konsolidera sina data på en enda plats för analys och rapportering. Det ger ett systematiskt och korrekt sätt att analysera data, vilket säkerställer att all företagsdata är konsekvent och uppdaterad. ETL-processen har utvecklats över tiden, med moderna ETL-verktyg som erbjuder mer avancerade funktioner och möjligheter, såsom dataintegration i realtid och molnbaserad databehandling.

Behovet av ETL-verktyg

I dagens datadrivna värld är behovet av ETL-verktyg mer pressande än någonsin. Företag genererar enorma mängder data dagligen och manuella ETL-processer är inte längre möjliga. ETL-verktyg automatiserar utvinnings-, transformations- och laddningsprocesserna, vilket säkerställer att data är korrekta och redo för analys. De bryter ner datasilos, vilket gör det enkelt för datavetare att komma åt och analysera data, vilket gör det till handlingskraftig affärsintelligens. ETL-verktyg förbättrar också datakvaliteten genom att ta bort inkonsekvenser och anomalier, och de förenklar dataintegrationsprocessen genom att sömlöst kombinera data från olika källor. Detta resulterar i tidseffektivitet, eftersom behovet av att söka efter flera datakällor elimineras, vilket påskyndar beslutsprocesserna.

Hur fungerar ETL-verktyg?

ETL-verktyg fungerar i tre huvudsteg: extraktion, transformation och lastning. I utvinningsstadiet hämtas data från olika källor, som kan sträcka sig från databaser och applikationer till kalkylblad och molnbaserad lagring. Dessa data omvandlas sedan, vilket innebär att data rengörs, valideras och omformateras för att säkerställa att den uppfyller de nödvändiga kvalitetsstandarderna. Det sista steget är lastning, där den transformerade datan laddas in i ett datalager eller annat målsystem för lagring och analys. ETL-verktyg automatiserar hela processen, minskar fel och påskyndar dataintegration. De tillhandahåller också grafiska gränssnitt för snabbare och enklare resultat än traditionella metoder för att flytta data genom handkodade datapipelines.

13 bästa ETL-verktyg

- Integrera.io

- Talang

- IBM DataStage

- Oracle Data Integrator

- Fivetran

- Coupler.io

- AWS-lim

- Stitch

- Skyvia

- Azure Data Factory

- SAS Data Management

- Google Cloud Dataflow

- Bärbar

Hur väljer man de bästa ETL-verktygen?

Att välja rätt ETL-verktyg beror på flera faktorer. Tänk först på komplexiteten i dina datakrav. Ett bra ETL-verktyg ska kunna flytta och omvandla stora mängder data snabbt och effektivt, med minimal ansträngning. Det bör också stödja flera datakällor så att du enkelt kan kombinera datauppsättningar från olika källor. Ett intuitivt användargränssnitt är nyckeln för att snabbt manipulera data, konfigurera inställningar och schemalägga uppgifter. Tänk också på verktygets skalbarhet, komplexiteten i dina dataintegreringskrav och din budget. Olika organisationer kan ha olika behov, så det bästa ETL-verktyget kan variera beroende på din specifika situation och användningsfall.

ETL-verktyg (gratis och betalda)

1. Integrera.io

Integrate.io är en ledande dataintegrationslösning som tillhandahåller en enhetlig, lågkodad datalagerintegrationsplattform. Den erbjuder en omfattande uppsättning verktyg och kopplingar för att stödja hela din dataresa. Med sitt användarvänliga gränssnitt och robusta funktionalitet ger Integrate.io företag möjlighet att konsolidera, bearbeta och förbereda data för analys, vilket möjliggör välgrundat beslutsfattande.

Vad gör Integrate.io?

Integrate.io fungerar som ett molnbaserat ETL-verktyg som möjliggör skapandet av visualiserade datapipelines för automatiserade dataflöden över ett stort antal källor och destinationer. Det ger en kodnings- och jargongfri miljö, vilket gör den tillgänglig för både tekniska och icke-tekniska användare. Integrate.io underlättar implementeringen av händelsedriven arkitektur, dataströmning i realtid och API-skapande med minimal kodning, vilket tar itu med utmaningar som oflexibla databearbetningspipelines och skalbarhetsbegränsningar.

Integrate.io Nyckelfunktioner

Enkla datatransformationer: Integrate.io förenklar dina ETL- och ELT-processer genom att erbjuda ett lågkodat, enkelt dra-och-släpp-användargränssnitt och över ett dussin transformationer – som sortera, gå med, filtrera, välja, begränsa, klona, etc.

Enkelt arbetsflöde att skapa för att definiera beroenden mellan uppgifter: Denna funktion tillåter användare att enkelt definiera sekvensen och beroenden av databearbetningsuppgifter, vilket säkerställer ett effektivt och felfritt dataflöde.

REST API: Integrate.io tillhandahåller en omfattande REST API-lösning som gör det möjligt för användare att skapa API:er med minimal kodning och flexibel distribution.

Salesforce till Salesforce-integrationer: Den här funktionen tillåter användare att extrahera Salesforce-data, omvandla den och injicera den tillbaka till Salesforce, vilket ger en unik fördel för företag som är mycket beroende av Salesforce-data för CRM och annan affärsverksamhet.

Datasäkerhet och efterlevnad: Integrate.io säkerställer säkerheten för dina data med inbyggda krypteringsfunktioner och överensstämmelse med dataskyddsbestämmelser.

Olika datakällor och destinationsalternativ: Integrate.io stöder ett brett utbud av datakällor och destinationer, vilket ger flexibilitet och mångsidighet i dataintegration.

Integrate.io prisplaner

Integrate.io erbjuder tre huvudsakliga prissättningsplaner: Enterprise Plan, Professional Plan och Starter Plan.

Företagsplan: Denna plan är utformad för stora företag med omfattande dataintegrationsbehov. Den erbjuder avancerade funktioner och premiumsupport. Priset för denna plan är anpassad och kan erhållas genom att kontakta Integrate.io direkt.

Professionell plan: Den här planen, som kostar 25,000 XNUMX USD per år, är lämplig för medelstora företag. Det erbjuder en balans mellan avancerade funktioner och prisvärdhet.

Starterplan: Denna plan, prissatt till $15,000 XNUMX per år, är idealisk för små företag eller nystartade företag med grundläggande dataintegrationsbehov. Den erbjuder viktiga funktioner till ett överkomligt pris.

Integrate.io accepterar betal- och kreditkort samt banköverföring för betalningar.

2. Talang

Talend är en omfattande datahanteringslösning som tusentals organisationer förlitar sig på för att omvandla data till praktiska affärsinsikter. Det är en flexibel och pålitlig plattform som stöder end-to-end datahanteringsbehov i en hel organisation, från integration till leverans. Talend kan distribueras på plats, i molnet eller i en hybridmiljö, vilket gör det till ett mångsidigt verktyg för alla dataarkitekturer. Den är utformad för att leverera tydliga och förutsägbara värden samtidigt som den stödjer säkerhets- och efterlevnadsbehov.

Vad gör Talend?

Talend tillhandahåller enhetliga utvecklings- och hanteringsverktyg för att integrera och bearbeta all din data. Det är en mjukvaruintegreringsplattform som erbjuder lösningar för dataintegration, datakvalitet, datahantering, dataförberedelse och big data. Talend hjälper organisationer att fatta beslut i realtid och bli mer datadrivna genom att göra data mer tillgänglig, förbättra dess kvalitet och snabbt flytta den till målsystem. Det är det enda ETL-verktyget med alla plugins som enkelt kan integreras med Big Data-ekosystemet.

Talends nyckelfunktioner

Dataintegration: Talend erbjuder robusta dataintegreringsmöjligheter. Den tillhandahåller en rad SQL-mallar för att förenkla den vanligaste datafrågan och uppdateringen, skapande och modifiering av scheman och datahanteringsuppgifter.

Datakvalitet: Talend säkerställer kvaliteten på data genom att tillhandahålla funktioner för dataprofilering, rensning och övervakning. Det hjälper företag att förbättra kvaliteten på sin data, göra den mer tillgänglig och snabbt flyttas till målsystem.

Data Governance: Talend stöder datastyrning genom att tillhandahålla funktioner för datakatalogisering, datalinje och datasekretess. Det hjälper organisationer att upprätthålla efterlevnad av dataregler och säkerställa säkerheten för deras data.

Lågkodsplattform: Talend är en plattform med låg kod som förenklar processen för att utveckla arbetsflöden för dataintegration. Det ger en visuell designer som gör det enkelt att skapa och hantera datapipelines.

skalbarhet: Talend är designat för att skalas sömlöst när databehoven växer. Den kan hantera stora mängder data och komplexa databearbetningsuppgifter, vilket gör det till en framtidssäker investering för företag.

Moln och Big Data Integration: Talend stöder integration med olika molnplattformar och big data-teknologier. Den tillhandahåller kopplingar till paketerade applikationer, databaser, stordatorer, filer, webbtjänster och mer.

Talend prissättningsplaner

Talend erbjuder flera prissättningsplaner för att tillgodose olika affärsbehov. De tillgängliga planerna inkluderar:

Datahanteringsplattform: Denna plan erbjuder omfattande funktioner för dataintegrering och hantering. Det är designat för företag som behöver integrera, rensa och hantera data från olika källor.

Big Data-plattform: Den här planen är utformad för företag som behöver hantera stora mängder data. Den erbjuder funktioner för big data-integration, datakvalitet och datastyrning.

Datatyg: Det här är Talends mest omfattande plan. Den kombinerar funktionerna i Data Management Platform och Big Data Platform och lägger till ytterligare funktioner för applikations- och API-integration.

För prisinformation måste användare kontakta säljteamet.

3. IBM DataStage

IBM DataStage står som ett robust och mångsidigt ETL-verktyg, designat för att underlätta och effektivisera processen för dataintegration mellan olika system. Dess möjligheter är rotade i en kraftfull parallell bearbetningsarkitektur, som säkerställer skalbarhet och hög prestanda för dataintensiva operationer. Som en del av IBM Cloud Pak for Data as a Service erbjuder DataStage en heltäckande lösning som stöder ett brett utbud av dataintegreringsuppgifter, från enkla till komplexa. Den är konstruerad för att fungera sömlöst på plats eller i molnet, vilket ger företag flexibilitet när det gäller att hantera sina dataarbetsflöden. Plattformens företagsanslutning och utbyggbarhet gör den till ett lämpligt val för organisationer som vill utnyttja sin data för insiktsfulla analyser och AI-applikationer, vilket säkerställer att de kan leverera kvalitetsdata på ett tillförlitligt sätt till intressenter.

Vad gör IBM DataStage?

IBM DataStage utmärker sig i att extrahera data från flera källor, omvandla den för att möta affärskrav och ladda in den i målsystem, oavsett om de är lokala databaser, molnlager eller datalager. Den är utformad för att hantera ett brett spektrum av dataformat och strukturer, vilket gör det möjligt för företag att enkelt integrera olika datakällor. Verktygets kraftfulla transformationsfunktioner möjliggör komplex databehandling, inklusive datarensning och övervakning, för att säkerställa att den levererade datan är av högsta kvalitet. Med sin parallella bearbetningsmotor kan DataStage effektivt bearbeta stora datamängder, vilket gör det till en idealisk lösning för företag som hanterar big data-utmaningar. Dessutom tillåter dess öppna och utbyggbara karaktär anpassning och integration med andra AI- och analysplattformar, vilket ger en sömlös dataintegrationsupplevelse som stöder ett brett utbud av datadrivna initiativ.

IBM DataStage Nyckelfunktioner

Parallell bearbetning: IBM DataStage utnyttjar en högpresterande parallell bearbetningsmotor som möjliggör effektiv hantering av stora datavolymer, vilket avsevärt minskar tiden som krävs för dataintegreringsuppgifter.

Enterprise Connectivity: Verktyget erbjuder omfattande anslutningsmöjligheter, vilket möjliggör sömlös integration med en mängd företagssystem, databaser och applikationer, vilket underlättar ett enhetligt dataekosystem.

Molnkompatibilitet: DataStage är designat för att köras i alla molnmiljöer, vilket ger flexibilitet och skalbarhet för företag som vill utnyttja molnresurser för sina dataintegrationsbehov.

Datarensning och övervakning: Den innehåller funktioner för att rensa och övervaka data, vilket säkerställer att informationen som bearbetas och levereras är korrekt, konsekvent och av hög kvalitet.

Sträckbarhet: Plattformen är öppen och utbyggbar, vilket möjliggör anpassning och integration med andra data- och AI-verktyg, vilket förbättrar dess förmåga att möta specifika affärskrav.

End-to-end dataintegration: DataStage tillhandahåller en heltäckande lösning för hela dataintegrationslivscykeln, från extraktion och transformation till laddning, vilket gör det till en one-stop-shop för alla dataintegrationsaktiviteter.

IBM DataStage prissättningsplaner

IBM DataStage erbjuder en mängd olika prisplaner som är skräddarsydda för att möta behoven hos olika organisationer, från små företag till stora företag. Varje plan är utformad för att tillhandahålla specifika funktioner och möjligheter, vilket säkerställer att företag kan välja det alternativ som bäst passar deras dataintegrationskrav och budget. Användare måste kontakta säljteamet för ett prisinformationsmöte.

IBM DataStage accepterar betal- och kreditkort för betalningar.

4. Oracle Data Integrator

Oracle Data Integrator (ODI) är ett ETL-verktyg och en omfattande dataintegrationsplattform som tillgodoser ett brett spektrum av dataintegrationsbehov. Den är designad för att hantera stora volymer, högpresterande batchladdningar, händelsedrivna, trickle-feed-integreringsprocesser och SOA-aktiverade datatjänster. Den senaste versionen, ODI 12c, erbjuder överlägsen utvecklarproduktivitet och en förbättrad användarupplevelse med ett omdesignat flödesbaserat deklarativt användargränssnitt. Det ger också djupare integration med Oracle GoldenGate, och erbjuder omfattande big data-stöd och extra parallellitet vid exekvering av dataintegrationsprocesser.

Vad gör Oracle Data Integrator?

Oracle Data Integrator är ett strategiskt dataintegrationserbjudande från Oracle som ger en flexibel och högpresterande arkitektur för att utföra dataintegrationsprocesser. Den är designad för att hantera stora volymer, högpresterande batchladdningar, händelsedrivna, trickle-feed-integreringsprocesser och SOA-aktiverade datatjänster. ODI 12c, den senaste versionen, erbjuder överlägsen utvecklarproduktivitet och en förbättrad användarupplevelse med ett omdesignat flödesbaserat deklarativt användargränssnitt. Det ger också djupare integration med Oracle GoldenGate, och erbjuder omfattande big data-stöd och extra parallellitet vid exekvering av dataintegrationsprocesser.

Oracle Data Integrators nyckelfunktioner

Högpresterande arkitektur: Oracle Data Integrator erbjuder en flexibel och högpresterande arkitektur som möjliggör effektiva dataintegreringsprocesser. Den stöder stora volymer, högpresterande batchladdningar, händelsedrivna, trickle-feed-integreringsprocesser och SOA-aktiverade datatjänster.

Förbättrad användarupplevelse: Den senaste versionen, ODI 12c, ger en förbättrad användarupplevelse med ett omdesignat flödesbaserat deklarativt användargränssnitt. Detta gränssnitt förbättrar utvecklarnas produktivitet och gör det lättare att hantera och utföra dataintegreringsprocesser.

Djup integration med Oracle GoldenGate: Oracle Data Integrator ger djupare integration med Oracle GoldenGate. Denna integration möjliggör omfattande big data-stöd och extra parallellitet vid exekvering av dataintegreringsprocesser.

Big Data Support: Oracle Data Integrator erbjuder omfattande stöd för big data. Den integreras sömlöst med stora dataplattformar som Hadoop och Spark, vilket möjliggör effektiv bearbetning och analys av stora datamängder.

Samarbetsutveckling och versionskontroll: Oracle Data Integrator erbjuder funktioner för gemensam utveckling och versionskontroll. Dessa funktioner underlättar teambaserade ETL-projekt och säkerställer att alla förändringar spåras och hanteras effektivt.

Robusta säkerhetsfunktioner: Oracle Data Integrator erbjuder robusta säkerhetsfunktioner och integreras med befintliga säkerhetsramverk. Detta säkerställer datakonfidentialitet och efterlevnad av olika dataskyddsbestämmelser.

Prisplaner för Oracle Data Integrator

Oracle Data Integrator erbjuder en mängd olika prisplaner för att tillgodose olika användarbehov. Prissättningen baseras på en licensmodell per kärna, med årliga abonnemang som sträcker sig från flera tusen till tiotusentals dollar per år. Den exakta kostnaden beror på antalet kärnor som krävs, distributionsalternativ (moln kontra lokalt) och ytterligare funktioner som behövs. Till exempel kan en grundläggande molninstallation med 2 kärnor kosta cirka 5,000 16 USD per år, medan en större lokal distribution med 50,000 kärnor och avancerade funktioner kan kosta uppemot XNUMX XNUMX USD per år.

Oracle Data Integrator accepterar betal- och kreditkort, PayPal och banköverföring för betalningar.

5. Fivetran

Fivetran är en ledande plattform för automatiserad datarörelse designad för att effektivisera processen för dataintegration och centralisering. Det är ett robust ETL-verktyg som ger företag möjlighet att uppnå självbetjäningsanalys, bygga anpassade datalösningar och lägga mindre tid på att integrera system. Fivetran är en perfekt plattform för ingenjörer, analytiker och utvecklare som vill centralisera data för rapporter, analys och bygga med data.

Vad gör Fivetran?

Fivetran är en molnbaserad datapipeline som automatiserar processen att extrahera data från olika källor, omvandla den till ett användbart format och ladda in det i ett datalager för analys. Det tar bort flaskhalsar i dataprocesser utan att kompromissa med efterlevnad, vilket gör det till en idealisk lösning för företag som behöver utöka sin dataplattform för att stödja anpassade behov. Oavsett om du är en ingenjör som vill lägga mindre tid på att integrera system, en analytiker som arbetar med SQL- eller BI-verktyg, eller en utvecklare som bygger med data, gör Fivetrans API och webhooks det till ett mångsidigt verktyg för alla dina databehov.

Fivetran Nyckelfunktioner

Automatiserad dataintegration: Fivetran förenklar processen för dataintegration genom att automatisera extraheringen, omvandlingen och laddningen av data från olika källor till ett datalager.

Självbetjäningsanalys: Fivetran gör det möjligt för företag att uppnå självbetjäningsanalyser genom att ta bort flaskhalsar i dataprocesser, vilket möjliggör effektivare dataanalys och beslutsfattande.

Anpassade datalösningar: Med Fivetran kan företag utöka sin dataplattform för att stödja anpassade behov, vilket ger flexibilitet och anpassningsförmåga vid hantering av data.

API och Webhooks: Fivetran erbjuder API och webhooks, vilket gör det till en perfekt plattform för utvecklare som bygger med data.

Efterlevnad utan kompromisser: Fivetran säkerställer dataöverensstämmelse utan att kompromissa med effektiviteten i dataprocesser, vilket ger företag sinnesro.

Stöd för olika användartyper: Oavsett om du är ingenjör, analytiker eller utvecklare tillgodoser Fivetran dina databehov, vilket gör det till ett mångsidigt verktyg för olika användartyper.

Fivetran prissättningsplaner

Fivetran erbjuder fyra olika prisplaner: gratisplan, startplan, standardplan och företagsplan. För prissättning av varje plan måste användare kontakta säljteamet.

Fri plan: Gratisplanen är ett grundläggande erbjudande som låter användare uppleva kärnfunktionerna i Fivetran.

Starterplan: Startplanen inkluderar allt i gratisplanen, med ytterligare funktioner och möjligheter för mer omfattande dataintegreringsbehov.

Standardplan: Standardplanen inkluderar allt i startplanen, plus obegränsade användare, 15-minuterssynkroniseringar, databasanslutningar och tillgång till Fivetrans REST API.

Företagsplan: Enterprise Planen inkluderar allt i standardplanen, plus företagsdatabasanslutningar, 1-minuterssynkroniseringar, detaljerade roller och support för team, avancerad datastyrning, avancerade säkerhets- och datauppehållsalternativ och prioriterad support.

Fivetran accepterar betal- och kreditkort för betalningar.

6. Coupler.io

Coupler.io är en allt-i-ett-plattform för dataanalys och automatisering utformad för att effektivisera processen för datainsamling, transformation och automatisering. Det ger företag möjlighet att fatta datadrivna beslut genom att tillhandahålla en enda punkt av sanning mellan olika datakällor. Med sitt användarvänliga gränssnitt och robusta funktionalitet förenklar Coupler.io den komplexa uppgiften med dataanalys, vilket gör att företag kan fokusera på att få värdefulla insikter från sina data.

Vad gör Coupler.io?

Coupler.io fungerar som ett integrationsverktyg som synkroniserar data mellan olika tjänster enligt ett schema. Det gör det möjligt för företag att enkelt exportera och kombinera data från apparna de använder, koppla sina affärsapplikationer till kalkylblad, kalkylblad, databaser eller datavisualiseringsverktyg på några minuter. Coupler.io erbjuder över 200 integrationer, vilket gör det möjligt för företag att samla in och analysera data på ett ställe. Den tillhandahåller också en Transform-modul som låter användare förhandsgranska, transformera och strukturera sina data innan de flyttas till destinationen. Coupler.io automatiserar också datahantering med webhooks, integrerar importörer i interna arbetsflöden för att meddela system om körningsuppdateringsdata i appar, eller starta dataimport automatiskt.

Coupler.io Nyckelfunktioner

Dataintegration: Coupler.io tillhandahåller en robust dataintegreringsfunktion som gör att företag kan ansluta sina applikationer till olika datakällor, vilket gör att de kan samla in och analysera data på ett ställe.

Datatransformation: Med Transform-modulen kan användare förhandsgranska, transformera och strukturera sina data direkt i Coupler.io innan de flyttas till destinationen. Den här funktionen gör att företag kan fokusera på den data som är viktigast för dem.

Automation: Coupler.io automatiserar datahantering med webhooks, integrerar importörer i interna arbetsflöden för att meddela system om körningsuppdateringsdata i appar, eller starta dataimport automatiskt.

Schemaläggning: Coupler.io tillhandahåller schemaläggningsalternativ för att automatisera datauppdateringsprocessen. Användare kan ställa in specifika intervall för verktyget för att automatiskt uppdatera importerad data, vilket säkerställer att rapporter eller analyser alltid är uppdaterade.

Stöd för olika datatyper: Coupler.io stöder olika datatyper, inklusive siffror, datum, texter och till och med bilder, vilket ger flexibilitet vid datahantering.

Konsulttjänster för dataanalys: Förutom verktyget för dataintegrering erbjuder Coupler.io konsulttjänster för dataanalys som ger företag expertråd om hur de bäst kan använda sin data.

Coupler.io prisplaner

Coupler.io erbjuder fyra prisplaner för att tillgodose olika affärsbehov.

Starterplan: Priset för $64 per månad, denna plan är designad för 2 användare. Den inkluderar alla källor, 500 körningar per månad och 10,000 XNUMX rader per körning. Uppgifterna uppdateras automatiskt dagligen.

Lagplan: Denna plan kostar $132 per månad och är lämplig för 5 användare. Den inkluderar alla källor, 4,000 50,000 körningar per månad och 30 XNUMX rader per körning. Uppgifterna uppdateras automatiskt upp till var XNUMX:e minut.

Affärsplan: För $332 per månad är den här planen designad för obegränsade användare. Den inkluderar alla källor, över 10,000 100,000 körningar per månad och över 15 XNUMX rader per körning. Uppgifterna uppdateras automatiskt upp till var XNUMX:e minut.

Företagsplan: För priser och funktioner i Enterprise-planen rekommenderas företag att kontakta Coupler.io direkt.

Coupler.io accepterar betal- och kreditkort för betalningar.

7. AWS-lim

AWS Glue är en serverlös dataintegrationstjänst som förenklar processen att upptäcka, förbereda och integrera data från flera källor för analys, maskininlärning och applikationsutveckling. Den stöder ett brett spektrum av arbetsbelastningar och är utformad för att skalas på efterfrågan, vilket ger skräddarsydda verktyg för olika dataintegrationsbehov. AWS Glue är en del av Amazon Web Services (AWS)-sviten, som erbjuder en heltäckande lösning för att hantera och transformera data i alla skala.

Vad gör AWS Glue?

AWS Glue är designad för att effektivisera processen för dataintegration. Den upptäcker, förbereder, flyttar och integrerar data från olika källor, vilket gör den redo för analys, maskininlärning och applikationsutveckling. AWS Glue kan initiera ETL-jobb när ny data kommer in, till exempel kan den konfigureras för att köra ETL-jobb så snart ny data blir tillgänglig i Amazon Simple Storage Service (S3). Den tillhandahåller också en datakatalog för att snabbt upptäcka och söka i flera AWS-datakällor.

AWS Lim Nyckelfunktioner

Dataintegrationsmotoralternativ: AWS Glue erbjuder olika dataintegrationsmotorer för att stödja olika användarbehov och arbetsbelastningar. Den kan köra händelsedrivna ETL-jobb, vilket innebär att den kan initiera dessa jobb så snart ny data kommer in.

AWS limdatakatalog: Med den här funktionen kan användare snabbt upptäcka och söka i flera AWS-datakällor. Datakatalogen är ett beständigt metadatalager för alla dina datatillgångar, oavsett var de finns.

No-Code ETL jobb: AWS Glue ger möjlighet att hantera och övervaka datakvalitet och att skapa ETL-jobb utan behov av kodning. Detta förenklar processen för dataintegration och transformation.

Skala på begäran: AWS Glue är designad för att skala på efterfrågan, vilket gör att den kan stödja alla arbetsbelastningar och anpassa sig efter användarens behov.

Stöd för Git: AWS Glue integreras med Git, ett allmänt använt versionskontrollsystem med öppen källkod. Detta tillåter användare att upprätthålla en historik över ändringar av sina AWS Glue-jobb.

AWS Glue Flex: Detta är en flexibel exekveringsklass som tillåter användare att minska kostnaderna för icke-brådskande arbetsbelastningar.

Prisplaner för AWS lim

AWS Glue erbjuder en mängd olika prisplaner baserade på användarens specifika behov. Prissättningen baseras i första hand på de resurser som förbrukas medan jobben pågår. Användare måste kontakta säljteamet för en prisuppgift.

AWS Glue accepterar betal- och kreditkort, PayPal och banköverföring för betalningar.

8. Stitch

Stitch är en moln-först, öppen källkodsplattform designad för att snabbt flytta data från olika källor till en destination som du väljer. Som ett kraftfullt ETL-verktyg ansluter Stitch till ett brett utbud av datakällor, från databaser som MySQL och MongoDB till SaaS-applikationer som Salesforce och Zendesk. Den är utformad för att kringgå utvecklingsarbetet, vilket gör att teamen kan fokusera på att bygga sin kärnprodukt och få den ut på marknaden snabbare. Stitch är inte ett dataanalys- eller visualiseringsverktyg, men det spelar en avgörande roll i dataförflyttning, och sätter scenen för efterföljande analys med andra verktyg.

Vad gör Stitch?

Stitch är en flexibel, enkel och kraftfull ETL-tjänst som ansluter till alla dina datakällor och replikerar dessa data till en destination som du väljer. Den är utformad för att säkert och tillförlitligt replikera data i vilken volym som helst, så att du kan växa utan att oroa dig för ett ETL-fel. Stitchs infrastruktur är idealisk för att effektivt hantera kritiska arbetsbelastningar och, med flera redundanta skyddsåtgärder, skyddar den mot dataförlust i händelse av ett avbrott. Det är en ETL SaaS-lösning i världsklass som sömlöst överför data från flera källor till en destination, vilket ger en snabb, kostnadseffektiv och problemfri dataintegrationsupplevelse.

Stygn nyckelfunktioner

Automatiserade molndatapipelines: Stitch erbjuder helt automatiserade molndatapipelines, vilket gör det möjligt för team att få insikter snabbare och fokusera på att bygga sin kärnprodukt.

Säker dataförflyttning: Stitch tillhandahåller säkra alternativ för anslutningar till alla datakällor och destinationer, inklusive SSL/TLS, SSH-tunnling och IP-vitlista, vilket säkerställer säkerheten för din data under transport.

Flexibel replikeringskonfiguration: Med Stitch kan du konfigurera din datareplikering enligt dina behov, vilket ger flexibilitet och kontroll över dina datarörelser.

Skalbar och pålitlig ETL: Stitch är utformad för att säkert och tillförlitligt replikera data i vilken volym som helst, så att du kan växa utan att oroa dig för ett ETL-fel.

Plattform med öppen källkod: Stitch är en plattform med öppen källkod som gör det möjligt för utvecklare att skapa och samarbeta kring integrationer med hjälp av ett community-drivet tillvägagångssätt.

Stöd för flera datakällor: Stitch stöder ett brett utbud av datakällor, från databaser som MySQL och MongoDB till SaaS-applikationer som Salesforce och Zendesk, vilket säkerställer omfattande dataintegration.

Prisplaner för stygn

Stitch erbjuder tre prisplaner: Standard, Advanced och Premium. Varje plan är utformad för att tillgodose olika databehov och kommer med sin egen uppsättning funktioner.

Standardplan: Standardplanen är en flexibel plan (som börjar på $1100 per månad) som växer med dina behov. Det ger full tillgång till över 100 datakällor och prissätts baserat på datavolymen över 5 miljoner rader per månad.

Avancerad Plan: Den avancerade planen, som kostar 1,250 XNUMX USD per månad, är designad för mer krävande kunder i företagsskala. Den innehåller ytterligare funktioner och tjänster som inte är tillgängliga i standardplanen.

Premium Plan: Premiumplanen, prissatt till $2,500 XNUMX per månad, är det mest omfattande erbjudandet från Stitch. Den innehåller alla funktioner i den avancerade planen, tillsammans med ytterligare premiumfunktioner.

Stitch accepterar betal- och kreditkort, PayPal och banköverföring för betalningar.

9. Skyvia

Skyvia presenterar sig som en mångsidig molnbaserad plattform designad för att möta en mängd olika datahanteringsbehov. Det erbjuder en omfattande uppsättning verktyg för dataintegration, säkerhetskopiering och åtkomst över olika moln och lokala datakällor. Med fokus på enkelhet och användarvänlighet siktar Skyvia på att effektivisera komplexa dataprocesser, vilket gör dem tillgängliga för både tekniska och icke-tekniska användare. Dess no-code approach möjliggör snabb installation och exekvering av datauppgifter, samtidigt som den ger robusta funktioner för dem som behöver mer avancerade funktioner.

Vad gör Skyvia?

Skyvia är ett mångfacetterat verktyg som förenklar processen att integrera, säkerhetskopiera och hantera data i olika miljöer. Det gör det möjligt för användare att ansluta ett brett utbud av molnapplikationer, databaser och platta filer utan behov av omfattande kodningskunskap. Oavsett om det handlar om att migrera data mellan system, synkronisera poster över plattformar eller ställa in automatiserade arbetsflöden, tillhandahåller Skyvia ett användarvänligt gränssnitt för att utföra dessa uppgifter effektivt. Dessutom erbjuder den möjligheter för säker säkerhetskopiering och återställning av data, vilket säkerställer att viktiga affärsdata är skyddade och lätta att återställa.

Skyvias nyckelfunktioner

Molndataintegration: Skyvias dataintegreringstjänst tillåter användare att ansluta olika datakällor, såsom SaaS-applikationer, databaser och CSV-filer, och flytta data mellan dem sömlöst. Detta inkluderar stöd för alla DML-operationer, som att skapa, uppdatera, ta bort och upphäva poster, vilket säkerställer att data förblir konsekventa och uppdaterade i olika system.

Säkerhetskopiering och återhämtning: Plattformen tillhandahåller robusta säkerhetskopieringslösningar för molndata, vilket säkerställer att användare kan skydda sin information mot oavsiktlig radering eller korruption. Återställningsprocesser är enkla, vilket möjliggör snabb återställning av data vid behov.

Datahantering: Med Skyvia kan användare komma åt och hantera sina data via ett centraliserat gränssnitt. Detta inkluderar förfrågningar, redigering och visualisering av data från olika källor utan behov av direkt interaktion med de underliggande databaserna eller applikationerna.

No-Code Interface: Plattformens gränssnitt utan kod ger användare möjlighet att utföra komplexa datauppgifter utan att skriva en enda rad kod. Detta demokratiserar datahantering och gör den tillgänglig för ett bredare spektrum av användare inom en organisation.

Flexibel schemaläggning: Skyvia erbjuder flexibla schemaläggningsalternativ för dataintegreringsuppgifter, så att användare kan automatisera processer enligt deras specifika krav. Detta kan variera från att köra uppgifter en gång om dagen till nästan realtidssynkronisering, beroende på vald plan.

Avancerad kartläggning och transformation: Användare kan dra nytta av kraftfulla kartfunktioner för att transformera data när de flyttas mellan källor. Detta inkluderar att dela data, använda uttryck och formler och ställa in uppslagningar, vilket är viktigt för att säkerställa att data passar målschemat.

Skyvia prisplaner

Skyvia erbjuder en rad prisplaner för att tillgodose olika användarbehov och budgetar.

Fri plan: Den här planen är utformad för användare som behöver grundläggande integrationsmöjligheter, och erbjuder 10,000 XNUMX poster per månad med daglig schemaläggning och två schemalagda integrationer.

Grundplanen: Grundplanen, som är riktad till små företag eller enskilda användare, till ett pris av 19 USD per månad (15 USD per månad vid årlig fakturering), ökar antalet poster och schemaläggningsalternativ, vilket ger mer flexibilitet för vanliga datauppgifter.

Standardplan: För organisationer med mer krävande integrationsbehov erbjuder standardplanen, som kostar 99 USD per månad (79 USD per månad vid årlig fakturering), ett högre antal poster, tätare schemaläggning och ytterligare funktioner som avancerade kart- och transformationsverktyg.

Professionell plan: Professionsplanen är skräddarsydd för stora företag som kräver omfattande dataintegrationsmöjligheter, inklusive obegränsade schemalagda integrationer och den kortaste exekveringsfrekvensen.

Skyvia accepterar olika betalningsmetoder, inklusive betal- och kreditkort, och banköverföringar, för att tillgodose användarnas preferenser.

10. Azure Data Factory

Azure Data Factory är en molnbaserad dataintegrationstjänst som tillåter användare att skapa, schemalägga och orkestrera dataarbetsflöden. Den är utformad för att underlätta förflyttning och omvandling av data över olika datalager, både på plats och i molnet. Med fokus på användarvänlighet tillhandahåller den ett visuellt gränssnitt för att bygga komplexa ETL-processer som kan skalas för att möta kraven från big data-arbetsbelastningar.

Vad gör Azure Data Factory?

Azure Data Factory gör det möjligt för företag att integrera olika datakällor, oavsett om de finns i olika molntjänster eller lokal infrastruktur. Det fungerar som limet som sammanför data från flera källor, vilket möjliggör datatransformation och analys på ett centraliserat, hanterat sätt. Den här tjänsten stöder en mängd olika ETL- och dataintegreringsscenarier, från enkel dataförflyttning till komplexa databearbetningspipelines, och den kan hantera stora datamängder effektivt.

Azure Data Factory Nyckelfunktioner

Dataintegreringsförmåga: Azure Data Factory erbjuder robusta dataintegreringsfunktioner, vilket gör att användare sömlöst kan ansluta till ett brett utbud av datakällor, inklusive databaser, filsystem och molntjänster.

Visuella dataflöden: Verktyget tillhandahåller ett visuellt gränssnitt för att designa datadrivna arbetsflöden, vilket gör det enklare för användare att ställa in och hantera sina datapipelines utan behov av omfattande kodning.

Hanterade ETL-tjänster: Den levererar en helt hanterad ETL-tjänst, vilket innebär att användare inte behöver oroa sig för infrastrukturhantering och kan fokusera på att designa sin datatransformationslogik.

Support för olika datortjänster: Azure Data Factory integreras med olika Azure-beräkningstjänster, såsom Azure HDInsight och Azure Databricks, vilket möjliggör kraftfull databearbetning och analys.

Schemaläggning och händelsedrivna utlösare: Användare kan schemalägga datapipelines eller ställa in dem att köra som svar på vissa händelser, vilket ger flexibilitet och säkerställer att data behandlas i rätt tid.

Övervaknings- och ledningsverktyg: Tjänsten inkluderar verktyg för att övervaka och hantera datapipelines, vilket ger användarna insyn i sina dataarbetsflöden och möjligheten att felsöka problem när de uppstår.

Prisplaner för Azure Data Factory

Azure Data Factory erbjuder flera prissättningsplaner för att tillgodose olika användarbehov och budgetbegränsningar. Användare kan beräkna sin anpassade plan med hjälp av Azure Data Factory priskalkylator.

Betalningar för Azure Data Factory kan göras med betal- och kreditkort, PayPal och banköverföring.

11. SAS Data Management

SAS Data Management står som en heltäckande lösning utformad för att ge organisationer möjlighet att hantera och optimera datapipelines på ett effektivt sätt. Det är en plattform som vänder sig till över 80,000 XNUMX organisationer, som underlättar sömlös dataanslutning, förbättrade transformationer och robust styrning. Verktyget är konstruerat för att ge en enhetlig bild av data över olika lagringssystem, inklusive databaser, datalager och datasjöar. Den stöder anslutningar med ledande molnplattformar, lokala system och multicloud-datakällor, strömlinjeformar dataarbetsflöden och exekverar ELT med lätthet. SAS Data Management är erkänt för sin förmåga att säkerställa regelefterlevnad, bygga förtroende för data och erbjuda transparens, vilket positionerar sig som ledande inom datakvalitetslösningar.

Vad gör SAS Data Management?

SAS Data Management är ett mångsidigt verktyg som gör det möjligt för företag att hantera sin datalivscykel på ett heltäckande sätt. Det ger ett intuitivt, peka-och-klicka grafiskt användargränssnitt som förenklar komplexa datahanteringsuppgifter. Användare kan fråga och använda data över flera system utan behov av fysisk avstämning eller dataförflyttning, vilket erbjuder en kostnadseffektiv lösning för företagsanvändare. Verktyget stöder masterdatahantering med funktioner som semantiska databeskrivningar och sofistikerad fuzzy matchning för att säkerställa dataintegritet. Dessutom erbjuder SAS Data Management grid-aktiverad lastbalansering och multitrådad parallell bearbetning för snabb datatransformation och rörelse, vilket eliminerar behovet av överlappande, redundanta verktyg och säkerställer en enhetlig datahanteringsmetod.

SAS Data Management Nyckelfunktioner

Sömlös dataanslutning: SAS Data Management utmärker sig när det gäller att koppla samman olika datakällor, vilket ger användarna möjlighet att komma åt och integrera data över olika plattformar utan att behöva manuellt ingripa.

Förbättrade transformationer: Verktyget erbjuder avancerade datatransformationsfunktioner som gör det möjligt för användare att manipulera och förfina sin data effektivt, vilket säkerställer att den är redo för analys och rapportering.

Robust styrning: Med SAS Data Management kan organisationer tillämpa policyer för datastyrning, säkerställa datakvalitet och överensstämmelse med regulatoriska standarder.

Unified Data View: Det ger en heltäckande bild av en organisations datalandskap, vilket gör det lättare att hantera och analysera data från en central punkt.

Lågkodsvisuell designer: Plattformen innehåller en självbetjäningsdesigner med låg kod som förenklar skapandet och hanteringen av datapipelines, vilket gör den tillgänglig för användare med varierande teknisk expertis.

Regelefterlevnad: SAS Data Management säkerställer att datahanteringsprocesser uppfyller branschreglerna, vilket hjälper organisationer att upprätthålla förtroende och transparens i sina datahanteringsmetoder.

SAS Data Management prissättningsplaner

SAS Data Management erbjuder skräddarsydda prisplaner skräddarsydda för organisationers specifika behov. För att förstå hela utbudet av prisalternativ och funktionerna som ingår i varje plan, uppmuntras intresserade parter att begära en demo.

12. Google Cloud Dataflow

Google Cloud Dataflow är en helt hanterad tjänst som förenklar komplexiteten i storskalig databehandling. Den erbjuder en enhetlig programmeringsmodell för både batch- och strömbehandling, vilket innebär att den kan hantera både bearbetning av lagrad historisk data och realtidsdata när den genereras. Som en del av Google Cloud-ekosystemet integreras Dataflow sömlöst med andra tjänster som BigQuery, Pub/Sub och Cloud Storage, vilket ger en heltäckande lösning för ETL-uppgifter, realtidsanalys och beräkningsutmaningar. Dess serverlösa tillvägagångssätt innebär att användare inte behöver hantera den underliggande infrastrukturen, vilket gör att de kan fokusera på analysen och insikterna snarare än de operativa aspekterna av sina datapipelines.

Vad gör Google Cloud Dataflow?

Google Cloud Dataflow är utformat för att tillhandahålla en skalbar och serverlös miljö för databearbetningsuppgifter. Det gör det möjligt för användare att skapa komplexa ETL-, batch- och strömbearbetningspipelines som kan ta in data från olika källor, omvandla dem enligt affärslogik och sedan ladda in dem i analysmotorer eller databaser för vidare analys. Dataflows förmåga att hantera både batch- och realtidsdata gör den mångsidig för ett brett spektrum av användningsfall, från bedrägeriupptäckt i realtid till daglig logganalys. Tjänsten abstraherar tillhandahållandet av resurser, skalas automatiskt för att möta jobbets krav och tillhandahåller en uppsättning verktyg för att övervaka och optimera pipelines, vilket säkerställer att data bearbetas effektivt och tillförlitligt.

Nyckelfunktioner för Google Cloud Dataflow

Unified Stream och Batch Processing: Dataflow erbjuder en enda modell för bearbetning av både streaming- och batchdata, vilket förenklar pipelineutveckling och möjliggör konsekvent, mer hanterbar kod.

Serverlös drift: Användare kan fokusera på kodning snarare än infrastruktur, eftersom Dataflow automatiskt tillhandahåller och hanterar nödvändiga resurser.

Automatisk skalning: Tjänsten skalar resurser upp eller ner baserat på arbetsbelastningen, vilket säkerställer effektiv bearbetning utan överprovisionering.

Integration med Googles molntjänster: Dataflow integreras med BigQuery, Pub/Sub och andra Google Cloud-tjänster, vilket möjliggör sömlösa dataanalyslösningar.

Inbyggd feltolerans: Dataflow säkerställer konsekventa och korrekta resultat, oavsett storleken på data eller beräkningens komplexitet, genom att tillhandahålla inbyggd feltolerans.

Utvecklingsverktyg: Den erbjuder verktyg för att bygga, felsöka och övervaka datapipelines, vilket hjälper till att upprätthålla hög prestanda och tillförlitlighet.

Prisplaner för Google Cloud Dataflow

Google Cloud Dataflow erbjuder en mängd olika prisplaner som är skräddarsydda för olika användningsmönster och budgetar. Prissättningen baseras på de resurser som förbrukas av jobben, såsom CPU, minne och lagring, och faktureras per sekund, vilket ger detaljerad kontroll över kostnaderna. Användare måste kontakta säljteamet för information om prisplaner:

Dataflow Shuffle: Denna funktion är prissatt baserat på mängden data som behandlas under läs- och skrivoperationer, vilket är viktigt för operationer som involverar blandning av stora datamängder.

Konfidentiell VM-prissättning: Dataflow erbjuder konfidentiella virtuella datorer till ett globalt pris, vilket säkerställer att kostnaderna är förutsägbara och inte varierar beroende på region.

Kompletterande resurser: Även om Dataflow-jobb kan förbruka resurser som Cloud Storage, Pub/Sub och BigQuery, faktureras dessa separat enligt deras specifika prissättning.

Dataflow Prime: För användare som behöver avancerade funktioner och optimeringar är Dataflow Prime tillgängligt, vilket inkluderar ytterligare priser för funktioner som Persistent Disk, GPU:er och ögonblicksbilder.

Betalning för Google Cloud Dataflow-tjänster kan göras med betal- och kreditkort, PayPal och banköverföringar, vilket erbjuder flexibilitet i betalningsmetoder.

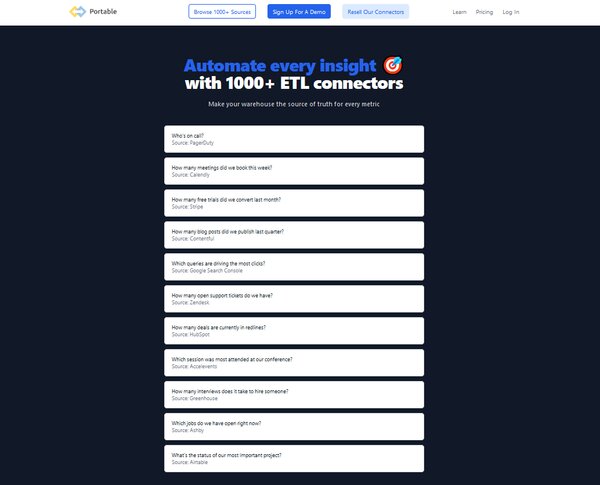

13. Bärbar

Portable är ett molnbaserat ETL-verktyg utformat för att effektivisera processen för dataintegration för företag. Det förenklar de komplexa och ofta tekniska aspekterna av datapipelines, vilket gör det tillgängligt för användare utan omfattande kodningskunskap. Portables plattform är konstruerad för att hantera hela ETL-processen, vilket inkluderar att extrahera data från olika källor, omvandla den för att passa operativa behov och ladda den i ett destinationssystem för analys och business intelligence. Det här verktyget är särskilt fördelaktigt för organisationer som vill automatisera sina dataarbetsflöden och utnyttja molninfrastrukturen för att hantera datautvinning, datatransformation under flygning och dataladdning utan att behöva underhålla sin egen infrastruktur.

Vad gör Portable?

Portable tillhandahåller en kodlös lösning för att skapa datapipelines, vilket gör det möjligt för användare att ansluta till över 500 datakällor. Den är utformad för att hantera krångligheterna med dataöverföringslogik, som att göra API-anrop, bearbeta svar, hanteringsfel och hastighetsgränser. Portable tar också hand om omvandling av data under flygning genom att definiera datatyper, skapa scheman och säkerställa att anslutningsnycklar finns, samt organisera ostrukturerad data för nedströms behov. Plattformen är lämplig för företag av alla storlekar som kräver en pålitlig och skalbar lösning för att integrera sina data över olika system och plattformar, oavsett om det är för analys-, rapporterings- eller operativa syften.

Bärbara nyckelfunktioner

Över 500 dataanslutare: Portable erbjuder ett omfattande utbud av ETL-kontakter, vilket gör att företag kan integrera data från en mängd olika källor sömlöst.

Molnbaserad lösning: Som ett molnbaserat ETL-verktyg är Portable värd på leverantörens servrar, vilket innebär att användare kan komma åt tjänsten var som helst och inte behöver oroa sig för underhåll av infrastruktur.

No-Code Interface: Plattformen tillhandahåller ett användarvänligt gränssnitt utan kod som gör det enkelt för icke-tekniska användare att konfigurera och hantera datapipelines.

Anpassad anslutningsutveckling: För unika datakällor tillåter Portable utveckling av anpassade kontakter, vilket ger flexibilitet och kontroll över dataintegration.

Fast avgift prismodell: Portable använder en attraktiv modell för fast avgiftsprissättning, vilket gör det lättare för företag att förutse sina utgifter utan att oroa sig för datavolymtak.

Datatransformation i realtid: Möjligheten att utföra datatransformation i realtid är en annan nyckelfunktion som säkerställer att data alltid är uppdaterad och korrekt för beslutsprocesser.

Bärbara prisplaner

Portable erbjuder tre huvudsakliga prissättningsplaner för att tillgodose olika affärsbehov:

Starterplan: Den här planen, som kostar $200 per månad, är designad för dem som precis har börjat med dataintegration, och erbjuder 1 schemalagt dataflöde och funktioner som obegränsade datavolymer, färskhetsfält och flödesschemaläggning var 24:e timme.

Skalplan: Skalaplanen, som är inriktad på växande företag, till ett pris av 1,000 10 USD per månad, inkluderar upp till 15 schemalagda dataflöden, tätare flödesschemaläggning var XNUMX:e minut och kommande funktioner som fleranvändarkonton och webhook-aviseringar.

Tillväxtplan: För företag med omfattande dataintegrationsbehov ger tillväxtplanen 10+ schemalagda dataflöden, schemaläggning av flöden i nästan realtid och ytterligare kommande funktioner som administratörs-API-åtkomst.

Portable accepterar olika betalningsmetoder, inklusive betal- och kreditkort, PayPal och banköverföringar, vilket ger användarna flexibilitet att hantera sina prenumerationer.

Vanliga frågor om ETL-verktyg

Vad är ett ETL-verktyg?

Ett ETL-verktyg är ett program som används för att extrahera, transformera och ladda data från olika källor till ett datalager eller annat målsystem. Dessa verktyg automatiserar processen för dataintegration, säkerställer datakvalitet och konsistens och minskar tiden och ansträngningen som krävs för att förbereda data för analys.

Varför är ETL-verktyg viktiga?

ETL-verktyg är avgörande i dagens datadrivna värld eftersom de automatiserar processen att extrahera data från olika källor, omvandla den till ett standardiserat format och ladda in den i ett datalager. Denna automatisering sparar inte bara tid och resurser utan förbättrar också datakvaliteten och konsistensen, vilket gör det möjligt för företag att fatta datadrivna beslut mer effektivt.

Hur fungerar ETL-verktyg?

ETL-verktyg fungerar genom att extrahera data från olika källor, omvandla dem för att uppfylla de nödvändiga kvalitetsstandarderna och sedan ladda in dem i ett datalager eller annat målsystem. De automatiserar hela processen, minskar fel och påskyndar dataintegration.

Vilka är de viktigaste egenskaperna hos ETL-verktyg?

Nyckelfunktioner i ETL-verktyg inkluderar stöd för flera datakällor, ett intuitivt användargränssnitt för enkel datamanipulering och skalbarhet för att hantera stora datamängder. De bör också tillhandahålla datakvalitet och profileringsmöjligheter, stöd för både molndata och data på plats och vara kostnadseffektiva.

Vilka är utmaningarna med att använda ETL-verktyg?

Medan ETL-verktyg erbjuder många fördelar, erbjuder de också vissa utmaningar. Dessa inkluderar behovet av teknisk expertis för att installera och hantera verktygen, hantera olika datakällor och säkerställa datasäkerhet under ETL-processen.

Vilka typer av ETL-verktyg finns tillgängliga?

Det finns flera typer av ETL-verktyg tillgängliga, inklusive verktyg med öppen källkod, molnbaserade tjänster och företagsprogramvara. Valet av verktyg beror på organisationens specifika behov och resurser.

Hur väljer man rätt ETL-verktyg?

Att välja rätt ETL-verktyg beror på flera faktorer, inklusive komplexiteten i dina datakrav, mängden data du behöver bearbeta, vilka typer av datakällor du arbetar med och din budget. Det är också viktigt att ta hänsyn till verktygets användargränssnitt, skalbarhet och supporttjänster.

Kan icke-tekniska användare använda ETL-verktyg?

Ja, många ETL-verktyg kommer med grafiska användargränssnitt som gör dem tillgängliga för icke-tekniska användare. En grundläggande förståelse för ETL-processer och datahanteringsprinciper är dock fördelaktigt.

Vad är framtiden för ETL-verktyg?

Framtiden för ETL-verktyg ligger i deras förmåga att hantera allt mer komplexa datalandskap, inklusive realtidsdataströmmar och olika datakällor. Framsteg inom AI och maskininlärning förväntas också förbättra kapaciteten hos ETL-verktyg, vilket gör dem ännu mer effektiva och effektiva.

Används ETL-verktyg endast för datalagring?

Även om ETL-verktyg ofta används i datalager, är de inte begränsade till denna applikation. De kan också användas för datamigrering, dataintegration och datatransformation i olika andra sammanhang.

Slutsats

ETL-verktyg spelar en avgörande roll i dagens datadrivna affärsmiljö. De effektiviserar processen att extrahera, transformera och ladda data, vilket gör den redo för analys och beslutsfattande. Med sin förmåga att hantera olika datakällor och stora mängder data är ETL-verktyg oumbärliga för alla organisationer som strävar efter att utnyttja sin data effektivt. När tekniken fortsätter att utvecklas kan vi förvänta oss att ETL-verktygen blir ännu mer kraftfulla och mångsidiga, vilket ytterligare ökar deras värde för företag.

I en värld av big data är ETL-verktyg de obesjungna hjältarna. De arbetar bakom kulisserna och säkerställer att data är rena, konsekventa och redo för analys. Genom att automatisera komplexa datahanteringsuppgifter frigör de tid och resurser, vilket gör det möjligt för företag att fokusera på det som verkligen betyder något – att använda sin data för att driva strategiska beslut. När vi går framåt kommer ETL-verktygens betydelse bara att öka, vilket gör dem till en nyckelkomponent i alla framgångsrika datastrategier.