13 najlepszych narzędzi ETL

W dobie big data firmy są zalewane informacjami z wielu źródeł. Dane te, jeśli zostaną odpowiednio wykorzystane, mogą dostarczyć bezcennych spostrzeżeń, które pomogą w podejmowaniu strategicznych decyzji. Wyzwanie polega jednak na wydajnym wyodrębnianiu, przekształcaniu i ładowaniu (ETL) tych danych do formatu, który jest gotowy do analizy. Odpowiedzią na to wyzwanie są narzędzia ETL. Są to oprogramowanie zaprojektowane specjalnie do wspierania procesów ETL, takich jak wyodrębnianie danych z różnych źródeł, oczyszczanie i czyszczenie danych w celu uzyskania wyższej jakości oraz konsolidowanie ich wszystkich w hurtowniach danych. Narzędzia ETL upraszczają strategie zarządzania danymi i poprawiają jakość danych dzięki ustandaryzowanemu podejściu, co czyni je niezbędnym elementem każdej organizacji opartej na danych.

Co to jest narzędzie ETL?

ETL, czyli Extract, Transform, and Load, to proces integracji danych, który łączy dane z wielu źródeł w jeden spójny magazyn danych, który jest ładowany do hurtowni danych lub innego systemu docelowego. Proces rozpoczyna się od wyodrębnienia danych z różnych źródeł, do których mogą należeć bazy danych, aplikacje lub pliki. Te surowe dane są następnie tymczasowo przechowywane w obszarze przejściowym.

W fazie transformacji surowe dane są przetwarzane i przygotowywane do zamierzonego wykorzystania. Może to obejmować czyszczenie danych, usuwanie duplikatów i konwertowanie ich do formatu zgodnego z systemem docelowym. Przekształcone dane są następnie ładowane do systemu docelowego, takiego jak hurtownia danych. Proces ten jest zazwyczaj zautomatyzowany i dobrze zdefiniowany, co pozwala na wydajną i dokładną integrację danych.

ETL to kluczowy element hurtowni danych i analityki biznesowej, umożliwiający organizacjom konsolidację danych w jednym miejscu na potrzeby analiz i raportowania. Zapewnia systematyczny i dokładny sposób analizy danych, zapewniając, że wszystkie dane przedsiębiorstwa są spójne i aktualne. Proces ETL ewoluował z biegiem czasu, a nowoczesne narzędzia ETL oferują bardziej zaawansowane funkcje i możliwości, takie jak integracja danych w czasie rzeczywistym i przetwarzanie danych w chmurze.

Potrzeba narzędzi ETL

W dzisiejszym świecie opartym na danych zapotrzebowanie na narzędzia ETL jest pilniejsze niż kiedykolwiek. Firmy codziennie generują ogromne ilości danych, a ręczne procesy ETL nie są już możliwe. Narzędzia ETL automatyzują procesy ekstrakcji, transformacji i ładowania, zapewniając, że dane są dokładne i gotowe do analizy. Rozbijają silosy danych, ułatwiając analitykom danych dostęp do danych i ich analizę, przekształcając je w użyteczną analizę biznesową. Narzędzia ETL poprawiają także jakość danych, usuwając niespójności i anomalie, a także upraszczają proces integracji danych, płynnie łącząc dane z różnych źródeł. Przekłada się to na oszczędność czasu, gdyż eliminuje się potrzebę odpytywania wielu źródeł danych, co przyspiesza procesy decyzyjne.

Jak działają narzędzia ETL?

Narzędzia ETL działają w trzech głównych etapach: ekstrakcji, transformacji i ładowania. Na etapie ekstrakcji dane są pobierane z różnych źródeł, od baz danych i aplikacji po arkusze kalkulacyjne i przechowywanie w chmurze. Dane te są następnie przekształcane, co obejmuje czyszczenie, sprawdzanie poprawności i ponowne formatowanie danych, aby upewnić się, że spełniają niezbędne standardy jakości. Ostatnim etapem jest ładowanie, podczas którego przekształcone dane są ładowane do hurtowni danych lub innego systemu docelowego w celu przechowywania i analizy. Narzędzia ETL automatyzują cały ten proces, redukując błędy i przyspieszając integrację danych. Zapewniają także interfejsy graficzne umożliwiające szybsze i łatwiejsze uzyskiwanie wyników niż tradycyjne metody przenoszenia danych za pośrednictwem ręcznie kodowanych potoków danych.

13 najlepszych narzędzi ETL

- Zintegruj.io

- Taland

- IBM DataStage

- Integrator danych Oracle

- Pięciotran

- Łącznik.io

- Klej AWS

- ścieg

- Skyvia

- Fabryka danych Azure

- Zarządzanie danymi SAS

- Przepływ danych Google Cloud

- Przenośny

Jak wybrać najlepsze narzędzia ETL?

Wybór odpowiednich narzędzi ETL zależy od kilku czynników. Najpierw rozważ złożoność wymagań dotyczących danych. Świetne narzędzie ETL powinno być w stanie szybko i sprawnie przenosić i przekształcać duże ilości danych przy minimalnym wysiłku. Powinien także obsługiwać wiele źródeł danych, aby można było łatwo łączyć zestawy danych z różnych źródeł. Intuicyjny interfejs użytkownika jest kluczem do szybkiego manipulowania danymi, konfigurowania ustawień i planowania zadań. Dodatkowo weź pod uwagę skalowalność narzędzia, złożoność wymagań dotyczących integracji danych i budżet. Różne organizacje mogą mieć różne potrzeby, dlatego najlepsze narzędzie ETL może się różnić w zależności od konkretnej sytuacji i przypadków użycia.

Narzędzia ETL (bezpłatne i płatne)

1. Zintegruj.io

Integrate.io to wiodące rozwiązanie do integracji danych, które zapewnia ujednoliconą platformę integracji hurtowni danych o niskim poziomie kodu. Oferuje kompleksowy zestaw narzędzi i złączy wspierających całą podróż danych. Dzięki przyjaznemu dla użytkownika interfejsowi i solidnej funkcjonalności Integrate.io umożliwia firmom konsolidację, przetwarzanie i przygotowywanie danych do analiz, umożliwiając w ten sposób świadome podejmowanie decyzji.

Co robi Integrate.io?

Integrate.io służy jako narzędzie ETL oparte na chmurze, które umożliwia tworzenie wizualizowanych potoków danych na potrzeby zautomatyzowanych przepływów danych w szerokim zakresie źródeł i miejsc docelowych. Zapewnia środowisko wolne od kodowania i żargonu, dzięki czemu jest dostępne zarówno dla użytkowników technicznych, jak i nietechnicznych. Integrate.io ułatwia wdrażanie architektury sterowanej zdarzeniami, strumieniowanie danych w czasie rzeczywistym i tworzenie interfejsów API przy minimalnej liczbie kodowania, rozwiązując wyzwania, takie jak nieelastyczne potoki przetwarzania danych i ograniczenia skalowalności.

Kluczowe funkcje Integrate.io

Łatwe transformacje danych: Integrate.io upraszcza procesy ETL i ELT, oferując prosty interfejs użytkownika typu „przeciągnij i upuść” o niewielkiej zawartości kodu oraz kilkanaście transformacji – takich jak sortowanie, łączenie, filtrowanie, wybieranie, ograniczanie, klonowanie itp.

Proste tworzenie przepływu pracy w celu definiowania zależności między zadaniami: Ta funkcja pozwala użytkownikom łatwo zdefiniować kolejność i zależności zadań przetwarzania danych, zapewniając efektywny i wolny od błędów przepływ danych.

REST API: Integrate.io zapewnia kompleksowe rozwiązanie API REST, umożliwiające użytkownikom tworzenie interfejsów API przy minimalnym kodowaniu i elastycznym wdrażaniu.

Integracje Salesforce z Salesforce: ta funkcja umożliwia użytkownikom wyodrębnianie danych Salesforce, przekształcanie ich i wstrzykiwanie z powrotem do Salesforce, oferując wyjątkową korzyść przedsiębiorstwom, które w dużym stopniu polegają na danych Salesforce w CRM i innych operacjach biznesowych.

Bezpieczeństwo danych i zgodność: Integrate.io zapewnia bezpieczeństwo Twoich danych dzięki natywnym funkcjom szyfrowania i zgodności z przepisami o ochronie danych.

Zróżnicowane opcje źródeł danych i miejsc docelowych: Integrate.io obsługuje szeroką gamę źródeł i miejsc docelowych danych, zapewniając elastyczność i wszechstronność w integracji danych.

Plany cenowe Integrate.io

Integrate.io oferuje trzy główne plany cenowe: plan Enterprise, plan Professional i plan startowy.

Plan Enterprise: ten plan jest przeznaczony dla dużych firm o dużych potrzebach w zakresie integracji danych. Oferuje zaawansowane funkcje i wsparcie premium. Ceny tego planu są niestandardowe i można je uzyskać, kontaktując się bezpośrednio z Integrate.io.

Profesjonalny plan: Ten plan, którego cena wynosi 25,000 XNUMX USD rocznie, jest odpowiedni dla średnich firm. Oferuje równowagę zaawansowanych funkcji i przystępności cenowej.

Plan kroczący: Ten plan, wyceniony na 15,000 XNUMX USD rocznie, jest idealny dla małych firm lub start-upów z podstawowymi potrzebami w zakresie integracji danych. Oferuje niezbędne funkcje w przystępnej cenie.

Integrate.io akceptuje karty debetowe i kredytowe oraz przelewy bankowe w celu płatności.

2. Taland

Talend to kompleksowe rozwiązanie do zarządzania danymi, z którego korzystają tysiące organizacji w celu przekształcania danych w przydatne wnioski biznesowe. Jest to elastyczna i zaufana platforma, która obsługuje kompleksowe zarządzanie danymi w całej organizacji, od integracji po dostawę. Talend można wdrożyć lokalnie, w chmurze lub w środowisku hybrydowym, co czyni go wszechstronnym narzędziem dla dowolnej architektury danych. Został zaprojektowany tak, aby zapewniać jasną i przewidywalną wartość, jednocześnie wspierając potrzeby w zakresie bezpieczeństwa i zgodności.

Co robi Taland?

Talend zapewnia ujednolicone narzędzia do programowania i zarządzania umożliwiające integrację i przetwarzanie wszystkich danych. Jest to platforma integracji oprogramowania oferująca rozwiązania w zakresie integracji danych, jakości danych, zarządzania danymi, przygotowywania danych i dużych zbiorów danych. Talend pomaga organizacjom podejmować decyzje w czasie rzeczywistym i w większym stopniu opierać się na danych, zwiększając ich dostępność, poprawiając ich jakość i szybko przenosząc je do systemów docelowych. Jest to jedyne narzędzie ETL posiadające wszystkie wtyczki umożliwiające łatwą integrację z ekosystemem Big Data.

Kluczowe funkcje Talandu

Integracja danych: Talend oferuje solidne możliwości integracji danych. Zawiera szereg szablonów SQL, które upraszczają najczęstsze zapytania i aktualizację danych, tworzenie i modyfikowanie schematów oraz zadania związane z zarządzaniem danymi.

Jakość danych: Talend zapewnia jakość danych, udostępniając funkcje profilowania, czyszczenia i monitorowania danych. Pomaga firmom poprawić jakość ich danych, czyniąc je bardziej dostępnymi i szybko przenoszonymi do systemów docelowych.

Zarządzanie danymi: Talend wspiera zarządzanie danymi, udostępniając funkcje katalogowania danych, pochodzenia danych i prywatności danych. Pomaga organizacjom zachować zgodność z przepisami dotyczącymi danych i zapewnić bezpieczeństwo ich danych.

Platforma o niskim kodzie: Talend to platforma wymagająca niewielkiej ilości kodu, która upraszcza proces opracowywania przepływów pracy związanych z integracją danych. Zapewnia projektanta wizualnego, który ułatwia tworzenie potoków danych i zarządzanie nimi.

Skalowalność: Talend zaprojektowano z myślą o płynnym skalowaniu w miarę wzrostu zapotrzebowania na dane. Może obsłużyć duże ilości danych i złożone zadania przetwarzania danych, co czyni go przyszłościową inwestycją dla firm.

Integracja chmury i Big Data: Talend obsługuje integrację z różnymi platformami chmurowymi i technologiami Big Data. Zapewnia złącza do pakietów aplikacji, baz danych, komputerów mainframe, plików, usług internetowych i nie tylko.

Plany cenowe Talend

Talend oferuje kilka planów cenowych, aby zaspokoić różne potrzeby biznesowe. Dostępne plany obejmują:

Platforma zarządzania danymi: Ten plan oferuje kompleksowe funkcje integracji danych i zarządzania. Jest przeznaczony dla firm, które muszą integrować, oczyszczać i zarządzać danymi z różnych źródeł.

Platforma Big Data: ten plan jest przeznaczony dla firm, które muszą obsługiwać duże ilości danych. Oferuje funkcje integracji dużych zbiorów danych, jakości danych i zarządzania danymi.

Tkanina danych: To najbardziej kompleksowy plan Talend. Łączy w sobie funkcje Data Management Platform i Big Data Platform oraz dodaje dodatkowe możliwości integracji aplikacji i API.

Aby uzyskać informacje o cenach, użytkownicy muszą skontaktować się z zespołem sprzedaży.

3. IBM DataStage

IBM DataStage to solidne i wszechstronne narzędzie ETL, zaprojektowane w celu ułatwienia i usprawnienia procesu integracji danych pomiędzy różnymi systemami. Jego możliwości opierają się na wydajnej architekturze przetwarzania równoległego, która zapewnia skalowalność i wysoką wydajność w przypadku operacji wymagających dużej ilości danych. W ramach IBM Cloud Pak for Data as a Service DataStage oferuje kompleksowe rozwiązanie obsługujące szeroki zakres zadań związanych z integracją danych, od prostych po złożone. Zostało zaprojektowane tak, aby bezproblemowo działać lokalnie lub w chmurze, zapewniając firmom elastyczność w zarządzaniu przepływem danych. Łączność i rozszerzalność platformy dla przedsiębiorstw sprawiają, że jest to odpowiedni wybór dla organizacji, które chcą wykorzystać swoje dane na potrzeby wnikliwych analiz i aplikacji AI, zapewniając niezawodne dostarczanie wysokiej jakości danych interesariuszom.

Do czego służy IBM DataStage?

IBM DataStage doskonale radzi sobie z wyodrębnianiem danych z wielu źródeł, przekształcaniem ich w celu spełnienia wymagań biznesowych i ładowaniem ich do systemów docelowych, niezależnie od tego, czy są to lokalne bazy danych, repozytoria w chmurze czy hurtownie danych. Został zaprojektowany do obsługi szerokiej gamy formatów i struktur danych, umożliwiając firmom łatwą integrację różnych źródeł danych. Potężne możliwości transformacji narzędzia pozwalają na kompleksowe przetwarzanie danych, w tym czyszczenie i monitorowanie danych, aby zapewnić, że dostarczane dane są najwyższej jakości. Dzięki silnikowi przetwarzania równoległego DataStage może efektywnie przetwarzać duże ilości danych, co czyni go idealnym rozwiązaniem dla przedsiębiorstw borykających się z wyzwaniami związanymi z dużymi zbiorami danych. Ponadto jego otwarty i rozszerzalny charakter pozwala na dostosowywanie i integrację z innymi platformami AI i analitycznymi, zapewniając bezproblemową integrację danych, która obsługuje szeroki zakres inicjatyw opartych na danych.

Kluczowe funkcje IBM DataStage

Przetwarzanie równoległe: IBM DataStage wykorzystuje wysokowydajny silnik przetwarzania równoległego, który umożliwia efektywną obsługę dużych wolumenów danych, znacznie skracając czas wymagany na zadania integracji danych.

Łączność korporacyjna: Narzędzie oferuje szerokie opcje łączności, umożliwiając bezproblemową integrację z wieloma systemami korporacyjnymi, bazami danych i aplikacjami, ułatwiając ujednolicony ekosystem danych.

Kompatybilność z chmurą: DataStage zaprojektowano do działania w dowolnym środowisku chmurowym, zapewniając elastyczność i skalowalność firmom chcącym wykorzystać zasoby chmury do swoich potrzeb w zakresie integracji danych.

Czyszczenie i monitorowanie danych: Zawiera funkcje oczyszczania i monitorowania danych, zapewniające, że przetwarzane i dostarczane informacje są dokładne, spójne i wysokiej jakości.

Rozciągliwość: Platforma jest otwarta i rozszerzalna, co pozwala na dostosowywanie i integrację z innymi narzędziami do przetwarzania danych i sztucznej inteligencji, co zwiększa jej możliwości w celu spełnienia określonych wymagań biznesowych.

Kompleksowa integracja danych: DataStage zapewnia kompleksowe rozwiązanie dla całego cyklu życia integracji danych, od ekstrakcji i transformacji po ładowanie, co czyni go kompleksowym rozwiązaniem dla wszystkich działań związanych z integracją danych.

Plany cenowe IBM DataStage

IBM DataStage oferuje różnorodne plany cenowe dostosowane do potrzeb różnych organizacji, od małych firm po duże przedsiębiorstwa. Każdy plan ma zapewniać określone funkcje i możliwości, dzięki czemu firmy mogą wybrać opcję, która najlepiej odpowiada ich wymaganiom i budżetowi w zakresie integracji danych. Użytkownicy muszą skontaktować się z zespołem sprzedaży, aby umówić się na spotkanie w sprawie cen.

IBM DataStage akceptuje płatności kartami debetowymi i kredytowymi.

4. Integrator danych Oracle

Oracle Data Integrator (ODI) to narzędzie ETL i kompleksowa platforma integracji danych, która zaspokaja szeroki zakres potrzeb w zakresie integracji danych. Został zaprojektowany do obsługi dużych wolumenów i wydajnych wsadów, procesów integracji sterowanych zdarzeniami i ciągłego zasilania oraz usług danych z obsługą SOA. Najnowsza wersja, ODI 12c, zapewnia doskonałą produktywność programistów i lepsze doświadczenie użytkownika dzięki przeprojektowanemu, deklaratywnemu interfejsowi użytkownika opartemu na przepływach. Zapewnia także głębszą integrację z Oracle GoldenGate, oferując kompleksową obsługę Big Data i dodatkową równoległość podczas wykonywania procesów integracji danych.

Co robi Oracle Data Integrator?

Oracle Data Integrator to strategiczna oferta integracji danych firmy Oracle, która zapewnia elastyczną i wydajną architekturę do realizacji procesów integracji danych. Został zaprojektowany do obsługi dużych wolumenów i wydajnych wsadów, procesów integracji sterowanych zdarzeniami i ciągłego zasilania oraz usług danych z obsługą SOA. Najnowsza wersja ODI 12c zapewnia doskonałą produktywność programistów i lepsze doświadczenie użytkownika dzięki przeprojektowanemu, deklaratywnemu interfejsowi użytkownika opartemu na przepływie. Zapewnia także głębszą integrację z Oracle GoldenGate, oferując kompleksową obsługę Big Data i dodatkową równoległość podczas wykonywania procesów integracji danych.

Kluczowe funkcje Oracle Data Integrator

Architektura o wysokiej wydajności: Oracle Data Integrator oferuje elastyczną i wydajną architekturę, która pozwala na wydajne procesy integracji danych. Obsługuje wysokoobjętościowe i wydajne ładowanie wsadowe, procesy integracji sterowane zdarzeniami i strumieniowe oraz usługi danych z obsługą SOA.

Udoskonalone działanie użytkowników: Najnowsza wersja, ODI 12c, zapewnia ulepszone doświadczenie użytkownika dzięki przeprojektowanemu, deklaratywnemu interfejsowi użytkownika opartemu na przepływach. Interfejs ten zwiększa produktywność programistów i ułatwia zarządzanie procesami integracji danych oraz ich realizację.

Głęboka integracja z Oracle GoldenGate: Oracle Data Integrator zapewnia głębszą integrację z Oracle GoldenGate. Integracja ta pozwala na kompleksową obsługę Big Data i dodatkową równoległość podczas wykonywania procesów integracji danych.

Wsparcie dużych zbiorów danych: Oracle Data Integrator oferuje kompleksową obsługę dużych zbiorów danych. Bezproblemowo integruje się z platformami Big Data, takimi jak Hadoop i Spark, umożliwiając wydajne przetwarzanie i analizę dużych zbiorów danych.

Wspólny rozwój i kontrola wersji: Oracle Data Integrator oferuje funkcje umożliwiające wspólne tworzenie oprogramowania i kontrolę wersji. Funkcje te ułatwiają zespołowe projekty ETL i zapewniają śledzenie wszystkich zmian i skuteczne zarządzanie nimi.

Solidne funkcje bezpieczeństwa: Oracle Data Integrator oferuje solidne funkcje bezpieczeństwa i integruje się z istniejącymi strukturami bezpieczeństwa. Zapewnia to poufność danych i zgodność z różnymi przepisami o ochronie danych.

Plany cenowe Oracle Data Integrator

Oracle Data Integrator oferuje różnorodne plany cenowe odpowiadające różnym potrzebom użytkowników. Ceny oparte są na modelu licencji na rdzeń, a roczne subskrypcje wahają się od kilku tysięcy do kilkudziesięciu tysięcy dolarów rocznie. Dokładny koszt zależy od liczby wymaganych rdzeni, opcji wdrożenia (w chmurze czy lokalnie) i potrzebnych dodatkowych funkcji. Na przykład podstawowe wdrożenie w chmurze z 2 rdzeniami może kosztować około 5,000 USD rocznie, podczas gdy większe wdrożenie lokalne z 16 rdzeniami i zaawansowanymi funkcjami może kosztować ponad 50,000 XNUMX USD rocznie.

Oracle Data Integrator akceptuje płatności kartami debetowymi i kredytowymi, systemem PayPal oraz przelewem bankowym.

5. Pięciotran

Fivetran to wiodąca platforma zautomatyzowanego przepływu danych, zaprojektowana w celu usprawnienia procesu integracji i centralizacji danych. Jest to solidne narzędzie ETL, które umożliwia firmom samoobsługową analizę, tworzenie niestandardowych rozwiązań w zakresie danych i poświęcanie mniej czasu na integrację systemów. Fivetran to idealna platforma dla inżynierów, analityków i programistów, którzy chcą scentralizować dane na potrzeby raportów, analiz i budowania na danych.

Co robi Fivetran?

Fivetran to oparty na chmurze potok danych, który automatyzuje proces wydobywania danych z różnych źródeł, przekształcania ich do użytecznego formatu i ładowania do hurtowni danych w celu analizy. Usuwa wąskie gardła w procesach danych bez uszczerbku dla zgodności, co czyni go idealnym rozwiązaniem dla firm, które muszą rozszerzyć swoją platformę danych w celu obsługi niestandardowych potrzeb. Niezależnie od tego, czy jesteś inżynierem, który chce spędzać mniej czasu na integracji systemów, analitykiem pracującym z narzędziami SQL lub BI, czy programistą tworzącym dane, API Fivetran i webhooki sprawiają, że jest to wszechstronne narzędzie spełniające wszystkie Twoje potrzeby w zakresie danych.

Kluczowe cechy Fivetrana

Automatyczna integracja danych: Fivetran upraszcza proces integracji danych poprzez automatyzację ekstrakcji, transformacji i ładowania danych z różnych źródeł do hurtowni danych.

Analityka samoobsługowa: Fivetran umożliwia przedsiębiorstwom samoobsługową analizę poprzez usuwanie wąskich gardeł w procesach danych, umożliwiając bardziej efektywną analizę danych i podejmowanie decyzji.

Niestandardowe rozwiązania w zakresie danych: Dzięki Fivetran firmy mogą rozszerzać swoją platformę danych w celu obsługi niestandardowych potrzeb, zapewniając elastyczność i możliwości adaptacji w zarządzaniu danymi.

API i webhooki: Fivetran oferuje API i webhooki, co czyni go idealną platformą dla programistów budujących na danych.

Zgodność bez kompromisów: Fivetran zapewnia zgodność danych bez uszczerbku dla wydajności procesów przetwarzania danych, zapewniając firmom spokój ducha.

Obsługa różnych typów użytkowników: Niezależnie od tego, czy jesteś inżynierem, analitykiem czy programistą, Fivetran zaspokaja Twoje potrzeby w zakresie danych, dzięki czemu jest wszechstronnym narzędziem dla różnych typów użytkowników.

Plany cenowe Fivetran

Fivetran oferuje cztery różne plany cenowe: plan bezpłatny, plan startowy, plan standardowy i plan Enterprise. Aby uzyskać wycenę każdego planu, użytkownicy muszą skontaktować się z zespołem sprzedaży.

Bezpłatny plan: Plan bezpłatny to podstawowa oferta, która pozwala użytkownikom korzystać z podstawowych funkcji Fivetran.

Plan kroczący: Plan startowy obejmuje wszystko, co obejmuje plan bezpłatny, z dodatkowymi funkcjami i możliwościami zaspokajającymi bardziej kompleksowe potrzeby w zakresie integracji danych.

Plan standardowy: Plan standardowy obejmuje wszystko w planie startowym, a także nieograniczoną liczbę użytkowników, 15-minutowe synchronizacje, łączniki z bazami danych i dostęp do interfejsu API REST firmy Fivetran.

Plan Enterprise: Plan Enterprise obejmuje wszystko, co obejmuje plan Standard, a także łączniki korporacyjnych baz danych, 1-minutowe synchronizacje, szczegółowe role i wsparcie dla zespołów, zaawansowane zarządzanie danymi, zaawansowane opcje zabezpieczeń i przechowywania danych oraz priorytetowe wsparcie.

Fivetran akceptuje płatności kartami debetowymi i kredytowymi.

6. Łącznik.io

Coupler.io to wszechstronna platforma do analizy i automatyzacji danych, zaprojektowana w celu usprawnienia procesu gromadzenia, przekształcania i automatyzacji danych. Umożliwia przedsiębiorstwom podejmowanie decyzji w oparciu o dane, zapewniając pojedynczy punkt prawdy pomiędzy różnymi źródłami danych. Dzięki przyjaznemu dla użytkownika interfejsowi i solidnej funkcjonalności Coupler.io upraszcza złożone zadanie analizy danych, umożliwiając firmom skupienie się na wyciąganiu cennych wniosków z ich danych.

Co robi Coupler.io?

Coupler.io służy jako narzędzie integracyjne, które synchronizuje dane pomiędzy różnymi usługami zgodnie z harmonogramem. Umożliwia firmom łatwe eksportowanie i łączenie danych z używanych aplikacji, łącząc aplikacje biznesowe z arkuszami kalkulacyjnymi, arkuszami kalkulacyjnymi, bazami danych lub narzędziami do wizualizacji danych w ciągu kilku minut. Coupler.io oferuje ponad 200 integracji, dzięki którym firmy mogą gromadzić i analizować dane w jednym miejscu. Udostępnia także moduł Transform, który pozwala użytkownikom przeglądać, przekształcać i porządkować dane przed przeniesieniem ich do miejsca docelowego. Coupler.io automatyzuje także zarządzanie danymi za pomocą webhooków, integrując importerów z wewnętrznymi przepływami pracy, aby powiadamiać systemy o wykonaniu odświeżenia danych w aplikacjach lub automatycznie uruchamiać import danych.

Kluczowe funkcje łącznika.io

Integracja danych: Coupler.io zapewnia solidną funkcję integracji danych, która pozwala firmom łączyć swoje aplikacje z różnymi źródłami danych, umożliwiając im gromadzenie i analizowanie danych w jednym miejscu.

Transformacja danych: Dzięki modułowi Transform użytkownicy mogą przeglądać, przekształcać i porządkować swoje dane bezpośrednio w Coupler.io przed przeniesieniem ich do miejsca docelowego. Ta funkcja pozwala firmom skoncentrować się na danych, które są dla nich najważniejsze.

Automatyzacja: Coupler.io automatyzuje zarządzanie danymi za pomocą webhooków, integrując importerów z wewnętrznymi przepływami pracy, aby powiadamiać systemy o wykonaniu odświeżenia danych w aplikacjach lub automatycznie uruchamiać import danych.

Scheduling: Coupler.io zapewnia opcje planowania automatyzujące proces odświeżania danych. Użytkownicy mogą ustawić określone interwały, w których narzędzie będzie automatycznie aktualizować importowane dane, dzięki czemu raporty lub analizy będą zawsze aktualne.

Obsługa różnych typów danych: Coupler.io obsługuje różne typy danych, w tym liczby, daty, teksty, a nawet obrazy, zapewniając elastyczność w przetwarzaniu danych.

Usługi doradcze w zakresie analizy danych: Oprócz narzędzia do integracji danych, Coupler.io oferuje usługi doradcze w zakresie analizy danych, zapewniając firmom fachowe porady dotyczące najlepszego wykorzystania ich danych.

Plany cenowe Coupler.io

Coupler.io oferuje cztery plany cenowe, aby zaspokoić różne potrzeby biznesowe.

Plan kroczący: Plan ten kosztuje 64 USD miesięcznie i jest przeznaczony dla 2 użytkowników. Obejmuje wszystkie źródła, 500 przebiegów miesięcznie i 10,000 XNUMX wierszy na przebieg. Dane są codziennie automatycznie odświeżane.

Plan składu: Ten plan kosztuje 132 USD miesięcznie i jest odpowiedni dla 5 użytkowników. Obejmuje wszystkie źródła, 4,000 przebiegów miesięcznie i 50,000 30 wierszy na przebieg. Dane są automatycznie odświeżane co XNUMX minut.

Biznes Plan: Plan ten kosztuje 332 USD miesięcznie i jest przeznaczony dla nieograniczonej liczby użytkowników. Obejmuje wszystkie źródła, ponad 10,000 100,000 przebiegów miesięcznie i ponad 15 XNUMX wierszy na przebieg. Dane odświeżane są automatycznie co XNUMX minut.

Plan Enterprise: W sprawie cen i funkcji planu Enterprise zaleca się firmom bezpośredni kontakt z Coupler.io.

Coupler.io akceptuje płatności kartami debetowymi i kredytowymi.

7. Klej AWS

AWS Glue to bezserwerowa usługa integracji danych, która upraszcza proces odkrywania, przygotowywania i integrowania danych z wielu źródeł na potrzeby analiz, uczenia maszynowego i tworzenia aplikacji. Obsługuje szeroki zakres obciążeń i umożliwia skalowanie na żądanie, zapewniając narzędzia dostosowane do różnych potrzeb w zakresie integracji danych. AWS Glue jest częścią pakietu Amazon Web Services (AWS), oferującego kompleksowe rozwiązanie do zarządzania i przekształcania danych w dowolnej skali.

Co robi klej AWS?

AWS Glue ma za zadanie usprawnić proces integracji danych. Odkrywa, przygotowuje, przenosi i integruje dane z różnych źródeł, przygotowując je do analityki, uczenia maszynowego i tworzenia aplikacji. AWS Glue może inicjować zadania ETL po nadejściu nowych danych, na przykład można go skonfigurować tak, aby uruchamiał zadania ETL, gdy tylko nowe dane staną się dostępne w Amazon Simple Storage Service (S3). Udostępnia także katalog danych umożliwiający szybkie odkrywanie i przeszukiwanie wielu źródeł danych AWS.

Kluczowe cechy kleju AWS

Opcje silnika integracji danych: AWS Glue oferuje różne silniki integracji danych, aby sprostać różnym potrzebom użytkowników i obciążeniom. Może uruchamiać zadania ETL na podstawie zdarzeń, co oznacza, że może je inicjować natychmiast po nadejściu nowych danych.

Katalog danych kleju AWS: Ta funkcja umożliwia użytkownikom szybkie odkrywanie i przeszukiwanie wielu źródeł danych AWS. Katalog danych to trwały magazyn metadanych dla wszystkich zasobów danych, niezależnie od tego, gdzie się znajdują.

Zadania ETL bez kodu: AWS Glue zapewnia możliwość zarządzania i monitorowania jakości danych oraz tworzenia zadań ETL bez konieczności kodowania. Upraszcza to proces integracji i transformacji danych.

Skaluj na żądanie: AWS Glue został zaprojektowany tak, aby skalować się na żądanie, dzięki czemu może obsługiwać wszystkie obciążenia i dostosowywać się do potrzeb użytkownika.

Wsparcie dla Gita: AWS Glue integruje się z Git, powszechnie używanym systemem kontroli wersji typu open source. Dzięki temu użytkownicy mogą zachować historię zmian w swoich zadaniach klejenia AWS.

Klej AWS Flex: Jest to elastyczna klasa zadań wykonawczych, która pozwala użytkownikom obniżyć koszty niepilnych obciążeń.

Plany cenowe kleju AWS

AWS Glue oferuje różnorodne plany cenowe w oparciu o konkretne potrzeby użytkownika. Ceny opierają się głównie na zasobach zużywanych podczas wykonywania zadań. Użytkownicy muszą skontaktować się z zespołem sprzedaży, aby uzyskać wycenę.

AWS Glue akceptuje karty debetowe i kredytowe, PayPal i przelewy bankowe do płatności.

8. ścieg

Stitch to oparta na chmurze platforma typu open source, zaprojektowana z myślą o szybkim przenoszeniu danych z różnych źródeł do wybranego miejsca docelowego. Jako potężne narzędzie ETL, Stitch łączy się z szeroką gamą źródeł danych, od baz danych takich jak MySQL i MongoDB po aplikacje SaaS, takie jak Salesforce i Zendesk. Został zaprojektowany tak, aby ominąć obciążenie programistyczne, umożliwiając zespołom skupienie się na tworzeniu podstawowego produktu i szybszym wprowadzaniu go na rynek. Stitch nie jest narzędziem do analizy ani wizualizacji danych, ale odgrywa kluczową rolę w przenoszeniu danych, przygotowując grunt pod późniejszą analizę przy użyciu innych narzędzi.

Co robi Stich?

Stitch to elastyczna, łatwa i wydajna usługa ETL, która łączy się ze wszystkimi źródłami danych i replikuje je do wybranego miejsca docelowego. Został zaprojektowany do bezpiecznej i niezawodnej replikacji danych na dowolnym wolumenie, co pozwala na rozwój bez martwienia się o awarię ETL. Infrastruktura Stitch jest idealna do wydajnej obsługi krytycznych obciążeń i dzięki wielu nadmiarowym zabezpieczeniom chroni przed utratą danych w przypadku awarii. Jest to światowej klasy rozwiązanie ETL SaaS, które płynnie przesyła dane z wielu źródeł do miejsca docelowego, zapewniając szybką, opłacalną i bezproblemową integrację danych.

Kluczowe funkcje ściegu

Zautomatyzowane potoki danych w chmurze: Stitch oferuje w pełni zautomatyzowane potoki danych w chmurze, umożliwiając zespołom szybsze uzyskiwanie wglądu i skupienie się na tworzeniu podstawowego produktu.

Bezpieczny przepływ danych: Stitch zapewnia bezpieczne opcje połączeń ze wszystkimi źródłami danych i miejscami docelowymi, w tym SSL/TLS, tunelowanie SSH i białą listę adresów IP, zapewniając bezpieczeństwo danych podczas przesyłania.

Elastyczna konfiguracja replikacji: Dzięki Stitchowi możesz skonfigurować proces replikacji danych zgodnie ze swoimi potrzebami, zapewniając elastyczność i kontrolę nad przesyłaniem danych.

Skalowalny i niezawodny ETL: Stitch został zaprojektowany do bezpiecznej i niezawodnej replikacji danych na dowolnym wolumenie, co pozwala na rozwój bez martwienia się o awarię ETL.

Platforma Open Source: Stitch to platforma typu open source, umożliwiająca programistom tworzenie integracji i współpracę przy integracji przy użyciu podejścia kierowanego przez społeczność.

Obsługa wielu źródeł danych: Stitch obsługuje szeroką gamę źródeł danych, od baz danych takich jak MySQL i MongoDB po aplikacje SaaS, takie jak Salesforce i Zendesk, zapewniając kompleksową integrację danych.

Plany cenowe Stitcha

Stitch oferuje trzy plany cenowe: Standard, Advanced i Premium. Każdy plan został zaprojektowany tak, aby zaspokoić różne potrzeby w zakresie danych i ma własny zestaw funkcji.

Plan standardowy: Plan standardowy to plan elastyczny (zaczynający się od 1100 USD miesięcznie), który rośnie wraz z Twoimi potrzebami. Zapewnia pełny dostęp do ponad 100 źródeł danych i wyceniany jest w oparciu o wolumen danych powyżej 5 milionów wierszy miesięcznie.

Zaawansowany plan: Plan zaawansowany, którego cena wynosi 1,250 USD miesięcznie, jest przeznaczony dla bardziej wymagających klientów w skali korporacyjnej. Zawiera dodatkowe funkcje i usługi niedostępne w Planie Standardowym.

Plan Premium: Plan Premium, którego cena wynosi 2,500 USD miesięcznie, to najbardziej wszechstronna oferta firmy Stitch. Zawiera wszystkie funkcje planu zaawansowanego wraz z dodatkowymi funkcjami premium.

Stitch akceptuje płatności kartami debetowymi i kredytowymi, systemem PayPal oraz przelewem bankowym.

9. Skyvia

Skyvia prezentuje się jako wszechstronna platforma oparta na chmurze, zaprojektowana z myślą o zaspokajaniu różnorodnych potrzeb w zakresie zarządzania danymi. Oferuje kompleksowy zestaw narzędzi do integracji danych, tworzenia kopii zapasowych i dostępu do różnych źródeł danych w chmurze i lokalnych. Koncentrując się na prostocie i łatwości użytkowania, Skyvia dąży do usprawnienia złożonych procesów danych, czyniąc je dostępnymi zarówno dla użytkowników technicznych, jak i nietechnicznych. Podejście bez kodu pozwala na szybką konfigurację i wykonanie zadań związanych z danymi, zapewniając jednocześnie solidne możliwości tym, którzy wymagają bardziej zaawansowanych funkcji.

Co robi Skyvia?

Skyvia to wieloaspektowe narzędzie, które upraszcza proces integracji, tworzenia kopii zapasowych i zarządzania danymi w różnych środowiskach. Umożliwia użytkownikom łączenie szerokiej gamy aplikacji w chmurze, baz danych i plików płaskich bez konieczności posiadania rozległej wiedzy na temat kodowania. Niezależnie od tego, czy chodzi o migrację danych między systemami, synchronizację rekordów między platformami, czy konfigurowanie zautomatyzowanych przepływów pracy, Skyvia zapewnia przyjazny dla użytkownika interfejs umożliwiający wydajną realizację tych zadań. Dodatkowo oferuje możliwości bezpiecznego tworzenia kopii zapasowych i przywracania danych, zapewniając ochronę kluczowych danych biznesowych i łatwe ich odzyskanie.

Kluczowe funkcje Skyvii

Integracja danych w chmurze: Usługa integracji danych Skyvia umożliwia użytkownikom łączenie różnych źródeł danych, takich jak aplikacje SaaS, bazy danych i pliki CSV, oraz płynne przenoszenie danych między nimi. Obejmuje to obsługę wszystkich operacji DML, takich jak tworzenie, aktualizowanie, usuwanie i wstawianie rekordów, zapewniając, że dane pozostają spójne i aktualne w różnych systemach.

Kopie zapasowe i odzyskiwanie: Platforma zapewnia niezawodne rozwiązania do tworzenia kopii zapasowych danych w chmurze, dzięki czemu użytkownicy mogą chronić swoje informacje przed przypadkowym usunięciem lub uszkodzeniem. Procesy odzyskiwania są proste i pozwalają na szybkie przywrócenie danych w razie potrzeby.

Zarządzanie danymi: Dzięki Skyvia użytkownicy mogą uzyskać dostęp do swoich danych i zarządzać nimi za pośrednictwem scentralizowanego interfejsu. Obejmuje to wykonywanie zapytań, edytowanie i wizualizowanie danych z różnych źródeł bez konieczności bezpośredniej interakcji z bazami danych lub aplikacjami.

Interfejs bez kodu: Niekodujący interfejs platformy umożliwia użytkownikom wykonywanie złożonych zadań związanych z danymi bez pisania ani jednej linijki kodu. Demokratyzuje to zarządzanie danymi, czyniąc je dostępnymi dla szerszego grona użytkowników w organizacji.

Elastyczne planowanie: Skyvia oferuje elastyczne opcje planowania zadań związanych z integracją danych, umożliwiając użytkownikom automatyzację procesów zgodnie z ich specyficznymi wymaganiami. Może to obejmować uruchamianie zadań raz dziennie lub synchronizację niemal w czasie rzeczywistym, w zależności od wybranego planu.

Zaawansowane mapowanie i transformacja: Użytkownicy mogą korzystać z zaawansowanych funkcji mapowania, aby przekształcać dane podczas ich przesyłania między źródłami. Obejmuje to dzielenie danych, używanie wyrażeń i formuł oraz konfigurowanie wyszukiwań, które są niezbędne do zapewnienia, że dane pasują do schematu docelowego.

Plany cenowe Skyvii

Skyvia oferuje szereg planów cenowych dostosowanych do różnych potrzeb użytkowników i budżetów.

Bezpłatny plan: Ten plan jest przeznaczony dla użytkowników wymagających podstawowych możliwości integracji i oferuje 10,000 XNUMX rekordów miesięcznie z harmonogramem dziennym i dwiema zaplanowanymi integracjami.

Podstawowy plan: Skierowany do małych firm lub użytkowników indywidualnych, plan podstawowy, którego cena wynosi 19 USD miesięcznie (15 USD miesięcznie przy rozliczeniu rocznym), zwiększa liczbę rekordów i opcji planowania, zapewniając większą elastyczność w przypadku regularnych zadań związanych z danymi.

Plan standardowy: Organizacjom o bardziej wymagających potrzebach w zakresie integracji plan standardowy, którego cena wynosi 99 USD miesięcznie (79 USD miesięcznie przy rozliczeniu rocznym), oferuje większą liczbę rekordów, częstsze planowanie i dodatkowe funkcje, takie jak zaawansowane narzędzia do mapowania i transformacji.

Profesjonalny plan: Plan Professional jest dostosowany dla dużych przedsiębiorstw, które wymagają rozbudowanych możliwości integracji danych, w tym nieograniczonej liczby zaplanowanych integracji i najkrótszej częstotliwości realizacji.

Skyvia akceptuje różne metody płatności, w tym karty debetowe i kredytowe oraz przelewy bankowe, aby dostosować się do preferencji użytkowników.

10. Fabryka danych Azure

Azure Data Factory to oparta na chmurze usługa integracji danych, która umożliwia użytkownikom tworzenie, planowanie i organizowanie przepływów pracy związanych z danymi. Został zaprojektowany, aby ułatwić przenoszenie i transformację danych w różnych magazynach danych, zarówno lokalnie, jak i w chmurze. Koncentrując się na łatwości obsługi, zapewnia wizualny interfejs do tworzenia złożonych procesów ETL, które można skalować, aby sprostać wymaganiom obciążeń dużych zbiorów danych.

Co robi Azure Data Factory?

Azure Data Factory umożliwia firmom integrację różnych źródeł danych, niezależnie od tego, czy znajdują się one w różnych usługach w chmurze, czy w infrastrukturze lokalnej. Działa jak spoiwo łączące dane z wielu źródeł, umożliwiając ich transformację i analizę w scentralizowany i zarządzany sposób. Usługa ta obsługuje różne scenariusze ETL i integracji danych, od prostego przenoszenia danych po złożone potoki przetwarzania danych i umożliwia wydajną obsługę dużych ilości danych.

Kluczowe funkcje Azure Data Factory

Możliwości integracji danych: Azure Data Factory oferuje niezawodne możliwości integracji danych, umożliwiając użytkownikom bezproblemowe łączenie się z szeroką gamą źródeł danych, w tym bazami danych, systemami plików i usługami w chmurze.

Wizualne przepływy danych: Narzędzie zapewnia wizualny interfejs do projektowania przepływów pracy opartych na danych, ułatwiając użytkownikom konfigurowanie potoków danych i zarządzanie nimi bez konieczności obszernego kodowania.

Zarządzane usługi ETL: Zapewnia w pełni zarządzaną usługę ETL, co oznacza, że użytkownicy nie muszą się martwić o zarządzanie infrastrukturą i mogą skupić się na projektowaniu logiki transformacji danych.

Wsparcie dla różnych usług obliczeniowych: Azure Data Factory integruje się z różnymi usługami obliczeniowymi Azure, takimi jak Azure HDInsight i Azure Databricks, umożliwiając wydajne przetwarzanie i analizę danych.

Planowanie i wyzwalacze sterowane zdarzeniami: Użytkownicy mogą planować potoki danych lub ustawiać je tak, aby uruchamiały się w odpowiedzi na określone zdarzenia, co zapewnia elastyczność i gwarantuje terminowe przetwarzanie danych.

Narzędzia monitorowania i zarządzania: Usługa obejmuje narzędzia do monitorowania potoków danych i zarządzania nimi, zapewniające użytkownikom wgląd w przepływy danych i możliwość rozwiązywania problemów w miarę ich pojawiania się.

Plany cenowe Azure Data Factory

Azure Data Factory oferuje kilka planów cenowych dostosowanych do różnych potrzeb użytkowników i ograniczeń budżetowych. Użytkownicy mogą obliczyć swój niestandardowy plan za pomocą Kalkulator cen Azure Data Factory.

Płatności za Azure Data Factory można dokonywać za pomocą kart debetowych i kredytowych, systemu PayPal oraz przelewu bankowego.

11. Zarządzanie danymi SAS

SAS Data Management to kompleksowe rozwiązanie zaprojektowane, aby wspierać organizacje w dążeniu do efektywnego zarządzania i optymalizacji potoków danych. Jest to platforma obsługująca ponad 80,000 XNUMX organizacji, ułatwiająca bezproblemową łączność danych, ulepszone transformacje i niezawodne zarządzanie. Narzędzie zostało zaprojektowane tak, aby zapewnić ujednolicony widok danych w różnych systemach przechowywania, w tym w bazach danych, hurtowniach danych i jeziorach danych. Obsługuje połączenia z wiodącymi platformami chmurowymi, systemami lokalnymi i wielochmurowymi źródłami danych, usprawniając przepływ danych i z łatwością wykonując ELT. SAS Data Management jest doceniana za zdolność do zapewniania zgodności z przepisami, budowania zaufania do danych i zapewniania przejrzystości, pozycjonując się jako lider w zakresie rozwiązań w zakresie jakości danych.

Do czego służy zarządzanie danymi SAS?

SAS Data Management to wszechstronne narzędzie, które umożliwia firmom kompleksowe zarządzanie cyklem życia danych. Zapewnia intuicyjny graficzny interfejs użytkownika typu „wskaż i kliknij”, który upraszcza złożone zadania zarządzania danymi. Użytkownicy mogą wysyłać zapytania i wykorzystywać dane w wielu systemach bez konieczności fizycznego uzgadniania lub przenoszenia danych, co stanowi ekonomiczne rozwiązanie dla użytkowników biznesowych. Narzędzie obsługuje zarządzanie danymi podstawowymi za pomocą takich funkcji, jak semantyczne opisy danych i zaawansowane dopasowywanie rozmyte, aby zapewnić integralność danych. Dodatkowo SAS Data Management oferuje równoważenie obciążenia z wykorzystaniem siatki i wielowątkowe przetwarzanie równoległe w celu szybkiej transformacji i przenoszenia danych, eliminując potrzebę nakładania się, redundantnych narzędzi i zapewniając ujednolicone podejście do zarządzania danymi.

Kluczowe funkcje zarządzania danymi SAS

Bezproblemowa łączność danych: SAS Data Management przoduje w łączeniu różnych źródeł danych, zapewniając użytkownikom możliwość dostępu i integracji danych na różnych platformach bez konieczności ręcznej interwencji.

Ulepszone transformacje: Narzędzie oferuje zaawansowane możliwości transformacji danych, umożliwiając użytkownikom skuteczne manipulowanie i udoskonalanie danych, zapewniając ich gotowość do analizy i raportowania.

Solidne zarządzanie: Dzięki SAS Data Management organizacje mogą egzekwować zasady zarządzania danymi, zapewniając jakość danych i zgodność z normami regulacyjnymi.

Ujednolicony widok danych: Zapewnia kompleksowy wgląd w krajobraz danych organizacji, ułatwiając zarządzanie danymi i ich analizowanie z centralnego punktu.

Projektant wizualny o niskim kodzie: Platforma zawiera niskokodowy, samoobsługowy projektant wizualny, który upraszcza tworzenie potoków danych i zarządzanie nimi, dzięki czemu jest dostępny dla użytkowników o różnej wiedzy technicznej.

Zgodność z przepisami: SAS Data Management zapewnia, że procesy przetwarzania danych spełniają przepisy branżowe, pomagając organizacjom zachować zaufanie i przejrzystość praktyk zarządzania danymi.

Plany cenowe SAS dotyczące zarządzania danymi

SAS Data Management oferuje indywidualne plany cenowe dostosowane do konkretnych potrzeb organizacji. Aby poznać pełny zakres opcji cenowych i funkcji zawartych w każdym planie, zachęcamy zainteresowane strony do zamówienia wersji demonstracyjnej.

12. Przepływ danych Google Cloud

Google Cloud Dataflow to w pełni zarządzana usługa, która upraszcza złożoność przetwarzania danych na dużą skalę. Oferuje ujednolicony model programowania zarówno dla przetwarzania wsadowego, jak i strumieniowego, co oznacza, że może obsłużyć zarówno przetwarzanie przechowywanych danych historycznych, jak i generowanych danych w czasie rzeczywistym. Będąc częścią ekosystemu Google Cloud, Dataflow płynnie integruje się z innymi usługami, takimi jak BigQuery, Pub/Sub i Cloud Storage, zapewniając kompleksowe rozwiązanie do zadań ETL, analiz w czasie rzeczywistym i wyzwań obliczeniowych. Podejście bezserwerowe oznacza, że użytkownicy nie muszą zarządzać podstawową infrastrukturą, co pozwala im skupić się na analizach i spostrzeżeniach, a nie na aspektach operacyjnych potoków danych.

Do czego służy Google Cloud Dataflow?

Google Cloud Dataflow zaprojektowano z myślą o zapewnieniu skalowalnego i bezserwerowego środowiska do zadań przetwarzania danych. Umożliwia użytkownikom tworzenie złożonych potoków przetwarzania ETL, wsadowego i strumieniowego, które mogą pobierać dane z różnych źródeł, przekształcać je zgodnie z logiką biznesową, a następnie ładować je do silników analitycznych lub baz danych w celu dalszej analizy. Zdolność Dataflow do obsługi danych wsadowych i danych w czasie rzeczywistym sprawia, że jest on wszechstronny w szerokim zakresie zastosowań, od wykrywania oszustw w czasie rzeczywistym po codzienną analizę dzienników. Usługa eliminuje dostarczanie zasobów, automatycznie skaluje się w celu spełnienia wymagań zadania i zapewnia zestaw narzędzi do monitorowania i optymalizacji potoków, zapewniając wydajne i niezawodne przetwarzanie danych.

Kluczowe funkcje Google Cloud Dataflow

Ujednolicone przetwarzanie strumieniowe i wsadowe: Dataflow oferuje pojedynczy model przetwarzania zarówno danych strumieniowych, jak i wsadowych, co upraszcza tworzenie potoków i pozwala na uzyskanie spójnego, łatwiejszego w zarządzaniu kodu.

Działanie bezserwerowe: Użytkownicy mogą skupić się na kodowaniu, a nie na infrastrukturze, ponieważ Dataflow automatycznie udostępnia niezbędne zasoby i zarządza nimi.

Automatyczne skalowanie: Usługa skaluje zasoby w górę lub w dół w zależności od obciążenia, zapewniając wydajne przetwarzanie bez nadmiernej alokacji.

Integracja z usługami Google Cloud: Dataflow integruje się z BigQuery, Pub/Sub i innymi usługami Google Cloud, zapewniając płynne rozwiązania do analizy danych.

Wbudowana odporność na błędy: Dataflow zapewnia spójne i prawidłowe wyniki, niezależnie od rozmiaru danych i złożoności obliczeń, zapewniając wbudowaną odporność na błędy.

Narzędzia Deweloperskie: Oferuje narzędzia do budowania, debugowania i monitorowania potoków danych, co pomaga w utrzymaniu wysokiej wydajności i niezawodności.

Plany cenowe Google Cloud Dataflow

Google Cloud Dataflow oferuje różnorodne plany cenowe dostosowane do różnych wzorców użytkowania i budżetów. Ceny opierają się na zasobach zużywanych przez zadania, takich jak procesor, pamięć i pamięć masowa, i są rozliczane sekundowo, co zapewnia szczegółową kontrolę nad kosztami. Użytkownicy muszą skontaktować się z zespołem sprzedaży, aby uzyskać informacje o planach cenowych:

Tasowanie przepływu danych: cena tej funkcji opiera się na ilości danych przetwarzanych podczas operacji odczytu i zapisu, co jest niezbędne w przypadku operacji obejmujących tasowanie dużych zbiorów danych.

Poufne ceny maszyn wirtualnych: Dataflow oferuje poufne maszyny wirtualne po globalnej cenie, co gwarantuje przewidywalność kosztów i brak różnic w zależności od regionu.

Zasoby uzupełniające: chociaż zadania Dataflow mogą zużywać zasoby takie jak Cloud Storage, Pub/Sub i BigQuery, są one rozliczane osobno, zgodnie z ich konkretnymi cenami.

Dataflow Prime: Dla użytkowników wymagających zaawansowanych funkcji i optymalizacji dostępna jest usługa Dataflow Prime, która obejmuje dodatkowe ceny za funkcje takie jak dysk trwały, procesory graficzne i migawki.

Płatności za usługi Google Cloud Dataflow można dokonać za pomocą kart debetowych i kredytowych, systemu PayPal oraz przelewów bankowych, co zapewnia elastyczność metod płatności.

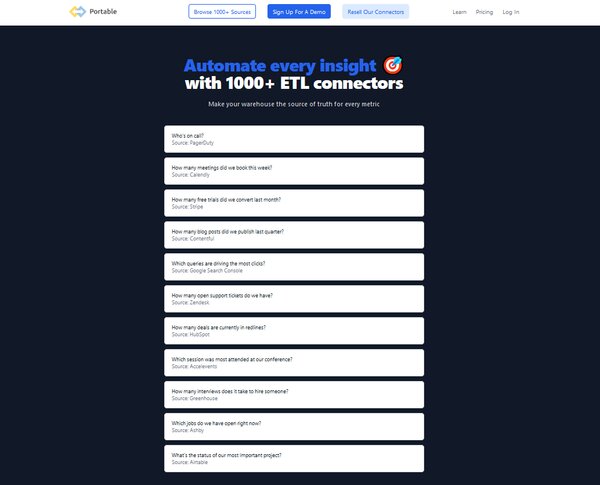

13. Przenośny

Portable to oparte na chmurze narzędzie ETL zaprojektowane z myślą o usprawnieniu procesu integracji danych w firmach. Upraszcza złożone i często techniczne aspekty potoków danych, czyniąc je dostępnymi dla użytkowników bez rozległej wiedzy na temat kodowania. Platforma Portable została zaprojektowana do zarządzania całym procesem ETL, który obejmuje wyodrębnianie danych z różnych źródeł, przekształcanie ich w celu dopasowania do potrzeb operacyjnych i ładowanie ich do systemu docelowego w celu analizy i analizy biznesowej. To narzędzie jest szczególnie korzystne dla organizacji, które chcą zautomatyzować przepływ danych i wykorzystać infrastrukturę chmury do obsługi ekstrakcji danych, transformacji danych w trakcie przesyłania i ładowania danych bez konieczności utrzymywania własnej infrastruktury.

Co robi Przenośny?

Portable zapewnia rozwiązanie niewymagające kodu do tworzenia potoków danych, umożliwiające użytkownikom łączenie się z ponad 500 źródłami danych. Został zaprojektowany do obsługi zawiłości logiki przesyłania danych, takich jak wykonywanie wywołań API, przetwarzanie odpowiedzi, obsługa błędów i limity szybkości. Portable zajmuje się także transformacją danych w trakcie lotu, definiując typy danych, tworząc schematy i zapewniając istnienie kluczy łączenia, a także organizując nieustrukturyzowane dane na potrzeby dalszych potrzeb. Platforma jest odpowiednia dla firm każdej wielkości, które potrzebują niezawodnego i skalowalnego rozwiązania do integracji swoich danych z różnymi systemami i platformami, czy to do celów analitycznych, raportowych czy operacyjnych.

Przenośne najważniejsze funkcje

Ponad 500 łączników danych: Portable oferuje szeroką gamę złączy ETL, umożliwiając firmom bezproblemową integrację danych z wielu różnych źródeł.

Rozwiązanie oparte na chmurze: Jako narzędzie ETL oparte na chmurze, Portable jest hostowany na serwerach dostawcy, co oznacza, że użytkownicy mogą uzyskać dostęp do usługi z dowolnego miejsca i nie muszą się martwić o konserwację infrastruktury.

Interfejs bez kodu: Platforma zapewnia przyjazny dla użytkownika interfejs niewymagający kodu, który ułatwia użytkownikom nietechnicznym konfigurowanie potoków danych i zarządzanie nimi.

Tworzenie niestandardowych łączników: W przypadku unikalnych źródeł danych, Portable umożliwia tworzenie niestandardowych złączy, zapewniając elastyczność i kontrolę nad integracją danych.

Model ustalania opłat ryczałtowych: Portable wykorzystuje atrakcyjny model opłat ryczałtowych, ułatwiając firmom przewidywanie wydatków bez martwienia się o ograniczenia ilości danych.

Transformacja danych w czasie rzeczywistym: Możliwość przeprowadzania transformacji danych w czasie rzeczywistym to kolejna kluczowa cecha, która zapewnia, że dane są zawsze aktualne i dokładne w procesach decyzyjnych.

Przenośne plany cenowe

Portable oferuje trzy główne plany cenowe, aby dostosować się do różnych potrzeb biznesowych:

Plan kroczący: Ten plan, wyceniony na 200 USD miesięcznie, jest przeznaczony dla osób dopiero rozpoczynających integrację danych i oferuje 1 zaplanowany przepływ danych oraz funkcje takie jak nieograniczona ilość danych, pola świeżości i planowanie przepływu co 24 godziny.

Plan skali: Plan skalowania, przeznaczony dla rozwijających się firm, wyceniony na 1,000 USD miesięcznie, obejmuje do 10 zaplanowanych przepływów danych, częstsze planowanie przepływów co 15 minut oraz przyszłe funkcje, takie jak konta wielu użytkowników i powiadomienia webhook.

Plan wzrostu: Dla przedsiębiorstw o dużych potrzebach w zakresie integracji danych Plan rozwoju zapewnia ponad 10 zaplanowanych przepływów danych, planowanie przepływów w czasie zbliżonym do rzeczywistego oraz dodatkowe przyszłe funkcje, takie jak dostęp do interfejsu API administratora.

Portable akceptuje różne metody płatności, w tym karty debetowe i kredytowe, PayPal i przelewy bankowe, zapewniając użytkownikom elastyczność w zarządzaniu swoimi subskrypcjami.

Często zadawane pytania dotyczące narzędzi ETL

Co to jest narzędzie ETL?

Narzędzie ETL to aplikacja służąca do wyodrębniania, przekształcania i ładowania danych z różnych źródeł do hurtowni danych lub innego systemu docelowego. Narzędzia te automatyzują proces integracji danych, zapewniając jakość i spójność danych oraz redukując czas i wysiłek wymagany do przygotowania danych do analizy.

Dlaczego narzędzia ETL są ważne?

Narzędzia ETL odgrywają kluczową rolę w dzisiejszym świecie opartym na danych, ponieważ automatyzują proces wydobywania danych z różnych źródeł, przekształcania ich do ustandaryzowanego formatu i ładowania do hurtowni danych. Automatyzacja ta nie tylko oszczędza czas i zasoby, ale także poprawia jakość i spójność danych, umożliwiając firmom skuteczniejsze podejmowanie decyzji opartych na danych.

Jak działają narzędzia ETL?

Narzędzia ETL działają na zasadzie wydobywania danych z różnych źródeł, przekształcania ich tak, aby spełniały niezbędne standardy jakości, a następnie ładowania ich do hurtowni danych lub innego systemu docelowego. Automatyzują cały proces, redukując błędy i przyspieszając integrację danych.

Jakie są kluczowe cechy narzędzi ETL?

Kluczowe cechy narzędzi ETL obejmują obsługę wielu źródeł danych, intuicyjny interfejs użytkownika ułatwiający manipulację danymi oraz skalowalność do obsługi dużych ilości danych. Powinny także zapewniać jakość danych i możliwości profilowania, obsługę danych zarówno w chmurze, jak i lokalnie, a także być opłacalne.

Jakie wyzwania wiążą się z korzystaniem z narzędzi ETL?

Chociaż narzędzia ETL oferują wiele korzyści, stwarzają również pewne wyzwania. Obejmują one potrzebę posiadania specjalistycznej wiedzy technicznej w celu skonfigurowania narzędzi i zarządzania nimi, obsługi różnorodnych źródeł danych i zapewnienia bezpieczeństwa danych podczas procesu ETL.

Jakie rodzaje narzędzi ETL są dostępne?

Dostępnych jest kilka typów narzędzi ETL, w tym narzędzia typu open source, usługi w chmurze i oprogramowanie dla przedsiębiorstw. Wybór narzędzia zależy od konkretnych potrzeb i zasobów organizacji.

Jak wybrać odpowiednie narzędzie ETL?

Wybór odpowiedniego narzędzia ETL zależy od kilku czynników, w tym od złożoności wymagań dotyczących danych, ilości danych, które należy przetworzyć, rodzaju źródeł danych, z którymi pracujesz, oraz budżetu. Ważne jest również, aby wziąć pod uwagę interfejs użytkownika narzędzia, skalowalność i usługi wsparcia.

Czy użytkownicy nietechniczni mogą korzystać z narzędzi ETL?

Tak, wiele narzędzi ETL ma graficzne interfejsy użytkownika, dzięki czemu są dostępne dla użytkowników nietechnicznych. Jednak podstawowa znajomość procesów ETL i zasad zarządzania danymi jest korzystna.

Jaka jest przyszłość narzędzi ETL?

Przyszłość narzędzi ETL leży w ich zdolności do obsługi coraz bardziej złożonych krajobrazów danych, w tym strumieni danych w czasie rzeczywistym i różnorodnych źródeł danych. Oczekuje się również, że postępy w sztucznej inteligencji i uczeniu maszynowym zwiększą możliwości narzędzi ETL, czyniąc je jeszcze bardziej wydajnymi i skutecznymi.

Czy narzędzia ETL są używane wyłącznie do hurtowni danych?

Chociaż narzędzia ETL są powszechnie stosowane w hurtowni danych, nie ograniczają się one do tego zastosowania. Można ich również używać do migracji danych, integracji danych i zadań transformacji danych w różnych innych kontekstach.

Wnioski

Narzędzia ETL odgrywają kluczową rolę w dzisiejszym środowisku biznesowym opartym na danych. Usprawniają proces wydobywania, przekształcania i ładowania danych, przygotowując je do analizy i podejmowania decyzji. Dzięki możliwości obsługi różnorodnych źródeł danych i dużych wolumenów danych, narzędzia ETL są niezbędne dla każdej organizacji, która chce efektywnie wykorzystać swoje dane. W miarę ciągłego rozwoju technologii możemy spodziewać się, że narzędzia ETL staną się jeszcze potężniejsze i wszechstronne, co jeszcze bardziej zwiększy ich wartość dla przedsiębiorstw.

W świecie big data narzędzia ETL są niedocenianymi bohaterami. Działają za kulisami, dbając o to, aby dane były czyste, spójne i gotowe do analizy. Automatyzując złożone zadania związane z zarządzaniem danymi, uwalniają czas i zasoby, umożliwiając firmom skupienie się na tym, co naprawdę ważne – wykorzystywaniu danych do podejmowania strategicznych decyzji. W miarę postępu znaczenie narzędzi ETL będzie coraz większe, czyniąc je kluczowym elementem każdej skutecznej strategii dotyczącej danych.