Die 7 besten Open-Source-LLMs

Open-Source-LLMs (Large Language Models) sind nicht nur ein flüchtiger Trend, sondern eine transformative Kraft in der Technologiebranche. Diese leistungsstarken Tools verändern die Art und Weise, wie wir mit Maschinen interagieren, und bieten beispiellose Möglichkeiten bei der Verarbeitung und Generierung natürlicher Sprache. Mit dem Aufkommen von Open-Source-LLMs wird die Landschaft noch spannender, da sie eine Plattform für Innovation, Zusammenarbeit und Zugänglichkeit bieten, die bisher undenkbar war.

Die Bedeutung von Open-Source-LLMs kann nicht genug betont werden. Sie fungieren als Leuchtfeuer der Transparenz, ermöglichen ein tieferes Verständnis ihrer inneren Abläufe und ermöglichen es Benutzern, diese Modelle an ihre spezifischen Bedürfnisse anzupassen. Diese Demokratisierung der Technologie ist nicht nur für Entwickler und Forscher von Vorteil, sie ist auch ein Segen für Unternehmen und Enthusiasten, die die Leistungsfähigkeit der KI ohne die Einschränkungen proprietärer Systeme nutzen möchten.

Der Bedarf an Open-Source-LLMs

Open-Source-LLMs sind bahnbrechend, da sie ein Maß an Anpassung und Flexibilität bieten, mit dem proprietäre Modelle einfach nicht mithalten können. Für Unternehmen bedeutet dies die Möglichkeit, Modelle genau auf ihre individuellen Anforderungen abzustimmen und sicherzustellen, dass die KI perfekt auf ihre betrieblichen Anforderungen abgestimmt ist. Der Open-Source-Ansatz umgeht auch die potenziellen Fallstricke einer Anbieterbindung und gibt Benutzern die Freiheit, Innovationen voranzutreiben, ohne an das Ökosystem eines einzelnen Anbieters gebunden zu sein.

Darüber hinaus sind Open-Source-LLMs ein Beweis für den kollaborativen Geist der Tech-Community. Sie leben von den Beiträgen unzähliger Einzelpersonen, die ein gemeinsames Ziel verfolgen: den Bereich der KI voranzutreiben. Diese gemeinsame Anstrengung beschleunigt nicht nur das Innovationstempo, sondern stellt dank der vielfältigen Perspektiven, die in ihre Entwicklung einfließen, auch sicher, dass die Modelle robust, sicher und weniger anfällig für Vorurteile sind.

Zusammenfassend lässt sich sagen, dass der Aufstieg von Open-Source-LLMs ein klarer Indikator für das Engagement der Branche für Offenheit, Zusammenarbeit und Inklusivität ist. Da sich diese Modelle ständig weiterentwickeln und verbessern, versprechen sie, neue Möglichkeiten zu eröffnen und den Fortschritt in verschiedenen Sektoren voranzutreiben. Egal, ob Sie ein erfahrener KI-Praktiker sind oder gerade erst damit beginnen, das Potenzial dieser Modelle zu erkunden, die Zukunft von Open-Source-LLMs ist rosig und voller Möglichkeiten.

Die 7 besten Open-Source-LLMs

Wie funktionieren Open-Source-LLMs?

Open-Source-LLMs stehen an der Spitze der KI-Revolution und bieten ein vielseitiges und leistungsstarkes Werkzeug für eine Vielzahl von Anwendungen. Diese Modelle werden auf riesigen Datensätzen trainiert, die Texte aus dem Internet, Büchern, Artikeln und mehr umfassen, sodass sie menschenähnliche Texte verstehen und generieren können. Der Open-Source-Charakter dieser LLMs bedeutet, dass ihr Code und manchmal auch andere Komponenten für jedermann frei verfügbar sind, um sie zu verwenden, zu ändern und zu verteilen. Diese Zugänglichkeit fördert Innovation und Zusammenarbeit innerhalb der Tech-Community und ermöglicht es Entwicklern, Modelle für bestimmte Aufgaben zu optimieren oder sie in größere Systeme zu integrieren. Open-Source-LLMs funktionieren, indem sie Eingabetext über Schichten neuronaler Netze verarbeiten und das nächste Wort in einer Sequenz basierend auf dem durch die vorherigen Wörter bereitgestellten Kontext vorhersagen. Diese Fähigkeit ermöglicht es ihnen, Aufgaben wie Texterstellung, Übersetzung, Zusammenfassung und mehr mit bemerkenswerter Genauigkeit auszuführen.

Wie wählt man Open-Source-LLMs aus?

Bei der Auswahl der richtigen Open-Source-LLMs für Ihr Projekt müssen mehrere Schlüsselfaktoren berücksichtigt werden, um sicherzustellen, dass das Modell Ihren spezifischen Anforderungen entspricht. Bewerten Sie zunächst die Genauigkeit des Modells für Aufgaben, die für Ihre Anwendung relevant sind, da Modelle mit höherer Genauigkeit eine bessere Leistung liefern. Berücksichtigen Sie die technischen Anforderungen und stellen Sie sicher, dass sie mit den Fähigkeiten Ihrer Infrastruktur, einschließlich Hardware und Rechenressourcen, übereinstimmen. Es ist außerdem wichtig, die Lizenzbedingungen des Modells zu lesen, um Nutzungsrechte, Änderungen und Vertriebsanforderungen zu verstehen. Skalierbarkeit ist ein weiterer wichtiger Faktor. Das Modell sollte in der Lage sein, steigende Anforderungen und Datengrößen effizient zu bewältigen. Integrationsfähigkeiten sind ebenfalls wichtig. Das Modell sollte mit den Programmiersprachen, Frameworks und APIs kompatibel sein, die Sie verwenden möchten. Überlegen Sie abschließend, ob das Modell Transferlernen unterstützt. Dadurch können Sie ein vorab trainiertes Modell genau auf Ihre spezifische Aufgabe abstimmen und so Zeit und Ressourcen im Vergleich zum Training eines Modells von Grund auf sparen. Durch sorgfältige Bewertung dieser Faktoren können Sie Open-Source-LLMs auswählen, die den Anforderungen Ihres Projekts am besten entsprechen und das Potenzial der KI in Ihrer Anwendung maximieren.

Open-Source-LLMs

1. Mistral

Mistral ist eine Open-Source-LLM- und KI-Plattform, die sich mit einigen der anspruchsvollsten Aspekte von KI-Modellen befasst und sich dabei auf Recheneffizienz, Nützlichkeit und Vertrauenswürdigkeit konzentriert. Diese Open-Source-LLM-Plattform steht an der Spitze offener Modellinitiativen und bietet Benutzern transparenten Zugriff auf Modellgewichte, was eine umfassende Anpassung ermöglicht. Mistral bekennt sich zu den Grundsätzen offener Wissenschaft, Community-Engagement und freier Software und veröffentlicht viele seiner Modelle und Bereitstellungstools unter freizügigen Lizenzen, um eine wechselseitige Beziehung mit der Open-Source-Software-Community (OSS) zu fördern.

Was macht Mistral?

Mistral bietet eine frühe generative KI-Plattform, die sich derzeit im Early Access befindet. Diese Open-Source-LLM-Plattform stellt optimierte Modelle für die Generierung und Einbettung bereit, die zur Nutzung offen sind. Mistral zeichnet sich durch seine Geschwindigkeit und Leistung aus: Er ist sechsmal schneller und erreicht oder übertrifft seine Gegenstücke wie Llama 2 70B in allen Benchmarks. Die Plattform unterstützt mehrere Sprachen, verfügt über natürliche Programmierfähigkeiten und kann Sequenzen mit einer Länge von bis zu 32,000 verarbeiten. Benutzer haben dank der Apache 2.0-Lizenzierung die Flexibilität, über eine API auf Mistral zuzugreifen oder es unabhängig bereitzustellen.

Hauptmerkmale des Mistral

Recheneffizienz: Mistral ist hinsichtlich der Berechnung äußerst effizient konzipiert und bietet ein schnelles und leistungsstarkes Modell, das keine Kompromisse bei der Leistung eingeht.

Hilfsbereit und vertrauenswürdig: Die Plattform zielt darauf ab, KI-Modelle zu erstellen, die nicht nur bei ihrer Anwendung hilfreich, sondern auch vertrauenswürdig sind und sicherstellen, dass sich Benutzer auf die generierten Ergebnisse verlassen können.

Öffnen Sie die Modellfamilie: Als führender Anbieter offener Modelle fördert Mistral Transparenz und Individualisierung, sodass Benutzer die Modelle an ihre spezifischen Bedürfnisse anpassen können.

Community und Freie Software: Mit einem starken Glauben an offene Wissenschaft und Gemeinschaft veröffentlicht Mistral seine Modelle und Tools unter freizügigen Lizenzen und fördert so eine Kultur des Teilens und der Zusammenarbeit.

Early-Access-Plattform für generative KI: Benutzer können in einem frühen Stadium auf die generative KI-Plattform von Mistral zugreifen und deren optimierte Modelle für die Generierung und Einbettung nutzen.

Mehrsprachige Unterstützung und Programmierfähigkeiten: Die Plattform ist in der Lage, Texte in mehreren Sprachen zu verstehen und zu generieren und verfügt über integrierte Codierungsfunktionen, wodurch sie für verschiedene Anwendungsfälle vielseitig einsetzbar ist.

Handhabung langer Sequenzen: Mistral kann lange Sequenzen von bis zu 32,000 verarbeiten, was bei komplexen Aufgaben, die einen umfangreichen Kontext erfordern, von Vorteil ist.

Flexible Bereitstellung: Das Modell ist über eine API oder für die unabhängige Bereitstellung verfügbar, mit einer Apache 2.0-Lizenz, die die Benutzerfreundlichkeit und Integration erleichtert.

2. Lama 2

Llama 2 ist ein von Meta entwickeltes Open-Source-LLM (Large Language Model), das den Zugang zu erweiterten KI-Funktionen demokratisieren soll. Es ist sowohl für die Forschung als auch für die kommerzielle Nutzung lizenziert und bietet Entwicklern eine einzigartige Gelegenheit, sich mit modernster KI-Technologie auseinanderzusetzen. Llama 2 ist Teil einer umfassenderen Initiative zur Förderung der offenen Zusammenarbeit und Innovation innerhalb der KI-Community. Durch die Bereitstellung des Zugriffs auf dieses leistungsstarke Tool möchte Meta Menschen in die Lage versetzen, die nächste Innovationswelle in verschiedenen Bereichen zu gestalten.

Was macht Lama 2?

Llama 2 funktioniert, indem es plausible Folgetexte basierend auf den empfangenen Eingaben vorhersagt und dabei ein neuronales Netzwerk mit einer Transformatorarchitektur verwendet. Dies ermöglicht es, Antworten zu generieren, die in ihrer Konstruktion und Relevanz bemerkenswert menschenähnlich sind. Das Modell ist in der Lage, sowohl natürliche Sprache als auch Code zu verstehen und zu generieren, was es zu einem vielseitigen Werkzeug für eine Vielzahl von Anwendungen macht. Von der Unterstützung von Entwicklern bei Codierungsaufgaben bis hin zur Erleichterung der Forschung in der Verarbeitung natürlicher Sprache dient Llama 2 als vielseitige Plattform, die für bestimmte Anwendungsfälle fein abgestimmt und angepasst werden kann.

Hauptmerkmale von Lama 2

Vorab trainierte und fein abgestimmte Modelle: Llama 2 enthält eine Sammlung von Modellen, die anhand umfangreicher Datensätze vorab trainiert und für bestimmte Aufgaben wie Dialoge optimiert wurden. Dieser Feinabstimmungsprozess wurde sorgfältig durchgeführt, wobei der Schwerpunkt auf Sicherheit und Hilfsbereitschaft lag, um sicherzustellen, dass die Modelle nicht nur effektiv, sondern auch verantwortungsbewusst in ihren Interaktionen sind.

Open-Source-Zugänglichkeit: Einer der wichtigsten Aspekte von Llama 2 ist sein Open-Source-Charakter. Im Gegensatz zu vielen proprietären Modellen stehen der Code und die Trainingsdetails von Llama 2 zur Prüfung zur Verfügung, sodass Entwickler und Forscher das Innenleben verstehen und zu seiner Entwicklung beitragen können.

Anpassung und Flexibilität: Mit Llama 2 haben Benutzer die Freiheit, das Modell anhand ihrer eigenen Daten zu trainieren, es für bestimmte Aufgaben zu optimieren und sogar in den zugrunde liegenden Code einzutauchen. Dieses Maß an Anpassung und Flexibilität ist von unschätzbarem Wert für die Erstellung von KI-Anwendungen, die auf spezifische Bedürfnisse und Ziele zugeschnitten sind.

Gemeinschaft und Zusammenarbeit: Durch die Bereitstellung von Llama 2 als Open Source hat Meta eine Plattform für die globale Zusammenarbeit geschaffen. Entwickler und Forscher aus der ganzen Welt können zur Verbesserung des Modells beitragen, Erkenntnisse austauschen und gemeinsam die Grenzen dessen erweitern, was KI leisten kann.

Ausrichtung auf Sicherheit und Innovation: Meta hat Schritte unternommen, um sicherzustellen, dass Llama 2 den Grundsätzen der Sicherheit und Innovation entspricht. Das Modell wurde Red-Teaming-Übungen und externen gegnerischen Tests unterzogen, um potenzielle Schwachstellen zu identifizieren und zu beheben, was das Engagement für eine verantwortungsvolle KI-Entwicklung widerspiegelt.

3. Vicuna-13B

Vicuna-13B ist ein innovatives Open-Source-Chatbot-Modell, das anhand von rund 70,000 von Benutzern geteilten Gesprächen auf einem LLaMA-Basismodell verfeinert wurde. Dieser Prozess stellt einen qualitativ hochwertigen Datensatz sicher, indem er HTML in Markdown konvertiert und ungeeignete oder minderwertige Beispiele herausfiltert. Vicuna-13B zeichnet sich durch seine Fähigkeit aus, systematische und qualitativ hochwertige Antworten zu generieren, und zeigt eine beeindruckende Leistung, die in bestimmten Aspekten sogar mit GPT-4 mithalten kann. Die Entwicklung des Modells legt den Schwerpunkt auf Verbesserungen bei der Speicheroptimierung und der Handhabung von mehrrundigen Gesprächen und stellt damit einen wesentlichen Beitrag zum Bereich der Verarbeitung natürlicher Sprache und KI-Chatbots dar.

Was macht Vicuna-13B?

Vicuna-13B zeichnet sich dadurch aus, dass es kohärente und kontextrelevante Textantworten generiert, was es zu einem hervorragenden Werkzeug für verschiedene Anwendungen macht, darunter Kundenservice, Bildungstools und mehr. Durch die Nutzung eines umfangreichen Datensatzes von von Benutzern geteilten Gesprächen und den Einsatz fortschrittlicher Feinabstimmungstechniken kann Vicuna-13B komplexe Dialoge verstehen und daran teilnehmen und Antworten bieten, die menschlichen Gesprächsmustern sehr nahe kommen. Diese Fähigkeit wird durch die Fähigkeit, längere Gesprächsdauern zu bewältigen, noch weiter verbessert, was eine tiefergehende Interaktion ermöglicht. Der Open-Source-Charakter des Modells fördert auch laufende Verbesserungen und Anpassungen durch die globale Tech-Community.

Hauptmerkmale von Vicuna-13B

Fein abgestimmtes LLaMA-Basismodell: Vicuna-13B verfügt über eine solide Grundlage, die es ihm ermöglicht, qualitativ hochwertige, kontextbezogene Antworten zu einem breiten Spektrum von Themen und Szenarien zu liefern.

Verbesserte Genauigkeit: Das Modell zeichnet sich durch seine außergewöhnliche Fähigkeit aus, dank seines umfassenden Trainings auf einem vielfältigen Datensatz nicht nur relevante, sondern auch präzise Antworten zu generieren.

Open-Source-Verfügbarkeit: Vicuna-13B ist zur Nutzung, Änderung und Verbreitung frei zugänglich und fördert Innovation und Zusammenarbeit innerhalb der KI- und Technologie-Community.

Vielseitige Anwendung: Von der Verbesserung des Kundendiensterlebnisses bis hin zur Funktion als dynamisches Werkzeug für das Erlernen und Recherchieren von Sprachen – die Fähigkeiten von Vicuna-13B machen es zu einem wertvollen Aktivposten in verschiedenen Bereichen.

Kostengünstige Schulung: Der Entwicklungsprozess des Modells wurde optimiert, um die Schulungskosten erheblich zu senken und die fortschrittliche KI-Chatbot-Technologie zugänglicher zu machen.

Sicherheit und Voreingenommenheitsminderung: Es wurden Anstrengungen unternommen, um Sicherheitsbedenken auszuräumen und potenzielle Verzerrungen in den Modellergebnissen zu reduzieren, obwohl in diesem Bereich noch weitere Arbeiten erforderlich sind.

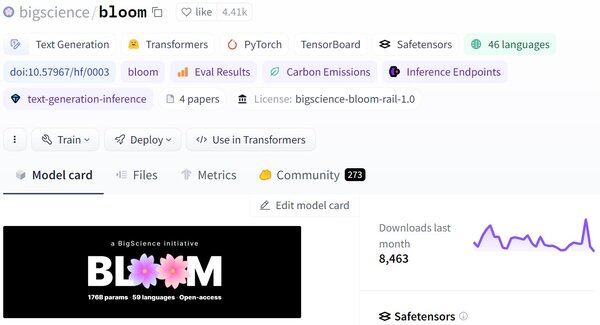

4. Blühen

Bloom ist ein Open-Source-MML, das von der BigScience-Forschungswerkstatt entwickelt wurde. Mit 176 Milliarden Parametern kann Bloom Texte in 46 natürlichen Sprachen und 13 Programmiersprachen generieren und ist damit eines der umfangreichsten mehrsprachigen Modelle, die der Öffentlichkeit zugänglich sind. Es wurde transparent auf dem Jean-Zay-Supercomputer trainiert und ist als Gemeinschaftsprojekt konzipiert, an dem über 1000 Forscher aus mehr als 70 Ländern beteiligt sind. Bloom ist Teil einer Initiative, die Hochschulen, gemeinnützigen Organisationen und kleineren Forschungslaboren Zugang zu hochwertigen Open-Source-LLMs verschaffen soll, die traditionell die Domäne gut ausgestatteter Industrielabore waren.

Was macht Bloom?

Bloom führt eine Vielzahl von Sprachaufgaben durch, indem er aus Eingabeaufforderungen kohärenten Text generiert. Es handelt sich um ein autoregressives Modell, das Texte erzeugen kann, die kaum von von Menschen geschriebenen Texten zu unterscheiden sind. Über die Textgenerierung hinaus kann Bloom Aufgaben ausführen, für die es nicht explizit trainiert wurde, indem es sie als Herausforderungen bei der Textgenerierung definiert. Dazu gehört die Fähigkeit, Inhalte in mehreren Sprachen und Programmiercodes zu verstehen und zu generieren, was es zu einem vielseitigen Werkzeug für Forscher und Entwickler macht, die die Möglichkeiten von Open-Source-LLMs erkunden möchten.

Hauptmerkmale von Bloom

Mehrsprachigkeit: Bloom zeichnet sich durch seine Fähigkeit aus, Texte in einer Vielzahl von Sprachen zu verstehen und zu generieren, auch in solchen, die im KI-Bereich unterrepräsentiert sind. Diese Funktion ist besonders für globale Anwendungen und Forschung von Vorteil.

Umfangreiche Zusammenarbeit: Die Entwicklung von Bloom ist das Ergebnis einer beispiellosen Zusammenarbeit, die eine vielfältige Gruppe von Forschern und Freiwilligen zusammenbringt. Dieser kollektive Ansatz zur KI-Entwicklung fördert ein integrativeres und umfassenderes Modell.

Transparenter Schulungsprozess: Im Gegensatz zu proprietären Modellen ist der Trainingsprozess von Bloom völlig transparent, bietet Einblicke in seine Entwicklung und ermöglicht ein umfassenderes Verständnis seiner Funktionen und potenziellen Verbesserungen.

Verantwortliche KI-Lizenz: Bloom unterliegt der Responsible AI License, die darauf abzielt, eine ethische Nutzung der Technologie sicherzustellen und Missbrauch zu verhindern. Dies spiegelt das Engagement für eine verantwortungsvolle KI-Entwicklung und -Einführung wider.

FORTLAUFENDE VERBESSERUNGEN: Der BigScience-Workshop beabsichtigt, Bloom kontinuierlich zu aktualisieren und zu verbessern, neue Sprachen und Funktionen hinzuzufügen und seine Fähigkeiten zu verfeinern. Diese kontinuierliche Weiterentwicklung stellt sicher, dass Bloom ein Spitzeninstrument im Bereich KI bleibt.

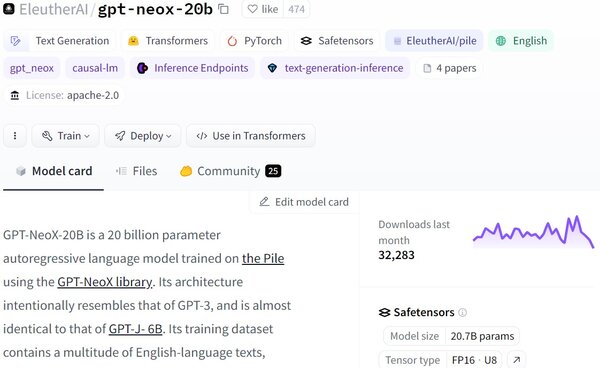

5. GPT-NeoX-20B

GPT-NeoX-20B ist ein Produkt von EleutherAI, einem Kollektiv, das sich auf die Demokratisierung und Weiterentwicklung der KI-Forschung konzentriert. Dieses Modell ist Teil der GPT-NeoX-Serie und soll eine Open-Source-LLM-Alternative zu proprietären Modellen wie GPT-3 bieten. Mit 20 Milliarden Parametern ist GPT-NeoX-20B darauf ausgelegt, englischsprachigen Text zu verstehen und zu generieren, was es zu einem leistungsstarken Werkzeug für eine Vielzahl von Aufgaben der Verarbeitung natürlicher Sprache macht. Seine Entwicklung und Veröffentlichung unter einer Open-Source-Lizenz zielt darauf ab, Innovation und Forschung in der KI-Community zu fördern und eine robuste Plattform für Experimente und Anwendungsentwicklung bereitzustellen.

Was macht GPT-NeoX-20B?

GPT-NeoX-20B ist darauf spezialisiert, menschenähnlichen Text zu generieren, indem das nächste Token in einer Sequenz basierend auf dem durch den Eingabetext bereitgestellten Kontext vorhergesagt wird. Diese Fähigkeit ermöglicht die Ausführung einer Vielzahl von Aufgaben, darunter unter anderem die Erstellung von Inhalten, Zusammenfassungen und die Beantwortung von Fragen. Es ist jedoch wichtig zu beachten, dass GPT-NeoX-20B sich zwar durch die Generierung kohärenter und kontextrelevanter Texte auszeichnet, jedoch ausschließlich für die Verarbeitung englischer Sprache konzipiert ist und keine Übersetzung oder Textgenerierung in anderen Sprachen unterstützt. Benutzer sollten auch auf seine Einschränkungen und Verzerrungen achten, da die Ergebnisse des Modells möglicherweise nicht immer sachlich korrekt oder frei von unbeabsichtigten Verzerrungen sind.

GPT-NeoX-20B Hauptmerkmale

Englischsprachige Spezialisierung: GPT-NeoX-20B ist auf die Verarbeitung und Generierung englischsprachiger Texte zugeschnitten und somit ein Spezialwerkzeug für Aufgaben, die ein tiefes Verständnis der englischen Syntax und Semantik erfordern.

20 Milliarden Parameter: Die große Anzahl an Parametern des Modells ermöglicht es, ein breites Spektrum sprachlicher Nuancen zu erfassen und so hochentwickelte und vielfältige Textausgaben zu generieren.

Open-Source-Verfügbarkeit: Durch die Verfügbarkeit unter einer Open-Source-Lizenz fördert GPT-NeoX-20B die Zusammenarbeit und Innovation innerhalb der KI-Forschungsgemeinschaft und ermöglicht es Entwicklern und Forschern, das Modell zu modifizieren und darauf aufzubauen.

Inhaltserstellung und Zusammenfassung: Seine Fähigkeit, das nächste Token in einer Sequenz vorherzusagen, macht es äußerst effektiv für die Erstellung ansprechender Inhalte und die Zusammenfassung bestehender Texte und bietet wertvolle Anwendungen in Bereichen wie Journalismus, Marketing und Bildung.

Bewusstsein für Einschränkungen und Vorurteile: Die Entwickler von GPT-NeoX-20B erkennen offen die Einschränkungen und potenziellen Vorurteile des Modells an und fördern einen verantwortungsvollen Ansatz bei seiner Bereitstellung und Verwendung in Anwendungen.

GPT-NeoX-20B stellt einen bedeutenden Beitrag zur Open-Source-MML-Landschaft dar und bietet ein leistungsstarkes Tool für die Generierung und Analyse englischer Texte und unterstreicht gleichzeitig die Bedeutung ethischer Überlegungen bei der KI-Entwicklung.

6. MPT-7B

MPT-7B ist das Ergebnis der umfangreichen zweijährigen Bemühungen von MosaicML, einen neuen Maßstab für kommerziell nutzbare Open-Source-LLMs zu schaffen. Dieses Modell ist Teil einer umfassenderen Initiative, die Open-Source-Software wie Composer, StreamingDataset und LLM Foundry sowie proprietäre Infrastrukturen wie MosaicML Training und Inference umfasst. MPT-7B soll die Ausbildung von LLMs demokratisieren und beispiellose Effizienz, Privatsphäre und Kostentransparenz bieten. Es ermöglicht Kunden, Open-Source-LLMs über jeden Rechenanbieter und jede Datenquelle hinweg zu trainieren und so von Anfang an optimale Ergebnisse zu gewährleisten. MPT-7B ist ein idealer Ausgangspunkt für diejenigen, die benutzerdefinierte LLMs für private, kommerzielle oder gemeinschaftliche Zwecke erstellen möchten, unabhängig davon, ob das Ziel darin besteht, bestehende Kontrollpunkte zu optimieren oder völlig neue Modelle von Grund auf zu trainieren.

Was macht MPT-7B?

MPT-7B erleichtert die Erstellung und Bereitstellung benutzerdefinierter großer Sprachmodelle mit Schwerpunkt auf Zugänglichkeit, Effizienz und kommerzieller Realisierbarkeit. Es unterstützt das Training von Open-Source-LLMs auf verschiedenen Computerplattformen und Datenquellen und geht dabei auf die kritischen Anforderungen an Datenschutz und Kosteneffizienz ein. Dieses Modell zeichnet sich dadurch aus, dass es eine solide Grundlage sowohl für die Feinabstimmung bereits bestehender Modelle als auch für die Entwicklung neuer Modelle von Grund auf bietet. Die Integration von MPT-7B in die Tool- und Infrastruktur-Suite von MosaicML vereinfacht den ansonsten komplexen Prozess der LLM-Entwicklung und macht ihn für ein breites Spektrum von Benutzern, von einzelnen Entwicklern bis hin zu großen Unternehmen, zugänglicher.

Hauptmerkmale des MPT-7B

Open-Source-Software-Integration: MPT-7B ist eng in Open-Source-Tools wie Composer, StreamingDataset und LLM Foundry integriert, was seine Flexibilität und Benutzerfreundlichkeit erhöht.

Kompatibilität mit proprietären Infrastrukturen: Es arbeitet nahtlos mit der proprietären Trainings- und Inferenzinfrastruktur von MosaicML zusammen und bietet einen ausgewogenen Ansatz zwischen Open-Source-Flexibilität und proprietärer Effizienz.

Benutzerdefiniertes LLM-Gebäude: Die Plattform ist als ideale Lösung für die Erstellung benutzerdefinierter Open-Source-LLMs konzipiert, die auf spezifische private, kommerzielle oder gemeinschaftliche Bedürfnisse zugeschnitten sind.

Effizienz und Datenschutz: MPT-7B priorisiert die Effizienz in Schulungsprozessen und schützt die Privatsphäre und geht damit auf zwei der wichtigsten Probleme bei der LLM-Entwicklung ein.

Kostentransparenz: Es führt ein bisher in der LLM-Schulung nicht dagewesenes Maß an Kostentransparenz ein und ermöglicht Benutzern eine effektivere Budgetverwaltung.

Vielseitigkeit bei allen Computing-Anbietern: Das Design des Modells stellt sicher, dass es bei jedem Computeranbieter trainiert werden kann und bietet beispiellose Vielseitigkeit und Freiheit.

MPT-7B stellt einen bedeutenden Schritt vorwärts in der Demokratisierung der Entwicklung großer Sprachmodelle dar und kombiniert das Beste aus Open-Source-Software und proprietärer Infrastruktur, um den vielfältigen Anforderungen der KI-Community gerecht zu werden.

7. Falke

Falcon ist ein generatives großes Sprachmodell, das entwickelt wurde, um Anwendungen und Anwendungsfälle in verschiedenen Domänen zu verbessern. Mit einer Reihe von Modellen mit Parametern von 1.3 B bis 180 B ist Falcon so konzipiert, dass es vielseitig und an Forschungs- und kommerzielle Anforderungen anpassbar ist. Das Modell wird durch den REFINEDWEB-Datensatz ergänzt, der eine qualitativ hochwertige Trainingsgrundlage gewährleistet. Der Open-Source-LLM-Charakter von Falcon unterstreicht das Engagement für Transparenz und Zusammenarbeit bei der KI-Entwicklung und ermöglicht eine breite Nutzung und Innovation.

Was macht Falcon?

Falcon zeichnet sich dadurch aus, dass es kohärenten und kontextrelevanten Text generiert, was es zu einem leistungsstarken Werkzeug für Aufgaben der Verarbeitung natürlicher Sprache macht. Seine Fähigkeit, menschenähnlichen Text in verschiedenen Kontexten zu verstehen und zu produzieren, ermöglicht den Einsatz für eine Vielzahl von Anwendungen, von Chatbots und virtuellen Assistenten bis hin zu komplexeren Sprachmodellierungsprojekten. Das Design von Falcon ermöglicht dynamische und interaktive Gesprächserlebnisse und ermöglicht es Benutzern, sich auf eine Weise mit dem Modell auseinanderzusetzen, die die menschliche Interaktion nachahmt.

Hauptmerkmale von Falcon

Verschiedene Modellgrößen: Falcon bietet eine Reihe von Modellen mit unterschiedlichen Parameterzahlen, die auf unterschiedliche Rechenanforderungen und Anwendungsfälle zugeschnitten sind. Diese Vielfalt ermöglicht es Benutzern, die am besten geeignete Modellgröße für ihre spezifische Anwendung auszuwählen und dabei Leistung und Ressourcenanforderungen in Einklang zu bringen.

REFINEDWEB-Datensatz: Die Qualität des Falcon-Trainings wird durch den REFINEDWEB-Datensatz gestärkt, der eine reichhaltige und vielfältige Grundlage für die Sprachfähigkeiten des Modells bietet. Dieser Datensatz trägt zur Fähigkeit des Modells bei, qualitativ hochwertigen, differenzierten Text zu generieren.

Open Source und Open Access: Die Open-Source-Verfügbarkeit von Falcon stellt sicher, dass es frei verwendet und geändert werden kann, was Innovationen fördert und es einer breiten Gemeinschaft von Entwicklern und Forschern ermöglicht, zu seiner Weiterentwicklung beizutragen.

Vielseitigkeit in den Anwendungen: Das Design und die Schulung des Modells ermöglichen eine gute Leistung bei einem breiten Spektrum an Aufgaben zur Verarbeitung natürlicher Sprache und machen es zu einem flexiblen Werkzeug sowohl für Forschungs- als auch für kommerzielle Projekte.

Optimierung für Leistung: Falcon wurde im Hinblick auf Effizienz optimiert, wodurch die für Training und Bereitstellung erforderlichen Rechenressourcen reduziert wurden, wodurch es leichter zugänglich ist, insbesondere in Szenarien mit begrenzter Rechenleistung.

FAQs zu Open-Source-LLMs

Was ist ein Open-Source-LLM?

Open-Source-MMLs (Open Source Large Language Models) sind eine Art künstliche Intelligenz-Technologie, die darauf ausgelegt ist, menschenähnlichen Text zu verstehen, zu interpretieren und zu generieren. Diese Modelle werden anhand umfangreicher Datensätze trainiert, darunter eine Vielzahl von Textquellen wie Websites, Bücher und Artikel. Der „Open-Source“-Aspekt bedeutet, dass der Quellcode des Modells und manchmal auch zusätzliche Komponenten wie Trainingsdaten und vorab trainierte Modelle für jedermann zum Zugriff, zur Änderung und zum Vertrieb verfügbar sind. Diese Offenheit fördert einen kollaborativen Ansatz bei Entwicklung und Innovation und ermöglicht es Forschern, Entwicklern und Unternehmen, die Modelle an ihre spezifischen Bedürfnisse und Herausforderungen anzupassen.

Welchen Nutzen haben Open-Source-LLMs für die Tech-Community?

Der Hauptvorteil von Open-Source-LLMs für die Tech-Community ist ihre Rolle bei der Demokratisierung der KI-Technologie. Indem sie Zugang zu modernsten Modellen bieten, senken sie die Eintrittsbarrieren für Einzelpersonen und Organisationen, die im Bereich KI forschen und Innovationen entwickeln möchten. Diese Zugänglichkeit fördert eine kollaborative Umgebung, in der Verbesserungen und Innovationen geteilt werden können, was zu robusteren, effizienteren und faireren Modellen führt. Darüber hinaus ermöglichen Open-Source-Modelle eine größere Transparenz in der KI, sodass Benutzer die von ihnen verwendete Technologie verstehen und ihr vertrauen können, indem sie den zugrunde liegenden Code und die Schulungsprozesse untersuchen.

Können Open-Source-LLMs für bestimmte Anwendungen angepasst werden?

Ja, einer der wesentlichen Vorteile von Open Source LLMs ist ihre Flexibilität und Anpassungsfähigkeit für spezifische Anwendungen. Entwickler können diese Modelle anhand spezieller Datensätze verfeinern, um ihre Leistung bei Aufgaben wie der Analyse von Rechtsdokumenten, der Zusammenfassung medizinischer Forschung oder der Automatisierung des Kundendienstes zu verbessern. Dieser Anpassungsprozess umfasst die Anpassung der Modellparameter und das weitere Training anhand von Daten, die den spezifischen Kontext oder die interessierende Domäne widerspiegeln, was zu einer verbesserten Genauigkeit und Relevanz für die beabsichtigte Anwendung führt.

Welche Herausforderungen sind mit der Nutzung von Open Source LLMs verbunden?

Während Open-Source-LLMs zahlreiche Vorteile bieten, bringen sie auch einige Herausforderungen mit sich. Eine große Herausforderung ist der Bedarf an erheblichen Rechenressourcen für das Training und die Feinabstimmung dieser Modelle, was für Einzelpersonen oder kleine Organisationen unerschwinglich sein kann. Darüber hinaus kann die Verwaltung und Verarbeitung der großen Datenmengen, die für das Training benötigt werden, komplex und ressourcenintensiv sein. Eine weitere Herausforderung besteht darin, die ethische Verwendung dieser Modelle sicherzustellen, da sie manchmal voreingenommene oder unangemessene Inhalte erzeugen können, wenn sie nicht sorgfältig überwacht und angepasst werden. Schließlich kann die Navigation in den Lizenz- und Nutzungsrechten von Open-Source-Modellen kompliziert sein und erfordert sorgfältige Aufmerksamkeit, um die Einhaltung sicherzustellen.

Wie kann man zur Entwicklung von Open Source LLMs beitragen?

Der Beitrag zur Entwicklung von Open-Source-LLMs kann viele Formen annehmen. Entwickler, Forscher und Enthusiasten können einen Beitrag leisten, indem sie Verbesserungen an der Architektur des Modells teilen, seine Leistung optimieren oder seine Sicherheit erhöhen. Zu den Beiträgen kann auch die Bereitstellung oder Kuratierung hochwertiger Trainingsdatensätze gehören, die für die Fähigkeit des Modells, relevante und unvoreingenommene Inhalte zu verstehen und zu generieren, von entscheidender Bedeutung sind. Darüber hinaus sind die Dokumentation von Anwendungsfällen, das Schreiben von Tutorials und die Bereitstellung von Feedback zur Leistung des Modells in verschiedenen Anwendungen wertvolle Beiträge, die der Community helfen, diese Modelle effektiver zu nutzen.

Zusammenfassung

Die Erforschung von Open-Source-MMLs offenbart ein dynamisches und vielversprechendes Feld innerhalb der künstlichen Intelligenz, das die Art und Weise, wie wir mit Technologie interagieren, erheblich beeinflussen wird. Diese Modelle, die sich durch ihre Fähigkeit auszeichnen, menschenähnlichen Text zu verstehen und zu generieren, erweitern nicht nur die Grenzen der Verarbeitung natürlicher Sprache, sondern fördern auch eine Kultur der Zusammenarbeit und Innovation. Die Art dieser Open-Source-LLMs demokratisiert den Zugang zu modernster KI und ermöglicht einem breiten Spektrum von Benutzern, diese Modelle auf vielfältige und sinnvolle Weise anzupassen, zu verbessern und anzuwenden. Trotz der Herausforderungen, die mit ihrer Nutzung verbunden sind, machen die potenziellen Vorteile und Chancen, die sie bieten, Open-Source-LLMs zu einer entscheidenden Entwicklung in der laufenden Entwicklung der KI-Technologie. Da die Community weiter wächst und Beiträge leistet, können wir davon ausgehen, dass diese Modelle noch ausgefeilter, zugänglicher und wirkungsvoller werden.

ClassMaker

14 beste Newsletter-Software

11 bestbewertete HRIS-Systeme

EdApp

Die 11 besten Suchmaschinen für künstliche Intelligenz