13 bedste ETL-værktøjer

I big data-æraen oversvømmes virksomheder med information fra en lang række kilder. Disse data kan, hvis de udnyttes korrekt, give uvurderlig indsigt, der driver strategisk beslutningstagning. Udfordringen ligger dog i effektivt at udtrække, transformere og indlæse (ETL) disse data til et format, der er klar til analyse. ETL-værktøjer er svaret på denne udfordring. De er software, der er specielt designet til at understøtte ETL-processer, såsom at udtrække data fra forskellige kilder, skrubbe og rense data for at opnå højere kvalitet og konsolidere det hele i datavarehuse. ETL-værktøjer forenkler datastyringsstrategier og forbedrer datakvaliteten gennem en standardiseret tilgang, hvilket gør dem til en væsentlig komponent i enhver datadrevet organisation.

Hvad er et ETL-værktøj?

ETL, som står for Extract, Transform and Load, er en dataintegrationsproces, der kombinerer data fra flere kilder til et enkelt, konsistent datalager, der indlæses i et datavarehus eller et andet målsystem. Processen begynder med udtrækning af data fra forskellige kilder, som kan omfatte databaser, applikationer eller filer. Disse rådata lagres derefter midlertidigt i et mellemrum.

I transformationsfasen behandles rådataene og forberedes til dets tilsigtede brug. Dette kunne involvere at rense dataene, fjerne dubletter og konvertere dem til et format, der er kompatibelt med målsystemet. De transformerede data indlæses derefter i målsystemet, såsom et datavarehus. Denne proces er typisk automatiseret og veldefineret, hvilket giver mulighed for effektiv og nøjagtig dataintegration.

ETL er en afgørende komponent i data warehousing og business intelligence, der gør det muligt for organisationer at konsolidere deres data på et enkelt sted til analyse og rapportering. Det giver en systematisk og nøjagtig måde at analysere data på, hvilket sikrer, at alle virksomhedsdata er konsistente og opdaterede. ETL-processen har udviklet sig over tid, med moderne ETL-værktøjer, der tilbyder mere avancerede funktioner og muligheder, såsom dataintegration i realtid og cloud-baseret databehandling.

Behovet for ETL-værktøjer

I nutidens datadrevne verden er behovet for ETL-værktøjer mere presserende end nogensinde. Virksomheder genererer enorme mængder data dagligt, og manuelle ETL-processer er ikke længere gennemførlige. ETL-værktøjer automatiserer udvindings-, transformations- og indlæsningsprocesserne og sikrer, at dataene er nøjagtige og klar til analyse. De nedbryder datasiloer, hvilket gør det nemt for datavidenskabsfolk at få adgang til og analysere data, og omdanner dem til handlingsorienteret business intelligence. ETL-værktøjer forbedrer også datakvaliteten ved at fjerne uoverensstemmelser og anomalier, og de forenkler dataintegrationsprocessen, idet de problemfrit kombinerer data fra forskellige kilder. Dette resulterer i tidseffektivitet, da behovet for at forespørge flere datakilder er elimineret, hvilket fremskynder beslutningsprocesser.

Hvordan fungerer ETL Tools?

ETL-værktøjer fungerer i tre hovedstadier: udvinding, transformation og indlæsning. I udvindingsfasen trækkes data fra forskellige kilder, som kan spænde fra databaser og applikationer til regneark og cloud-baseret lagring. Disse data transformeres derefter, hvilket involverer rensning, validering og omformatering af dataene for at sikre, at de lever op til de nødvendige kvalitetsstandarder. Den sidste fase er indlæsning, hvor de transformerede data indlæses i et datavarehus eller et andet målsystem til lagring og analyse. ETL-værktøjer automatiserer hele denne proces, reducerer fejl og fremskynder dataintegration. De giver også grafiske grænseflader til hurtigere og nemmere resultater end traditionelle metoder til at flytte data gennem håndkodede datapipelines.

13 bedste ETL-værktøjer

- Integrate.io

- Talent

- IBM DataStage

- Oracle Data Integrator

- Fivetran

- Coupler.io

- AWS Lim

- Stitch

- Skyvia

- Azure Data Factory

- SAS Data Management

- Google Cloud Dataflow

- Portable

Hvordan vælger man de bedste ETL-værktøjer?

At vælge de rigtige ETL-værktøjer afhænger af flere faktorer. Overvej først kompleksiteten af dine datakrav. Et fantastisk ETL-værktøj bør være i stand til at flytte og transformere store mængder data hurtigt og effektivt med minimal indsats. Det bør også understøtte flere datakilder, så du nemt kan kombinere datasæt fra forskellige kilder. En intuitiv brugergrænseflade er nøglen til hurtigt at manipulere data, konfigurere indstillinger og planlægge opgaver. Overvej desuden skalerbarheden af værktøjet, kompleksiteten af dine dataintegrationskrav og dit budget. Forskellige organisationer kan have forskellige behov, så det bedste ETL-værktøj kan variere afhængigt af din specifikke situation og anvendelsestilfælde.

ETL-værktøjer (gratis og betalt)

1. Integrate.io

Integrate.io er en førende dataintegrationsløsning, der giver en samlet, lav-kode data warehouse integrationsplatform. Det tilbyder en omfattende pakke af værktøjer og stik til at understøtte hele din datarejse. Med sin brugervenlige grænseflade og robuste funktionalitet giver Integrate.io virksomheder i stand til at konsolidere, behandle og forberede data til analyser og derved muliggøre informeret beslutningstagning.

Hvad gør Integrate.io?

Integrate.io fungerer som et skybaseret ETL-værktøj, der giver mulighed for at skabe visualiserede datapipelines til automatiserede datastrømme på tværs af en lang række kilder og destinationer. Det giver et kodnings- og jargonfrit miljø, hvilket gør det tilgængeligt for både tekniske og ikke-tekniske brugere. Integrate.io letter implementeringen af hændelsesdrevet arkitektur, datastreaming i realtid og API-oprettelse med minimal kodning, hvilket adresserer udfordringer såsom ufleksible databehandlingspipelines og skalerbarhedsbegrænsninger.

Integrate.io Nøglefunktioner

Nem datatransformation: Integrate.io forenkler dine ETL- og ELT-processer ved at tilbyde en simpel træk-og-slip-brugergrænseflade med lav kode og over et dusin transformationer – som sorter, join, filtrer, vælg, begræns, klon osv.

Simpel oprettelse af arbejdsgange til at definere afhængigheder mellem opgaver: Denne funktion giver brugerne mulighed for nemt at definere rækkefølgen og afhængighederne af databehandlingsopgaver, hvilket sikrer et effektivt og fejlfrit dataflow.

REST-API: Integrate.io leverer en omfattende REST API-løsning, der gør det muligt for brugere at oprette API'er med minimal kodning og fleksibel implementering.

Salesforce til Salesforce-integrationer: Denne funktion giver brugerne mulighed for at udtrække Salesforce-data, transformere dem og injicere dem tilbage i Salesforce, hvilket giver en unik fordel for virksomheder, der er stærkt afhængige af Salesforce-data til CRM og andre forretningsaktiviteter.

Datasikkerhed og overholdelse: Integrate.io sikrer sikkerheden af dine data med indbyggede krypteringsfunktioner og overholdelse af databeskyttelsesforskrifter.

Forskellige datakilder og destinationsmuligheder: Integrate.io understøtter en lang række datakilder og destinationer, hvilket giver fleksibilitet og alsidighed i dataintegration.

Integrate.io prisplaner

Integrate.io tilbyder tre hovedprisplaner: Enterprise Plan, Professional Plan og Starter Plan.

Enterprise Plan: Denne plan er designet til store virksomheder med omfattende dataintegrationsbehov. Det tilbyder avancerede funktioner og premium support. Prisen for denne plan er tilpasset og kan fås ved at kontakte Integrate.io direkte.

Professionel plan: Denne plan, prissat til $25,000 om året, er velegnet til mellemstore virksomheder. Det tilbyder en balance mellem avancerede funktioner og overkommelighed.

Starter Plan: Denne plan, prissat til $15,000 om året, er ideel til små virksomheder eller startups med grundlæggende dataintegrationsbehov. Det tilbyder væsentlige funktioner til en overkommelig pris.

Integrate.io accepterer debet- og kreditkort samt bankoverførsel til betalinger.

2. Talent

Talend er en omfattende datastyringsløsning, som tusindvis af organisationer er afhængige af for at omdanne data til handlingsvenlig forretningsindsigt. Det er en fleksibel og pålidelig platform, der understøtter end-to-end datastyringsbehov på tværs af en hel organisation, fra integration til levering. Talend kan implementeres på stedet, i skyen eller i et hybridt miljø, hvilket gør det til et alsidigt værktøj til enhver dataarkitektur. Den er designet til at levere klar og forudsigelig værdi og samtidig understøtte sikkerheds- og compliancebehov.

Hvad laver Talend?

Talend leverer ensartede udviklings- og administrationsværktøjer til at integrere og behandle alle dine data. Det er en softwareintegrationsplatform, der tilbyder løsninger til dataintegration, datakvalitet, datahåndtering, dataforberedelse og big data. Talend hjælper organisationer med at træffe beslutninger i realtid og blive mere datadrevne ved at gøre data mere tilgængelige, forbedre deres kvalitet og hurtigt flytte dem til målsystemer. Det er det eneste ETL-værktøj med alle plugins, der nemt kan integreres med Big Data-økosystemet.

Talends nøglefunktioner

Dataintegration: Talend tilbyder robuste dataintegrationsmuligheder. Det giver en række SQL-skabeloner til at forenkle de mest almindelige dataforespørgsler og opdateringer, oprettelse og ændring af skemaer og datastyringsopgaver.

Datakvalitet: Talend sikrer kvaliteten af data ved at levere funktioner til dataprofilering, rensning og overvågning. Det hjælper virksomheder med at forbedre kvaliteten af deres data, hvilket gør dem mere tilgængelige og hurtigt flyttet til målsystemer.

Data Governance: Talend understøtter datastyring ved at levere funktioner til datakatalogisering, dataafstamning og databeskyttelse. Det hjælper organisationer med at opretholde overholdelse af dataregler og sikre sikkerheden af deres data.

Low-Code platform: Talend er en lav-kode platform, der forenkler processen med at udvikle dataintegrations arbejdsgange. Det giver en visuel designer, der gør det nemt at oprette og administrere datapipelines.

Skalerbarhed: Talend er designet til at skalere problemfrit, efterhånden som databehovet vokser. Det kan håndtere store mængder data og komplekse databehandlingsopgaver, hvilket gør det til en fremtidssikker investering for virksomheder.

Cloud og Big Data Integration: Talend understøtter integration med forskellige cloud-platforme og big data-teknologier. Det giver forbindelser til pakkede applikationer, databaser, mainframes, filer, webtjenester og mere.

Talentprisplaner

Talend tilbyder flere prisplaner for at imødekomme forskellige forretningsbehov. De tilgængelige planer inkluderer:

Datahåndteringsplatform: Denne plan tilbyder omfattende dataintegration og administrationsfunktioner. Det er designet til virksomheder, der har brug for at integrere, rense og administrere data fra forskellige kilder.

Big Data platform: Denne plan er designet til virksomheder, der skal håndtere store mængder data. Det tilbyder funktioner til big data-integration, datakvalitet og datastyring.

Datastof: Dette er Talends mest omfattende plan. Den kombinerer funktionerne fra Data Management Platform og Big Data Platform og tilføjer yderligere muligheder for applikations- og API-integration.

For prisoplysninger skal brugerne kontakte salgsteamet.

3. IBM DataStage

IBM DataStage står som et robust og alsidigt ETL-værktøj, designet til at lette og strømline processen med dataintegration på tværs af forskellige systemer. Dens muligheder er forankret i en kraftfuld parallel behandlingsarkitektur, som sikrer skalerbarhed og høj ydeevne til dataintensive operationer. Som en del af IBM Cloud Pak for Data as a Service tilbyder DataStage en omfattende løsning, der understøtter en bred vifte af dataintegrationsopgaver, fra simple til komplekse. Den er konstrueret til at fungere problemfrit på stedet eller i skyen, hvilket giver fleksibilitet til virksomheder i styringen af deres dataarbejdsgange. Platformens virksomhedsforbindelse og udvidelsesmuligheder gør den til et passende valg for organisationer, der ønsker at udnytte deres data til indsigtsfulde analyser og AI-applikationer, hvilket sikrer, at de kan levere kvalitetsdata pålideligt til interessenter.

Hvad laver IBM DataStage?

IBM DataStage udmærker sig ved at udtrække data fra flere kilder, transformere dem til at opfylde forretningskrav og indlæse dem i målsystemer, uanset om de er lokale databaser, cloud-lagre eller datavarehuse. Den er designet til at håndtere en bred vifte af dataformater og strukturer, hvilket gør det muligt for virksomheder at integrere forskellige datakilder med lethed. Værktøjets kraftfulde transformationsfunktioner muliggør kompleks databehandling, herunder datarensning og overvågning, for at sikre, at de leverede data er af højeste kvalitet. Med sin parallelle behandlingsmotor kan DataStage effektivt behandle store mængder data, hvilket gør det til en ideel løsning for virksomheder, der håndterer big data-udfordringer. Derudover giver dens åbne og udvidelige natur mulighed for tilpasning og integration med andre AI- og analyseplatforme, hvilket giver en problemfri dataintegrationsoplevelse, der understøtter en bred vifte af datadrevne initiativer.

IBM DataStage Nøglefunktioner

Parallelbehandling: IBM DataStage udnytter en højtydende parallel bearbejdningsmotor, der muliggør effektiv håndtering af store datamængder, hvilket væsentligt reducerer den tid, der kræves til dataintegrationsopgaver.

Enterprise Connectivity: Værktøjet tilbyder omfattende tilslutningsmuligheder, hvilket muliggør problemfri integration med en lang række virksomhedssystemer, databaser og applikationer, hvilket letter et samlet dataøkosystem.

Cloud-kompatibilitet: DataStage er designet til at køre på ethvert cloudmiljø, hvilket giver fleksibilitet og skalerbarhed til virksomheder, der ønsker at udnytte cloud-ressourcer til deres dataintegrationsbehov.

Datarensning og overvågning: Den indeholder funktioner til at rense og overvåge data, der sikrer, at de oplysninger, der behandles og leveres, er nøjagtige, konsistente og af høj kvalitet.

udvidelsesmuligheder: Platformen er åben og kan udvides, hvilket giver mulighed for tilpasning og integration med andre data og AI-værktøjer, hvilket forbedrer dens muligheder for at opfylde specifikke forretningskrav.

End-to-end dataintegration: DataStage leverer en omfattende løsning for hele dataintegrationslivscyklussen, fra udvinding og transformation til indlæsning, hvilket gør det til en one-stop-shop for alle dataintegrationsaktiviteter.

IBM DataStage-prisplaner

IBM DataStage tilbyder en række prisplaner, der er skræddersyet til at imødekomme behovene i forskellige organisationer, fra små virksomheder til store virksomheder. Hver plan er designet til at give specifikke funktioner og muligheder, hvilket sikrer, at virksomheder kan vælge den mulighed, der passer bedst til deres dataintegrationskrav og budget. Brugere skal kontakte salgsteamet for et prisinformationsmøde.

IBM DataStage accepterer debet- og kreditkort til betalinger.

4. Oracle Data Integrator

Oracle Data Integrator (ODI) er et ETL-værktøj og en omfattende dataintegrationsplatform, der imødekommer en bred vifte af dataintegrationsbehov. Den er designet til at håndtere højvolumen, højtydende batchbelastninger, hændelsesdrevne, trickle-feed-integrationsprocesser og SOA-aktiverede datatjenester. Den seneste version, ODI 12c, tilbyder overlegen udviklerproduktivitet og en forbedret brugeroplevelse med en redesignet flow-baseret deklarativ brugergrænseflade. Det giver også en dybere integration med Oracle GoldenGate, der tilbyder omfattende big data-understøttelse og tilføjet parallelitet ved eksekvering af dataintegrationsprocesser.

Hvad gør Oracle Data Integrator?

Oracle Data Integrator er et strategisk dataintegrationstilbud fra Oracle, der giver en fleksibel og højtydende arkitektur til at udføre dataintegrationsprocesser. Den er designet til at håndtere højvolumen, højtydende batchbelastninger, hændelsesdrevne, trickle-feed-integrationsprocesser og SOA-aktiverede datatjenester. ODI 12c, den seneste version, tilbyder overlegen udviklerproduktivitet og en forbedret brugeroplevelse med en redesignet flow-baseret deklarativ brugergrænseflade. Det giver også en dybere integration med Oracle GoldenGate, der tilbyder omfattende big data-understøttelse og tilføjet parallelitet ved eksekvering af dataintegrationsprocesser.

Oracle Data Integrator Nøglefunktioner

Højtydende arkitektur: Oracle Data Integrator tilbyder en fleksibel og højtydende arkitektur, der giver mulighed for effektive dataintegrationsprocesser. Det understøtter højvolumen, højtydende batchbelastninger, hændelsesdrevne, trickle-feed-integrationsprocesser og SOA-aktiverede datatjenester.

Forbedret brugeroplevelse: Den seneste version, ODI 12c, giver en forbedret brugeroplevelse med en redesignet flow-baseret deklarativ brugergrænseflade. Denne grænseflade øger udviklerproduktiviteten og gør det nemmere at administrere og udføre dataintegrationsprocesser.

Dyb integration med Oracle GoldenGate: Oracle Data Integrator giver dybere integration med Oracle GoldenGate. Denne integration giver mulighed for omfattende big data-understøttelse og tilføjet parallelitet ved eksekvering af dataintegrationsprocesser.

Big Data Support: Oracle Data Integrator tilbyder omfattende big data-understøttelse. Den integreres problemfrit med big data-platforme som Hadoop og Spark, hvilket muliggør effektiv behandling og analyse af store datasæt.

Samarbejdsudvikling og versionskontrol: Oracle Data Integrator tilbyder funktioner til kollaborativ udvikling og versionskontrol. Disse funktioner letter teambaserede ETL-projekter og sikrer, at alle ændringer spores og administreres effektivt.

Robuste sikkerhedsfunktioner: Oracle Data Integrator tilbyder robuste sikkerhedsfunktioner og integreres med eksisterende sikkerhedsrammer. Dette sikrer datafortrolighed og overholdelse af forskellige databeskyttelsesforskrifter.

Prisplaner for Oracle Data Integrator

Oracle Data Integrator tilbyder en række prisplaner for at imødekomme forskellige brugerbehov. Prisen er baseret på en per-kerne licensmodel, med årlige abonnementer, der spænder fra flere tusinde til titusindvis af dollars om året. De nøjagtige omkostninger afhænger af antallet af krævede kerner, implementeringsmuligheder (cloud vs. on-premises) og yderligere nødvendige funktioner. For eksempel kan en grundlæggende cloud-implementering med 2 kerner koste omkring $5,000 om året, mens en større on-premises-implementering med 16 kerner og avancerede funktioner kan koste op mod $50,000 om året.

Oracle Data Integrator accepterer debet- og kreditkort, PayPal og bankoverførsel til betalinger.

5. Fivetran

Fivetran er en førende platform til automatiseret databevægelse designet til at strømline processen med dataintegration og centralisering. Det er et robust ETL-værktøj, der giver virksomheder mulighed for at opnå selvbetjeningsanalyse, bygge tilpassede dataløsninger og bruge mindre tid på at integrere systemer. Fivetran er en perfekt platform for ingeniører, analytikere og udviklere, der ønsker at centralisere data til rapporter, analyser og bygning med data.

Hvad laver Fivetran?

Fivetran er en cloud-baseret datapipeline, der automatiserer processen med at udtrække data fra forskellige kilder, transformere dem til et brugbart format og indlæse dem i et datavarehus til analyse. Det fjerner flaskehalse i dataprocesser uden at gå på kompromis med compliance, hvilket gør det til en ideel løsning for virksomheder, der har behov for at udvide deres dataplatform for at understøtte tilpassede behov. Uanset om du er en ingeniør, der ønsker at bruge mindre tid på at integrere systemer, en analytiker, der arbejder med SQL- eller BI-værktøjer, eller en udvikler, der bygger med data, gør Fivetran's API og webhooks det til et alsidigt værktøj til alle dine databehov.

Fivetran nøglefunktioner

Automatiseret dataintegration: Fivetran forenkler processen med dataintegration ved at automatisere udtrækning, transformation og indlæsning af data fra forskellige kilder til et datavarehus.

Selvbetjeningsanalyse: Fivetran gør det muligt for virksomheder at opnå selvbetjeningsanalyse ved at fjerne flaskehalse i dataprocesser, hvilket muliggør mere effektiv dataanalyse og beslutningstagning.

Tilpassede dataløsninger: Med Fivetran kan virksomheder udvide deres dataplatform til at understøtte tilpassede behov, hvilket giver fleksibilitet og tilpasningsevne i håndtering af data.

API og Webhooks: Fivetran tilbyder API og webhooks, hvilket gør det til en perfekt platform for udviklere, der bygger med data.

Overholdelse uden kompromis: Fivetran sikrer dataoverholdelse uden at gå på kompromis med effektiviteten af dataprocesser, hvilket giver virksomhederne ro i sindet.

Support til forskellige brugertyper: Uanset om du er ingeniør, analytiker eller udvikler, imødekommer Fivetran dine databehov, hvilket gør det til et alsidigt værktøj til forskellige brugertyper.

Fivetran prisplaner

Fivetran tilbyder fire forskellige prisplaner: Gratis plan, Starter Plan, Standard Plan og Enterprise Plan. For prisfastsættelse af hver plan skal brugerne kontakte salgsteamet.

Gratis Plan: Den gratis plan er et grundlæggende tilbud, der giver brugerne mulighed for at opleve kernefunktionerne i Fivetran.

Starter Plan: Startplanen inkluderer alt i gratisplanen med yderligere funktioner og muligheder for mere omfattende dataintegrationsbehov.

Standardplan: Standardplanen inkluderer alt i startplanen, plus ubegrænsede brugere, 15-minutters synkroniseringer, databaseforbindelser og adgang til Fivetrans REST API.

Enterprise Plan: Enterprise Planen inkluderer alt i standardplanen, plus virksomhedsdatabaseforbindelser, 1-minutters synkroniseringer, detaljerede roller og support til teams, avanceret datastyring, avancerede sikkerheds- og dataopholdsmuligheder og prioriteret support.

Fivetran accepterer debet- og kreditkort til betalinger.

6. Coupler.io

Coupler.io er en alt-i-én dataanalyse- og automatiseringsplatform designet til at strømline processen med dataindsamling, transformation og automatisering. Det giver virksomheder mulighed for at træffe datadrevne beslutninger ved at give et enkelt sandhedspunkt mellem forskellige datakilder. Med sin brugervenlige grænseflade og robuste funktionalitet forenkler Coupler.io den komplekse opgave med dataanalyse, så virksomheder kan fokusere på at udlede værdifuld indsigt fra deres data.

Hvad gør Coupler.io?

Coupler.io fungerer som et integrationsværktøj, der synkroniserer data mellem forskellige tjenester på en tidsplan. Det giver virksomheder mulighed for nemt at eksportere og kombinere data fra de apps, de bruger, ved at forbinde deres virksomhedsapplikationer til regneark, regneark, databaser eller datavisualiseringsværktøjer på få minutter. Coupler.io tilbyder over 200 integrationer, der gør det muligt for virksomheder at indsamle og analysere data ét sted. Det giver også et transformationsmodul, der giver brugerne mulighed for at få vist, transformere og strukturere deres data, før de flyttes til destinationen. Coupler.io automatiserer også datahåndtering med webhooks, integrerer importører i interne arbejdsgange for at underrette systemer om eksekveringsopdateringsdata i apps eller starte dataimport automatisk.

Coupler.io Nøglefunktioner

Dataintegration: Coupler.io giver en robust dataintegrationsfunktion, der gør det muligt for virksomheder at forbinde deres applikationer til forskellige datakilder, hvilket gør dem i stand til at indsamle og analysere data ét sted.

Datatransformation: Med Transform-modulet kan brugere få vist, transformere og strukturere deres data direkte i Coupler.io, før de flyttes til destinationen. Denne funktion giver virksomheder mulighed for at fokusere på de data, der betyder mest for dem.

Automation: Coupler.io automatiserer datahåndtering med webhooks, integrerer importører i interne arbejdsgange for at underrette systemer om eksekveringsopdateringsdata i apps eller starte dataimport automatisk.

Planlægning: Coupler.io giver mulighed for planlægning for at automatisere dataforfriskningsprocessen. Brugere kan indstille specifikke intervaller for værktøjet til automatisk at opdatere de importerede data, hvilket sikrer, at rapporter eller analyser altid er opdaterede.

Understøttelse af forskellige datatyper: Coupler.io understøtter forskellige datatyper, herunder tal, datoer, tekster og endda billeder, hvilket giver fleksibilitet i datahåndtering.

Dataanalyse konsulentydelser: Ud over dataintegrationsværktøjet tilbyder Coupler.io dataanalyse-konsulenttjenester, der giver virksomheder ekspertrådgivning om, hvordan de bedst udnytter deres data.

Coupler.io prisplaner

Coupler.io tilbyder fire prisplaner for at imødekomme forskellige forretningsbehov.

Starter Plan: Pris for $64 pr. måned, denne plan er designet til 2 brugere. Det inkluderer alle kilder, 500 kørsler pr. måned og 10,000 rækker pr. kørsel. Dataene opdateres automatisk på daglig basis.

Holdplan: Denne plan koster $132 pr. måned og er egnet til 5 brugere. Det inkluderer alle kilder, 4,000 kørsler pr. måned og 50,000 rækker pr. kørsel. Dataene opdateres automatisk op til hvert 30. minut.

Business Plan: Til $332 pr. måned er denne plan designet til ubegrænsede brugere. Det inkluderer alle kilder, over 10,000 kørsler pr. måned og over 100,000 rækker pr. kørsel. Dataene opdateres automatisk op til hvert 15. minut.

Enterprise Plan: For priser og funktioner i Enterprise-planen rådes virksomheder til at kontakte Coupler.io direkte.

Coupler.io accepterer debet- og kreditkort til betalinger.

7. AWS Lim

AWS Glue er en serverløs dataintegrationstjeneste, der forenkler processen med at opdage, forberede og integrere data fra flere kilder til analyse, maskinlæring og applikationsudvikling. Den understøtter en bred vifte af arbejdsbelastninger og er designet til at skalere efter behov, hvilket giver skræddersyede værktøjer til forskellige dataintegrationsbehov. AWS Glue er en del af Amazon Web Services (AWS) suite, der tilbyder en omfattende løsning til styring og transformation af data i enhver skala.

Hvad gør AWS Glue?

AWS Glue er designet til at strømline processen med dataintegration. Det opdager, forbereder, flytter og integrerer data fra forskellige kilder, hvilket gør det klar til analyser, maskinlæring og applikationsudvikling. AWS Glue kan starte ETL-job, efterhånden som nye data ankommer, for eksempel kan den konfigureres til at køre ETL-job, så snart nye data bliver tilgængelige i Amazon Simple Storage Service (S3). Det giver også et datakatalog til hurtigt at opdage og søge i flere AWS-datakilder.

AWS lim nøglefunktioner

Indstillinger for dataintegrationsmotor: AWS Glue tilbyder forskellige dataintegrationsmotorer til at understøtte forskellige brugerbehov og arbejdsbelastninger. Den kan køre begivenhedsdrevet ETL-job, hvilket betyder, at den kan starte disse job, så snart der kommer nye data.

AWS Glue Data Katalog: Denne funktion giver brugerne mulighed for hurtigt at opdage og søge i flere AWS-datakilder. Datakataloget er et vedvarende metadatalager for alle dine dataaktiver, uanset hvor de er placeret.

No-Code ETL Jobs: AWS Glue giver mulighed for at administrere og overvåge datakvalitet og til at skabe ETL-job uden behov for kodning. Dette forenkler processen med dataintegration og transformation.

Skala efter behov: AWS Glue er designet til at skalere efter behov, hvilket gør det muligt at understøtte alle arbejdsbelastninger og tilpasse sig brugerens behov.

Support til Git: AWS Glue integreres med Git, et meget brugt open source versionskontrolsystem. Dette giver brugerne mulighed for at opretholde en historik over ændringer af deres AWS Glue-job.

AWS Lim Flex: Dette er en fleksibel udførelsesjobklasse, der giver brugerne mulighed for at reducere omkostningerne ved ikke-hastende arbejdsbelastninger.

Prisplaner for AWS lim

AWS Glue tilbyder en række prisplaner baseret på brugerens specifikke behov. Prisen er primært baseret på de ressourcer, der forbruges, mens jobs kører. Brugere skal kontakte salgsteamet for at få et pristilbud.

AWS Glue accepterer debet- og kreditkort, PayPal og bankoverførsel til betalinger.

8. Stitch

Stitch er en cloud-first, open source-platform designet til hurtigt at flytte data fra forskellige kilder til en destination efter eget valg. Som et kraftfuldt ETL-værktøj forbinder Stitch til en lang række datakilder, fra databaser som MySQL og MongoDB til SaaS-applikationer som Salesforce og Zendesk. Det er designet til at omgå udviklingsarbejdsbyrden, så teams kan fokusere på at bygge deres kerneprodukt og få det hurtigere på markedet. Stitch er ikke et dataanalyse- eller visualiseringsværktøj, men det spiller en afgørende rolle i databevægelsen og sætter scenen for efterfølgende analyse ved hjælp af andre værktøjer.

Hvad laver Stitch?

Stitch er en fleksibel, ubesværet og kraftfuld ETL-tjeneste, der forbinder til alle dine datakilder og replikerer disse data til en destination efter eget valg. Det er designet til sikkert og pålideligt at replikere data i enhver mængde, så du kan vokse uden at bekymre dig om en ETL-fejl. Stitchs infrastruktur er ideel til effektiv håndtering af kritiske arbejdsbelastninger og beskytter med flere overflødige sikkerhedsforanstaltninger mod tab af data i tilfælde af udfald. Det er en ETL SaaS-løsning i verdensklasse, der problemfrit flyder data fra flere kilder til en destination, hvilket giver en hurtig, omkostningseffektiv og problemfri dataintegrationsoplevelse.

Stitch Nøglefunktioner

Automatiserede Cloud Data Pipelines: Stitch tilbyder fuldt automatiserede cloud-datapipelines, der gør det muligt for teams at få indsigt hurtigere og fokusere på at bygge deres kerneprodukt.

Sikker databevægelse: Stitch giver sikre muligheder for forbindelser til alle datakilder og destinationer, inklusive SSL/TLS, SSH-tunneling og IP-hvidliste, hvilket sikrer sikkerheden af dine data under transit.

Fleksibel replikeringskonfiguration: Med Stitch kan du konfigurere din datareplikeringsproces i overensstemmelse med dine behov, hvilket giver fleksibilitet og kontrol over dine databevægelser.

Skalerbar og pålidelig ETL: Stitch er designet til sikkert og pålideligt at replikere data i enhver mængde, så du kan vokse uden at bekymre dig om en ETL-fejl.

Open Source platform: Stitch er en open source-platform, der giver udviklere mulighed for at skabe og samarbejde om integrationer ved hjælp af en fællesskabsdrevet tilgang.

Understøttelse af flere datakilder: Stitch understøtter en lang række datakilder, fra databaser som MySQL og MongoDB til SaaS-applikationer som Salesforce og Zendesk, hvilket sikrer omfattende dataintegration.

Prisplaner for søm

Stitch tilbyder tre prisplaner: Standard, Advanced og Premium. Hver plan er designet til at imødekomme forskellige databehov og kommer med sit eget sæt funktioner.

Standardplan: Standardplanen er en fleksibel plan (startende ved $1100 pr. måned), der vokser med dine behov. Det giver fuld adgang til over 100 datakilder og er prissat baseret på mængden af data over 5 millioner rækker om måneden.

Avanceret Plan: Den avancerede plan, prissat til $1,250 pr. måned, er designet til mere krævende kunder i virksomhedsskala. Det inkluderer yderligere funktioner og tjenester, der ikke er tilgængelige i standardplanen.

Premium Plan: Premium-planen, prissat til $2,500 pr. måned, er det mest omfattende tilbud fra Stitch. Det inkluderer alle funktionerne i den avancerede plan sammen med yderligere premium-funktioner.

Stitch accepterer debet- og kreditkort, PayPal og bankoverførsel til betalinger.

9. Skyvia

Skyvia præsenterer sig selv som en alsidig cloud-baseret platform designet til at imødekomme en række forskellige dataadministrationsbehov. Det tilbyder en omfattende suite af værktøjer til dataintegration, backup og adgang på tværs af forskellige cloud- og lokale datakilder. Med fokus på enkelhed og brugervenlighed har Skyvia til formål at strømline komplekse dataprocesser, så de bliver tilgængelige for både tekniske og ikke-tekniske brugere. Dens no-code tilgang giver mulighed for hurtig opsætning og udførelse af dataopgaver, mens den stadig giver robuste muligheder for dem, der har brug for mere avancerede funktioner.

Hvad laver Skyvia?

Skyvia er et mangefacetteret værktøj, der forenkler processen med at integrere, sikkerhedskopiere og administrere data på tværs af forskellige miljøer. Det gør det muligt for brugere at forbinde en bred vifte af cloud-applikationer, databaser og flade filer uden behov for omfattende kodningsviden. Uanset om det er migrering af data mellem systemer, synkronisering af poster på tværs af platforme eller opsætning af automatiserede arbejdsgange, tilbyder Skyvia en brugervenlig grænseflade til at udføre disse opgaver effektivt. Derudover tilbyder det muligheder for sikker sikkerhedskopiering og gendannelse af data, hvilket sikrer, at kritiske forretningsdata er beskyttet og let gendannes.

Skyvias nøglefunktioner

Cloud dataintegration: Skyvias dataintegrationstjeneste giver brugerne mulighed for at forbinde forskellige datakilder, såsom SaaS-applikationer, databaser og CSV-filer, og flytte data mellem dem uden problemer. Dette inkluderer understøttelse af alle DML-operationer, såsom oprettelse, opdatering, sletning og upsertering af poster, hvilket sikrer, at data forbliver konsistente og opdaterede på tværs af forskellige systemer.

Sikkerhedskopiering og gendannelse: Platformen leverer robuste backup-løsninger til cloud-data, der sikrer, at brugere kan beskytte deres oplysninger mod utilsigtet sletning eller korruption. Gendannelsesprocesser er ligetil, hvilket giver mulighed for hurtig gendannelse af data, når det er nødvendigt.

Data Management: Med Skyvia kan brugere få adgang til og administrere deres data gennem en centraliseret grænseflade. Dette omfatter forespørgsel, redigering og visualisering af data fra forskellige kilder uden behov for direkte interaktion med de underliggende databaser eller applikationer.

No-Code Interface: Platformens kodefri grænseflade giver brugerne mulighed for at udføre komplekse dataopgaver uden at skrive en enkelt linje kode. Dette demokratiserer datahåndtering, hvilket gør det tilgængeligt for en bredere vifte af brugere i en organisation.

Fleksibel planlægning: Skyvia tilbyder fleksible planlægningsmuligheder for dataintegrationsopgaver, hvilket giver brugerne mulighed for at automatisere processer i henhold til deres specifikke krav. Dette kan variere fra at køre opgaver en gang om dagen til næsten realtidssynkronisering, afhængigt af den valgte plan.

Avanceret kortlægning og transformation: Brugere kan drage fordel af kraftfulde kortfunktioner til at transformere data, når de bevæger sig mellem kilder. Dette omfatter opdeling af data, brug af udtryk og formler og opsætning af opslag, som er afgørende for at sikre, at dataene passer til målskemaet.

Skyvias prisplaner

Skyvia tilbyder en række prisplaner for at imødekomme forskellige brugerbehov og budgetter.

Gratis Plan: Denne plan er designet til brugere, der kræver grundlæggende integrationsfunktioner, og tilbyder 10,000 poster om måneden med daglig planlægning og to planlagte integrationer.

Grundlæggende Plan: Målrettet mod små virksomheder eller individuelle brugere, den grundlæggende plan, prissat til $19 pr. måned ($15 pr. måned, når der faktureres årligt), øger antallet af registreringer og planlægningsmuligheder, hvilket giver mere fleksibilitet til almindelige dataopgaver.

Standardplan: For organisationer med mere krævende integrationsbehov tilbyder standardplanen, prissat til $99 pr. måned ($79 pr. måned, når der faktureres årligt), et højere antal poster, hyppigere planlægning og yderligere funktioner som avancerede kortlægnings- og transformationsværktøjer.

Professionel plan: Den professionelle plan er skræddersyet til store virksomheder, der kræver omfattende dataintegrationsfunktioner, herunder ubegrænsede planlagte integrationer og den korteste udførelsesfrekvens.

Skyvia accepterer forskellige betalingsmetoder, herunder debet- og kreditkort, og bankoverførsler for at imødekomme brugernes præferencer.

10. Azure Data Factory

Azure Data Factory er en cloud-baseret dataintegrationstjeneste, der giver brugerne mulighed for at oprette, planlægge og orkestrere dataarbejdsgange. Det er designet til at lette bevægelse og transformation af data på tværs af forskellige datalagre, både på stedet og i skyen. Med fokus på brugervenlighed giver det en visuel grænseflade til opbygning af komplekse ETL-processer, der kan skaleres for at imødekomme kravene fra big data-arbejdsbelastninger.

Hvad gør Azure Data Factory?

Azure Data Factory gør det muligt for virksomheder at integrere forskellige datakilder, uanset om de befinder sig i forskellige cloud-tjenester eller lokal infrastruktur. Det fungerer som limen, der samler data fra flere kilder, hvilket giver mulighed for datatransformation og -analyse på en centraliseret, styret måde. Denne service understøtter en række ETL- og dataintegrationsscenarier, fra simpel databevægelse til komplekse databehandlingspipelines, og den er i stand til at håndtere store mængder data effektivt.

Azure Data Factory Nøglefunktioner

Dataintegrationsfunktioner: Azure Data Factory tilbyder robuste dataintegrationsfunktioner, der giver brugerne mulighed for problemfrit at oprette forbindelse til en bred vifte af datakilder, herunder databaser, filsystemer og cloud-tjenester.

Visuelle datastrømme: Værktøjet giver en visuel grænseflade til at designe datadrevne arbejdsgange, hvilket gør det nemmere for brugerne at opsætte og administrere deres datapipelines uden behov for omfattende kodning.

Administreret ETL Services: Den leverer en fuldt administreret ETL-tjeneste, hvilket betyder, at brugerne ikke behøver at bekymre sig om infrastrukturstyring, og kan fokusere på at designe deres datatransformationslogik.

Support til forskellige computertjenester: Azure Data Factory integreres med forskellige Azure compute-tjenester, såsom Azure HDInsight og Azure Databricks, hvilket muliggør kraftfuld databehandling og analyse.

Planlægning og begivenhedsdrevne udløsere: Brugere kan planlægge datapipelines eller indstille dem til at køre som reaktion på bestemte hændelser, hvilket giver fleksibilitet og sikrer, at data behandles rettidigt.

Overvågnings- og styringsværktøjer: Tjenesten inkluderer værktøjer til overvågning og styring af datapipelines, hvilket giver brugerne synlighed i deres dataarbejdsgange og mulighed for at fejlfinde problemer, efterhånden som de opstår.

Prisplaner for Azure Data Factory

Azure Data Factory tilbyder flere prisplaner for at imødekomme forskellige brugerbehov og budgetbegrænsninger. Brugere kan beregne deres tilpassede plan ved hjælp af Azure Data Factory prisberegner.

Betalinger for Azure Data Factory kan foretages ved hjælp af debet- og kreditkort, PayPal og bankoverførsel.

11. SAS Data Management

SAS Data Management står som en omfattende løsning designet til at styrke organisationer i deres søgen efter at administrere og optimere datapipelines effektivt. Det er en platform, der henvender sig til over 80,000 organisationer, hvilket letter problemfri dataforbindelse, forbedrede transformationer og robust styring. Værktøjet er udviklet til at give et samlet overblik over data på tværs af forskellige lagersystemer, herunder databaser, datavarehuse og datasøer. Det understøtter forbindelser med førende cloud-platforme, lokale systemer og multicloud-datakilder, strømliner dataarbejdsgange og eksekverer ELT med lethed. SAS Data Management er anerkendt for sin evne til at sikre overholdelse af lovgivning, opbygge tillid til data og tilbyde gennemsigtighed, hvilket positionerer sig som førende inden for datakvalitetsløsninger.

Hvad gør SAS Data Management?

SAS Data Management er et alsidigt værktøj, der gør det muligt for virksomheder at administrere deres datalivscyklus omfattende. Det giver en intuitiv, peg-og-klik grafisk brugergrænseflade, der forenkler komplekse datahåndteringsopgaver. Brugere kan forespørge og bruge data på tværs af flere systemer uden behov for fysisk afstemning eller dataflytning, hvilket tilbyder en omkostningseffektiv løsning til forretningsbrugere. Værktøjet understøtter masterdatastyring med funktioner som semantiske databeskrivelser og sofistikeret fuzzy matching for at sikre dataintegritet. Derudover tilbyder SAS Data Management grid-aktiveret belastningsbalancering og multithreaded parallel behandling til hurtig datatransformation og -bevægelse, hvilket eliminerer behovet for overlappende, redundante værktøjer og sikrer en samlet datastyringstilgang.

SAS Data Management Nøglefunktioner

Problemfri dataforbindelse: SAS Data Management udmærker sig ved at forbinde forskellige datakilder, hvilket giver brugerne mulighed for at få adgang til og integrere data på tværs af forskellige platforme uden besværet med manuel indgriben.

Forbedrede transformationer: Værktøjet tilbyder avancerede datatransformationsfunktioner, der gør det muligt for brugere at manipulere og forfine deres data effektivt, hvilket sikrer, at de er klar til analyse og rapportering.

Robust styring: Med SAS Data Management kan organisationer håndhæve datastyringspolitikker, sikre datakvalitet og overholdelse af regulatoriske standarder.

Samlet datavisning: Det giver et omfattende overblik over en organisations datalandskab, hvilket gør det nemmere at administrere og analysere data fra et centralt punkt.

Lavkode visuel designer: Platformen inkluderer en lavkode, selvbetjent visuel designer, der forenkler oprettelsen og styringen af datapipelines, hvilket gør den tilgængelig for brugere med varierende teknisk ekspertise.

Regulatory Compliance: SAS Data Management sikrer, at datahåndteringsprocesser overholder industriens regler, og hjælper organisationer med at bevare tillid og gennemsigtighed i deres datahåndteringspraksis.

SAS Data Management Prisplaner

SAS Data Management tilbyder skræddersyede prisplaner, der er skræddersyet til organisationers specifikke behov. For at forstå hele spektret af prismuligheder og funktionerne inkluderet i hver plan, opfordres interesserede parter til at anmode om en demo.

12. Google Cloud Dataflow

Google Cloud Dataflow er en fuldt administreret tjeneste, der forenkler kompleksiteten af databehandling i stor skala. Den tilbyder en samlet programmeringsmodel til både batch- og streambehandling, hvilket betyder, at den kan håndtere både behandlingen af lagrede historiske data såvel som realtidsdata, efterhånden som de genereres. Som en del af Google Cloud-økosystemet integreres Dataflow problemfrit med andre tjenester som BigQuery, Pub/Sub og Cloud Storage, hvilket giver en omfattende løsning til ETL-opgaver, realtidsanalyse og beregningsmæssige udfordringer. Dens serverløse tilgang betyder, at brugerne ikke behøver at administrere den underliggende infrastruktur, hvilket giver dem mulighed for at fokusere på analysen og indsigten frem for de operationelle aspekter af deres datapipelines.

Hvad gør Google Cloud Dataflow?

Google Cloud Dataflow er designet til at give et skalerbart og serverløst miljø til databehandlingsopgaver. Det gør det muligt for brugere at skabe komplekse ETL-, batch- og streambehandlingspipelines, der kan indtage data fra forskellige kilder, transformere dem i henhold til forretningslogik og derefter indlæse dem i analysemotorer eller databaser til yderligere analyse. Dataflows evne til at håndtere både batch- og realtidsdata gør det alsidigt til en bred vifte af brugssager, fra svindeldetektion i realtid til daglig loganalyse. Tjenesten fjerner leveringen af ressourcer, skalerer automatisk for at imødekomme opgavens krav og giver en række værktøjer til overvågning og optimering af pipelines, der sikrer, at data behandles effektivt og pålideligt.

Google Cloud Dataflow Nøglefunktioner

Unified Stream og Batch Processing: Dataflow tilbyder en enkelt model til behandling af både streaming- og batchdata, hvilket forenkler udvikling af pipeline og giver mulighed for ensartet, mere overskuelig kode.

Serverløs drift: Brugere kan fokusere på kodning frem for infrastruktur, da Dataflow automatisk klargør og administrerer de nødvendige ressourcer.

Automatisk skalering: Tjenesten skalerer ressourcer op eller ned baseret på arbejdsbyrden, hvilket sikrer effektiv behandling uden overprovisionering.

Integration med Google Cloud Services: Dataflow integreres med BigQuery, Pub/Sub og andre Google Cloud-tjenester, hvilket muliggør problemfri dataanalyseløsninger.

Indbygget fejltolerance: Dataflow sikrer ensartede og korrekte resultater, uanset størrelsen af dataene eller kompleksiteten af beregningen, ved at give indbygget fejltolerance.

Developer Tools: Det tilbyder værktøjer til opbygning, fejlretning og overvågning af datapipelines, som hjælper med at opretholde høj ydeevne og pålidelighed.

Google Cloud Dataflow-prisplaner

Google Cloud Dataflow tilbyder en række prisplaner, der er skræddersyet til forskellige brugsmønstre og budgetter. Prisen er baseret på de ressourcer, der forbruges af jobbet, såsom CPU, hukommelse og lager, og faktureres på sekundbasis, hvilket giver detaljeret kontrol over omkostningerne. Brugere skal kontakte salgsteamet for oplysninger om prisplaner:

Dataflow Shuffle: Denne funktion er prissat baseret på mængden af data, der behandles under læse- og skriveoperationer, hvilket er afgørende for operationer, der involverer blande store datasæt.

Fortrolige VM-priser: Dataflow tilbyder fortrolige VM'er til en global pris, hvilket sikrer, at omkostningerne er forudsigelige og ikke varierer fra område til område.

Supplerende ressourcer: Selvom Dataflow-job kan forbruge ressourcer som Cloud Storage, Pub/Sub og BigQuery, faktureres disse separat i henhold til deres specifikke prissætning.

Dataflow Prime: For brugere, der kræver avancerede funktioner og optimeringer, er Dataflow Prime tilgængelig, som inkluderer yderligere priser for funktioner som Persistent Disk, GPU'er og snapshots.

Betaling for Google Cloud Dataflow-tjenester kan foretages ved hjælp af debet- og kreditkort, PayPal og bankoverførsler, hvilket giver fleksibilitet i betalingsmetoder.

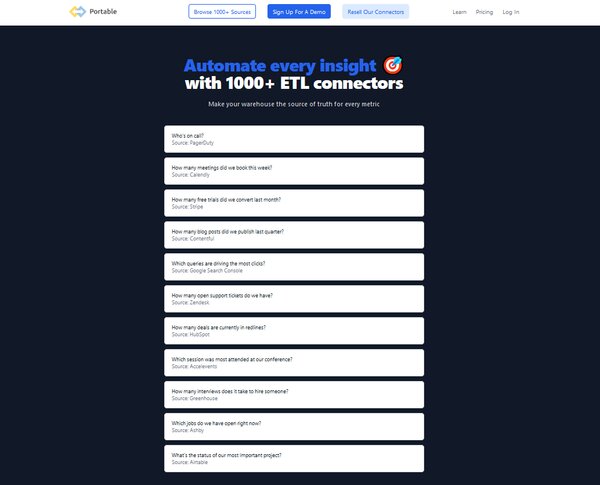

13. Portable

Portable er et cloud-baseret ETL-værktøj designet til at strømline processen med dataintegration for virksomheder. Det forenkler de komplekse og ofte tekniske aspekter af datapipelines, hvilket gør det tilgængeligt for brugere uden omfattende kodningsviden. Portables platform er konstrueret til at styre hele ETL-processen, som omfatter udtrækning af data fra forskellige kilder, transformering af den, så den passer til operationelle behov, og indlæsning af den i et destinationssystem til analyse og business intelligence. Dette værktøj er især fordelagtigt for organisationer, der ønsker at automatisere deres data-workflows og udnytte cloud-infrastrukturen til at håndtere dataudtrækning, datatransformation under flyvningen og dataindlæsning uden behov for at vedligeholde deres egen infrastruktur.

Hvad gør Portable?

Portable leverer en kodefri løsning til oprettelse af datapipelines, der gør det muligt for brugere at oprette forbindelse til over 500 datakilder. Det er designet til at håndtere forviklingerne ved dataoverførselslogik, såsom at foretage API-kald, behandle svar, håndteringsfejl og hastighedsgrænser. Portable tager sig også af datatransformation under flyvningen ved at definere datatyper, oprette skemaer og sikre, at der findes joinnøgler, samt organisere ustrukturerede data til downstream-behov. Platformen er velegnet til virksomheder i alle størrelser, der kræver en pålidelig og skalerbar løsning til integration af deres data på tværs af forskellige systemer og platforme, hvad enten det er til analyse-, rapporterings- eller operationelle formål.

Bærbare nøglefunktioner

Over 500 dataforbindelser: Portable tilbyder et omfattende udvalg af ETL-stik, der giver virksomheder mulighed for problemfrit at integrere data fra en lang række kilder.

Cloud-baseret løsning: Som et cloud-baseret ETL-værktøj er Portable hostet på udbyderens servere, hvilket betyder, at brugere kan få adgang til tjenesten hvor som helst og ikke behøver at bekymre sig om vedligeholdelse af infrastrukturen.

No-Code Interface: Platformen giver en brugervenlig grænseflade uden kode, der gør det nemt for ikke-tekniske brugere at opsætte og administrere datapipelines.

Udvikling af brugerdefinerede konnektorer: For unikke datakilder tillader Portable udvikling af brugerdefinerede stik, hvilket giver fleksibilitet og kontrol over dataintegration.

Fast gebyr prismodel: Portable anvender en attraktiv prismodel med fast gebyr, hvilket gør det nemmere for virksomheder at forudsige deres udgifter uden at bekymre sig om datavolumenlofter.

Realtidsdatatransformation: Evnen til at udføre datatransformation i realtid er en anden nøglefunktion, der sikrer, at data altid er opdaterede og nøjagtige til beslutningsprocesser.

Bærbare prisplaner

Portable tilbyder tre hovedprisplaner for at imødekomme forskellige forretningsbehov:

Starter Plan: Denne plan, prissat til $200 pr. måned, er designet til dem, der lige er startet med dataintegration, og tilbyder 1 planlagt dataflow og funktioner som ubegrænsede datamængder, friskhedsfelter og flowplanlægning hver 24. time.

Skalaplan: Skalaplanen, der er rettet mod virksomheder i vækst, til en pris af 1,000 USD pr. måned, inkluderer op til 10 planlagte dataflows, hyppigere flowplanlægning hvert 15. minut og kommende funktioner som flerbrugerkonti og webhook-meddelelser.

Vækstplan: For virksomheder med omfattende dataintegrationsbehov giver vækstplanen mere end 10 planlagte dataflows, flowplanlægning næsten i realtid og yderligere kommende funktioner såsom admin API-adgang.

Portable accepterer forskellige betalingsmetoder, herunder debet- og kreditkort, PayPal og bankoverførsler, hvilket giver brugerne fleksibilitet til at administrere deres abonnementer.

Ofte stillede spørgsmål om ETL-værktøjer

Hvad er et ETL-værktøj?

Et ETL-værktøj er en softwareapplikation, der bruges til at udtrække, transformere og indlæse data fra forskellige kilder til et datavarehus eller et andet målsystem. Disse værktøjer automatiserer processen med dataintegration, sikrer datakvalitet og konsistens og reducerer den tid og indsats, der kræves for at forberede data til analyse.

Hvorfor er ETL-værktøjer vigtige?

ETL-værktøjer er afgørende i nutidens datadrevne verden, da de automatiserer processen med at udtrække data fra forskellige kilder, transformere dem til et standardiseret format og indlæse dem i et datavarehus. Denne automatisering sparer ikke kun tid og ressourcer, men forbedrer også datakvaliteten og konsistensen, hvilket gør det muligt for virksomheder at træffe datadrevne beslutninger mere effektivt.

Hvordan virker ETL-værktøjer?

ETL-værktøjer fungerer ved at udtrække data fra forskellige kilder, transformere dem til at opfylde de nødvendige kvalitetsstandarder og derefter indlæse dem i et datavarehus eller et andet målsystem. De automatiserer hele denne proces, reducerer fejl og fremskynder dataintegration.

Hvad er nøglefunktionerne ved ETL-værktøjer?

Nøglefunktioner i ETL-værktøjer omfatter understøttelse af flere datakilder, en intuitiv brugergrænseflade til nem datamanipulation og skalerbarhed til at håndtere store mængder data. De bør også levere datakvalitet og profileringsfunktioner, understøttelse af både cloud- og lokale data og være omkostningseffektive.

Hvad er udfordringerne ved at bruge ETL-værktøjer?

Mens ETL-værktøjer tilbyder adskillige fordele, giver de også nogle udfordringer. Disse omfatter behovet for teknisk ekspertise til at opsætte og administrere værktøjerne, håndtering af forskellige datakilder og sikring af datasikkerhed under ETL-processen.

Hvilke typer ETL-værktøjer er tilgængelige?

Der er flere typer ETL-værktøjer tilgængelige, herunder open source-værktøjer, cloud-baserede tjenester og virksomhedssoftware. Valget af værktøj afhænger af organisationens specifikke behov og ressourcer.

Hvordan vælger man det rigtige ETL-værktøj?

Valget af det rigtige ETL-værktøj afhænger af flere faktorer, herunder kompleksiteten af dine datakrav, mængden af data, du skal behandle, typen af datakilder, du arbejder med, og dit budget. Det er også vigtigt at overveje værktøjets brugergrænseflade, skalerbarhed og supporttjenester.

Kan ikke-tekniske brugere bruge ETL-værktøjer?

Ja, mange ETL-værktøjer kommer med grafiske brugergrænseflader, der gør dem tilgængelige for ikke-tekniske brugere. En grundlæggende forståelse af ETL-processer og datastyringsprincipper er dog fordelagtig.

Hvad er fremtiden for ETL-værktøjer?

Fremtiden for ETL-værktøjer ligger i deres evne til at håndtere stadigt mere komplekse datalandskaber, herunder realtidsdatastrømme og forskellige datakilder. Fremskridt inden for kunstig intelligens og maskinlæring forventes også at forbedre ETL-værktøjernes muligheder, hvilket gør dem endnu mere effektive.

Anvendes ETL-værktøjer kun til data warehousing?

Mens ETL-værktøjer almindeligvis bruges i data warehousing, er de ikke begrænset til denne applikation. De kan også bruges til datamigrering, dataintegration og datatransformationsopgaver i forskellige andre sammenhænge.

Konklusion

ETL-værktøjer spiller en central rolle i nutidens datadrevne forretningsmiljø. De strømliner processen med at udtrække, transformere og indlæse data, hvilket gør dem klar til analyse og beslutningstagning. Med deres evne til at håndtere forskellige datakilder og store mængder data er ETL-værktøjer uundværlige for enhver organisation, der sigter mod at udnytte sine data effektivt. Efterhånden som teknologien fortsætter med at udvikle sig, kan vi forvente, at ETL-værktøjer bliver endnu mere kraftfulde og alsidige, hvilket yderligere øger deres værdi for virksomheder.

I en verden af big data er ETL-værktøjer de ubesungne helte. De arbejder bag kulisserne og sikrer, at data er rene, konsistente og klar til analyse. Ved at automatisere komplekse datahåndteringsopgaver frigør de tid og ressourcer, hvilket gør det muligt for virksomheder at fokusere på det, der virkelig betyder noget – at bruge deres data til at drive strategiske beslutninger. Efterhånden som vi bevæger os fremad, vil betydningen af ETL-værktøjer kun blive større, hvilket gør dem til en nøglekomponent i enhver succesfuld datastrategi.